Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrew Ng

Cofundador do Coursera; Faculdade adjunta de Stanford CS. Ex-chefe do Baidu AI Group/Google Brain. #ai #machinelearning, #deeplearning #MOOCs

Estou entusiasmado por anunciar o curso definitivo sobre Claude Code, criado com @AnthropicAI e lecionado por Elie Schoppik @eschoppik. Se você quer usar codificação altamente agentiva - onde a IA trabalha de forma autônoma por muitos minutos ou mais, não apenas completando trechos de código - este é o curso.

Claude Code tem sido um divisor de águas para muitos desenvolvedores (incluindo eu!), mas há uma verdadeira profundidade em usá-lo bem. Este curso abrangente cobre tudo, desde os fundamentos até padrões avançados.

Após este curso curto, você será capaz de:

- Orquestrar múltiplos subagentes Claude para trabalharem em diferentes partes do seu código simultaneamente

- Marcar Claude em problemas do GitHub e fazê-lo criar, revisar e mesclar pull requests de forma autônoma

- Transformar cadernos Jupyter desorganizados em painéis limpos e prontos para produção

- Usar ferramentas MCP como Playwright para que Claude possa ver o que está errado com sua interface e corrigi-lo de forma autônoma

Se você é novo no Claude Code ou já o está usando, descobrirá capacidades poderosas que podem mudar fundamentalmente a forma como você constrói software.

Estou muito animado com o que a codificação agentiva permite que todos façam agora. Por favor, faça este curso!

679,42K

Anunciando um novo curso na Coursera: Geração Aumentada por Recuperação (RAG)

Você aprenderá a construir sistemas RAG de alto desempenho e prontos para produção neste curso prático e aprofundado criado e ministrado por @ZainHasan6, engenheiro de IA e ML experiente, pesquisador e educador.

O RAG é um componente crítico hoje em muitas aplicações baseadas em LLM em suporte ao cliente, sistemas internos de perguntas e respostas da empresa, até mesmo muitos dos principais chatbots que usam busca na web para responder às suas perguntas. Este curso ensina em profundidade como fazer o RAG funcionar bem.

Os LLMs podem produzir respostas genéricas ou desatualizadas, especialmente quando questionados sobre perguntas especializadas que não estão cobertas em seus dados de treinamento. O RAG é a técnica mais amplamente utilizada para abordar isso. Ele traz dados de novas fontes de dados, como documentos internos ou notícias recentes, para fornecer ao LLM o contexto relevante para informações privadas, recentes ou especializadas. Isso permite que ele gere respostas mais fundamentadas e precisas.

Neste curso, você aprenderá a projetar e implementar cada parte de um sistema RAG, desde recuperadores até bancos de dados vetoriais, geração e avaliações. Você aprenderá sobre os princípios fundamentais por trás do RAG e como otimizá-lo tanto a nível de componente quanto a nível de sistema completo.

À medida que a IA evolui, o RAG também está evoluindo. Novos modelos podem lidar com janelas de contexto mais longas, raciocinar de forma mais eficaz e podem ser partes de fluxos de trabalho complexos e agentes. Uma área de crescimento empolgante é o RAG Agente, no qual um agente de IA em tempo de execução (em vez de ser codificado em tempo de desenvolvimento) decide autonomamente quais dados recuperar e quando/como aprofundar. Mesmo com essa evolução, o acesso a dados de alta qualidade em tempo de execução é essencial, razão pela qual o RAG é uma parte chave de tantas aplicações.

Você aprenderá por meio de experiências práticas a:

- Construir um sistema RAG com recuperação e aumento de prompt

- Comparar métodos de recuperação como BM25, busca semântica e Fusão de Classificação Recíproca

- Dividir, indexar e recuperar documentos usando um banco de dados vetorial Weaviate e um conjunto de dados de notícias

- Desenvolver um chatbot, usando LLMs de código aberto hospedados pela Together AI, para uma loja fictícia que responde a perguntas sobre produtos e FAQs

- Usar avaliações para impulsionar a melhoria da confiabilidade e incorporar dados multimodais

O RAG é uma técnica fundamental importante. Torne-se bom nisso através deste curso!

Por favor, inscreva-se aqui:

107,02K

A minha palestra na YC Startup School sobre como construir startups de IA. Partilho dicas do @AI_Fund sobre como usar IA para construir rapidamente. Diga-me o que pensa!

Y Combinator10/07/2025

Andrew Ng (@AndrewYNg) on how startups can build faster with AI.

At AI Startup School in San Francisco.

00:31 - The Importance of Speed in Startups

01:13 - Opportunities in the AI Stack

02:06 - The Rise of Agent AI

04:52 - Concrete Ideas for Faster Execution

08:56 - Rapid Prototyping and Engineering

17:06 - The Role of Product Management

21:23 - The Value of Understanding AI

22:33 - Technical Decisions in AI Development

23:26 - Leveraging Gen AI Tools for Startups

24:05 - Building with AI Building Blocks

25:26 - The Importance of Speed in Startups

26:41 - Addressing AI Hype and Misconceptions

37:35 - AI in Education: Current Trends and Future Directions

39:33 - Balancing AI Innovation with Ethical Considerations

41:27 - Protecting Open Source and the Future of AI

146,5K

A Extração de Documentos Agentic agora suporta a extração de campos! Muitos casos de uso de extração de documentos extraem campos específicos de formulários e outros documentos estruturados. Agora você pode inserir uma imagem ou PDF de uma fatura, solicitar o nome do fornecedor, lista de itens e preços, e receber de volta os campos extraídos. Ou insira um formulário médico e especifique um esquema para extrair o nome do paciente, ID do paciente, número do seguro, etc.

Uma característica interessante: Se você não se sentir à vontade para escrever um esquema (especificação em json do que campos extrair) você mesmo, faça o upload de um documento de amostra e escreva um prompt em linguagem natural dizendo o que você deseja, e nós geramos automaticamente um esquema para você.

Veja o vídeo para mais detalhes!

178,27K

Novo Curso: Pós-treinamento de LLMs

Aprenda a pós-treinar e personalizar um LLM neste curso curto, ministrado por @BanghuaZ, Professor Assistente na Universidade de Washington @UW, e co-fundador da @NexusflowX.

Treinar um LLM para seguir instruções ou responder a perguntas tem duas etapas principais: pré-treinamento e pós-treinamento. No pré-treinamento, ele aprende a prever a próxima palavra ou token a partir de grandes quantidades de texto não rotulado. No pós-treinamento, ele aprende comportamentos úteis, como seguir instruções, uso de ferramentas e raciocínio.

O pós-treinamento transforma um preditor de tokens de uso geral—treinado em trilhões de tokens de texto não rotulados—em um assistente que segue instruções e realiza tarefas específicas. Como é muito mais barato do que o pré-treinamento, é prático para muitas mais equipes incorporar métodos de pós-treinamento em seus fluxos de trabalho do que o pré-treinamento.

Neste curso, você aprenderá três métodos comuns de pós-treinamento—Supervised Fine-Tuning (SFT), Direct Preference Optimization (DPO) e Online Reinforcement Learning (RL)—e como usar cada um deles de forma eficaz. Com SFT, você treina o modelo em pares de entrada e respostas ideais. Com DPO, você fornece tanto uma resposta preferida (escolhida) quanto uma menos preferida (rejeitada) e treina o modelo para favorecer a saída preferida. Com RL, o modelo gera uma saída, recebe uma pontuação de recompensa com base no feedback humano ou automatizado, e atualiza o modelo para melhorar o desempenho.

Você aprenderá os conceitos básicos, casos de uso comuns e princípios para curar dados de alta qualidade para um treinamento eficaz. Através de laboratórios práticos, você fará o download de um modelo pré-treinado do Hugging Face e o pós-treinará usando SFT, DPO e RL para ver como cada técnica molda o comportamento do modelo.

Em detalhes, você:

- Compreenderá o que é o pós-treinamento, quando usá-lo e como ele difere do pré-treinamento.

- Construirá um pipeline SFT para transformar um modelo base em um modelo instrucional.

- Explorar como o DPO remodela o comportamento minimizando a perda contrastiva—penalizando respostas ruins e reforçando as preferidas.

- Implementará um pipeline DPO para mudar a identidade de um assistente de chat.

- Aprenderá métodos de RL online, como Proximal Policy Optimization (PPO) e Group Relative Policy Optimization (GRPO), e como projetar funções de recompensa.

- Treinará um modelo com GRPO para melhorar suas capacidades matemáticas usando uma recompensa verificável.

O pós-treinamento é uma das áreas de treinamento de LLMs que mais se desenvolve rapidamente. Quer você esteja construindo um assistente específico de contexto com alta precisão, ajustando o tom de um modelo ou melhorando a precisão específica de tarefas, este curso lhe dará experiência com as técnicas mais importantes que moldam como os LLMs são pós-treinados hoje.

Por favor, inscreva-se aqui:

109,53K

Gostaria de compartilhar uma dica para obter mais prática na construção com IA — ou seja, usar blocos de construção de IA para criar aplicações ou usar assistência de codificação de IA para criar aplicações poderosas rapidamente: Se você se encontrar com apenas tempo limitado para construir, reduza o escopo do seu projeto até que consiga construir algo no tempo que você tem.

Se você tem apenas uma hora, encontre um pequeno componente de uma ideia que você está animado para construir em uma hora. Com assistentes de codificação modernos como o Claude Code da Anthropic (meu ferramenta de desenvolvimento favorita no momento), você pode se surpreender com o quanto consegue fazer mesmo em curtos períodos de tempo! Isso te coloca em movimento, e você sempre pode continuar o projeto mais tarde.

Para se tornar bom em construir com IA, a maioria das pessoas deve (i) aprender técnicas relevantes, por exemplo, fazendo cursos online de IA, e (ii) praticar a construção. Conheço desenvolvedores que ficam pensando em ideias por meses sem realmente construir nada — eu também já fiz isso! — porque sentimos que não temos tempo para começar. Se você se encontrar nessa posição, encorajo você a continuar cortando o escopo inicial do projeto até identificar um pequeno componente que você pode construir imediatamente.

Deixe-me ilustrar com um exemplo — um dos meus muitos pequenos e divertidos projetos de fim de semana que pode nunca ir a lugar nenhum, mas que estou feliz por ter feito.

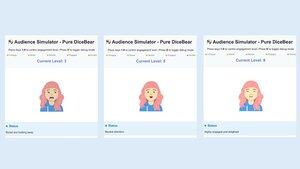

Aqui está a ideia: Muitas pessoas temem falar em público. E falar em público é desafiador de praticar, porque é difícil organizar uma audiência. Então pensei que seria interessante construir um simulador de audiência para fornecer uma audiência digital de dezenas a centenas de pessoas virtuais em um monitor de computador e permitir que um usuário pratique falando com elas.

Em uma tarde de sábado, encontrei-me em uma cafeteria com algumas horas livres e decidi dar uma chance ao simulador de audiência. Minha familiaridade com codificação gráfica é limitada, então, em vez de construir um simulador complexo de uma grande audiência e escrever software de IA para simular respostas apropriadas da audiência, decidi cortar o escopo significativamente para (a) simular uma audiência de uma pessoa (que eu poderia replicar depois para simular N pessoas), (b) omitir a IA e deixar um operador humano selecionar manualmente a reação da audiência simulada (semelhante à prototipagem do Mágico de Oz), e (c) implementar os gráficos usando um simples avatar 2D.

Usando uma mistura de vários assistentes de codificação, construí uma versão básica no tempo que tinha. O avatar podia se mover sutilmente e piscar, mas, de outra forma, usava gráficos básicos. Mesmo que tenha ficado muito aquém de um sofisticado simulador de audiência, estou feliz por ter construído isso. Além de avançar o projeto e me permitir explorar diferentes designs, isso aumentou meu conhecimento sobre gráficos básicos. Além disso, ter esse protótipo rudimentar para mostrar aos amigos me ajudou a obter feedback dos usuários que moldou minhas opiniões sobre a ideia do produto.

Tenho no meu laptop uma lista de ideias de coisas que acho que seriam interessantes de construir. A maioria delas levaria muito mais tempo do que as poucas horas que posso ter para tentar algo em um determinado dia, mas ao cortar seu escopo, consigo começar, e o progresso inicial em um projeto me ajuda a decidir se vale a pena um investimento maior. Como um bônus, trabalhar em uma ampla variedade de aplicações me ajuda a praticar uma ampla gama de habilidades. Mas, mais importante, isso tira uma ideia da minha cabeça e potencialmente a coloca na frente de usuários em potencial para feedback que permite que o projeto avance mais rápido.

[Texto original: ]

295,52K

Novo Curso: ACP: Protocolo de Comunicação de Agentes

Aprenda a construir agentes que comunicam e colaboram através de diferentes estruturas usando o ACP neste curso curto desenvolvido com a BeeAI da @IBMResearch, e ensinado por @sandi_besen, Engenheira de Pesquisa em IA e Líder de Ecossistema na IBM, e @nicholasrenotte, Chefe de Advocacia para Desenvolvedores de IA na IBM.

Construir um sistema multi-agente com agentes construídos ou utilizados por diferentes equipes e organizações pode se tornar desafiador. Você pode precisar escrever integrações personalizadas cada vez que uma equipe atualiza o design de seu agente ou muda sua escolha de estrutura de orquestração de agentes.

O Protocolo de Comunicação de Agentes (ACP) é um protocolo aberto que aborda esse desafio padronizando como os agentes se comunicam, usando uma interface RESTful unificada que funciona em diferentes estruturas. Neste protocolo, você hospeda um agente dentro de um servidor ACP, que gerencia solicitações de um cliente ACP e as encaminha para o agente apropriado. Usar uma interface cliente-servidor padronizada permite que várias equipes reutilizem agentes em projetos. Também facilita a troca entre estruturas, a substituição de um agente por uma nova versão ou a atualização de um sistema multi-agente sem refatorar todo o sistema.

Neste curso, você aprenderá a conectar agentes através do ACP. Você entenderá o ciclo de vida de um Agente ACP e como ele se compara a outros protocolos, como MCP (Protocolo de Contexto de Modelo) e A2A (Agente para Agente). Você construirá agentes compatíveis com ACP e implementará fluxos de trabalho sequenciais e hierárquicos de múltiplos agentes colaborando usando o ACP.

Através de exercícios práticos, você construirá:

- Um agente RAG com CrewAI e o envolverá dentro de um servidor ACP.

- Um Cliente ACP para fazer chamadas ao servidor ACP que você criou.

- Um fluxo de trabalho sequencial que encadeia um servidor ACP, criado com Smolagents, ao agente RAG.

- Um fluxo de trabalho hierárquico usando um agente roteador que transforma consultas de usuários em tarefas, delegadas a agentes disponíveis através de servidores ACP.

- Um agente que usa MCP para acessar ferramentas e ACP para se comunicar com outros agentes.

Você terminará importando seus agentes ACP para a plataforma BeeAI, um registro de código aberto para descobrir e compartilhar agentes.

O ACP permite a colaboração entre agentes de diferentes equipes e organizações. Ao final deste curso, você será capaz de construir agentes e fluxos de trabalho ACP que se comunicam e colaboram independentemente da estrutura.

Por favor, inscreva-se aqui:

88,23K

Apresentando "Construindo com Llama 4." Este curso curto foi criado com @Meta @AIatMeta, e ensinado por @asangani7, Diretor de Engenharia de Parceiros da equipe de IA da Meta.

O novo Llama 4 da Meta adicionou três novos modelos e introduziu a arquitetura Mixture-of-Experts (MoE) à sua família de modelos de pesos abertos, tornando-os mais eficientes para servir.

Neste curso, você trabalhará com dois dos três novos modelos introduzidos no Llama 4. O primeiro é o Maverick, um modelo de 400B parâmetros, com 128 especialistas e 17B parâmetros ativos. O segundo é o Scout, um modelo de 109B parâmetros com 16 especialistas e 17B parâmetros ativos. Maverick e Scout suportam janelas de contexto longo de até um milhão de tokens e 10M tokens, respectivamente. Este último é suficiente para suportar a entrada direta de repositórios GitHub bastante grandes para análise!

Em lições práticas, você construirá aplicativos usando as novas capacidades multimodais do Llama 4, incluindo raciocínio através de várias imagens e ancoragem de imagens, onde você pode identificar elementos em imagens. Você também usará a API oficial do Llama, trabalhará com as habilidades de longo contexto do Llama 4 e aprenderá sobre as mais novas ferramentas de código aberto do Llama: sua ferramenta de otimização de prompts que melhora automaticamente os prompts do sistema e o kit de dados sintéticos que gera conjuntos de dados de alta qualidade para ajuste fino.

Se você precisa de um modelo aberto, o Llama é uma ótima opção, e a família Llama 4 é uma parte importante do kit de ferramentas de qualquer desenvolvedor de GenAI. Através deste curso, você aprenderá a chamar o Llama 4 via API, usar suas ferramentas de otimização e construir recursos que abrangem texto, imagens e grandes contextos.

Por favor, inscreva-se aqui:

57,43K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável