Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrew Ng

Współzałożyciel firmy Coursera; Adiunkt na Uniwersytecie Stanforda. Były szef Baidu AI Group/Google Brain. #ai #machinelearning, #deeplearning #MOOCs

Z radością ogłaszam ostateczny kurs na temat Claude Code, stworzony we współpracy z @AnthropicAI i prowadzony przez Elie Schoppika @eschoppik. Jeśli chcesz korzystać z wysoko agentowego kodowania - gdzie AI działa autonomicznie przez wiele minut lub dłużej, a nie tylko kończy fragmenty kodu - to jest to.

Claude Code był przełomem dla wielu programistów (w tym dla mnie!), ale jest prawdziwa głębia w jego dobrym wykorzystaniu. Ten kompleksowy kurs obejmuje wszystko, od podstaw po zaawansowane wzorce.

Po tym krótkim kursie będziesz w stanie:

- Orkiestracja wielu subagentów Claude'a, aby pracowali nad różnymi częściami twojej bazy kodu jednocześnie

- Oznaczanie Claude'a w problemach GitHub i pozwolenie mu na autonomiczne tworzenie, przeglądanie i scalanie pull requestów

- Przekształcanie chaotycznych notatników Jupyter w czyste, gotowe do produkcji pulpity nawigacyjne

- Używanie narzędzi MCP, takich jak Playwright, aby Claude mógł zobaczyć, co jest nie tak z twoim UI i naprawić to autonomicznie

Niezależnie od tego, czy jesteś nowy w Claude Code, czy już go używasz, odkryjesz potężne możliwości, które mogą fundamentalnie zmienić sposób, w jaki tworzysz oprogramowanie.

Bardzo się cieszę z tego, co agentowe kodowanie pozwala teraz wszystkim robić. Proszę, weź ten kurs!

679,43K

Ogłaszamy nowy kurs na Coursera: Generacja Wzbogacona Odbiorem (RAG)

Nauczysz się budować systemy RAG o wysokiej wydajności, gotowe do produkcji, w tym praktycznym, szczegółowym kursie stworzonym i prowadzonym przez @ZainHasan6, doświadczonego inżyniera AI i ML, badacza oraz nauczyciela.

RAG jest dziś kluczowym elementem wielu aplikacji opartych na LLM w obsłudze klienta, wewnętrznych systemach Q&A w firmach, a nawet w wielu wiodących chatbotach, które wykorzystują wyszukiwanie w sieci do odpowiadania na Twoje pytania. Ten kurs nauczy Cię szczegółowo, jak sprawić, aby RAG działał dobrze.

LLM mogą generować ogólne lub przestarzałe odpowiedzi, szczególnie gdy są zadawane specjalistyczne pytania, które nie są objęte danymi treningowymi. RAG jest najczęściej stosowaną techniką do rozwiązania tego problemu. Wprowadza dane z nowych źródeł, takich jak dokumenty wewnętrzne czy aktualne wiadomości, aby dostarczyć LLM odpowiedni kontekst do prywatnych, niedawnych lub specjalistycznych informacji. Dzięki temu może generować bardziej ugruntowane i dokładne odpowiedzi.

W tym kursie nauczysz się projektować i wdrażać każdą część systemu RAG, od retrieverów po bazy danych wektorowych, generację i ewaluacje. Dowiesz się o podstawowych zasadach stojących za RAG i jak optymalizować go zarówno na poziomie komponentów, jak i całego systemu.

W miarę jak AI się rozwija, RAG również się rozwija. Nowe modele mogą obsługiwać dłuższe okna kontekstowe, skuteczniej rozumować i mogą być częścią złożonych agentowych przepływów pracy. Jednym z ekscytujących obszarów wzrostu jest Agentic RAG, w którym agent AI w czasie rzeczywistym (zamiast być zakodowanym w czasie rozwoju) autonomicznie decyduje, jakie dane pobrać i kiedy/jak zagłębić się w temat. Nawet przy tej ewolucji dostęp do wysokiej jakości danych w czasie rzeczywistym jest niezbędny, dlatego RAG jest kluczowym elementem tak wielu aplikacji.

Nauczysz się poprzez praktyczne doświadczenia:

- Budować system RAG z odbiorem i wzbogaceniem podpowiedzi

- Porównywać metody odbioru, takie jak BM25, wyszukiwanie semantyczne i Reciprocal Rank Fusion

- Dzielić, indeksować i pobierać dokumenty za pomocą bazy danych wektorowej Weaviate i zestawu danych wiadomości

- Rozwijać chatbota, korzystając z otwartych LLM hostowanych przez Together AI, dla fikcyjnego sklepu, który odpowiada na pytania dotyczące produktów i FAQ

- Używać ewaluacji do poprawy niezawodności i włączać dane multimodalne

RAG jest ważną techniką podstawową. Stań się w tym dobry dzięki temu kursowi!

Zarejestruj się tutaj:

107,03K

Moja prezentacja na YC Startup School na temat budowania startupów AI. Dzielę się wskazówkami od @AI_Fund, jak wykorzystać AI do szybkiego rozwoju. Dajcie znać, co o tym myślicie!

Y Combinator10 lip 2025

Andrew Ng (@AndrewYNg) o tym, jak startupy mogą szybciej rozwijać się dzięki AI.

Na AI Startup School w San Francisco.

00:31 - Znaczenie szybkości w startupach

01:13 - Możliwości w stosie AI

02:06 - Wzrost Agentów AI

04:52 - Konkretne pomysły na szybszą realizację

08:56 - Szybkie prototypowanie i inżynieria

17:06 - Rola zarządzania produktem

21:23 - Wartość zrozumienia AI

22:33 - Decyzje techniczne w rozwoju AI

23:26 - Wykorzystanie narzędzi Gen AI dla startupów

24:05 - Budowanie z bloków budowlanych AI

25:26 - Znaczenie szybkości w startupach

26:41 - Zajmowanie się hype'em AI i nieporozumieniami

37:35 - AI w edukacji: aktualne trendy i przyszłe kierunki

39:33 - Równoważenie innowacji AI z kwestiami etycznymi

41:27 - Ochrona open source i przyszłość AI

146,5K

Ekstrakcja dokumentów Agentic teraz obsługuje ekstrakcję pól! Wiele przypadków użycia ekstrakcji dokumentów wyodrębnia konkretne pola z formularzy i innych zorganizowanych dokumentów. Możesz teraz wprowadzić zdjęcie lub PDF faktury, poprosić o nazwę dostawcy, listę przedmiotów i ceny, a następnie otrzymać wyodrębnione pola. Lub wprowadź formularz medyczny i określ schemat, aby wyodrębnić imię pacjenta, identyfikator pacjenta, numer ubezpieczenia itp.

Jedna fajna funkcja: Jeśli nie masz ochoty samodzielnie pisać schematu (specyfikacja json tego, co należy wyodrębnić), prześlij jeden przykładowy dokument i napisz naturalny językowy prompt, mówiąc, czego chcesz, a my automatycznie wygenerujemy schemat dla Ciebie.

Zobacz film, aby uzyskać szczegóły!

178,27K

Nowy kurs: Post-trening LLM-ów

Naucz się post-trenować i dostosować LLM w tym krótkim kursie, prowadzonym przez @BanghuaZ, adiunkta na Uniwersytecie Waszyngtońskim @UW oraz współzałożyciela @NexusflowX.

Trenowanie LLM, aby podążał za instrukcjami lub odpowiadał na pytania, ma dwa kluczowe etapy: pre-trening i post-trening. W pre-treningu uczy się przewidywać następne słowo lub token z dużych ilości nieoznakowanego tekstu. W post-treningu uczy się użytecznych zachowań, takich jak podążanie za instrukcjami, korzystanie z narzędzi i rozumowanie.

Post-trening przekształca ogólny predyktor tokenów—wytrenowany na trylionach nieoznakowanych tokenów tekstowych—w asystenta, który podąża za instrukcjami i wykonuje konkretne zadania. Ponieważ jest znacznie tańszy niż pre-trening, jest praktyczny dla znacznie większej liczby zespołów, aby włączyć metody post-treningowe do swoich procesów roboczych niż metody pre-treningowe.

W tym kursie nauczysz się trzech powszechnych metod post-treningowych—Supervised Fine-Tuning (SFT), Direct Preference Optimization (DPO) i Online Reinforcement Learning (RL)—i jak skutecznie wykorzystać każdą z nich. Przy SFT trenujesz model na parach danych wejściowych i idealnych odpowiedzi. Przy DPO dostarczasz zarówno preferowaną (wybraną), jak i mniej preferowaną (odrzuconą) odpowiedź i trenujesz model, aby faworyzował preferowany wynik. Przy RL model generuje wynik, otrzymuje ocenę nagrody na podstawie ludzkiej lub zautomatyzowanej informacji zwrotnej i aktualizuje model, aby poprawić wydajność.

Nauczysz się podstawowych pojęć, powszechnych przypadków użycia i zasad kuracji wysokiej jakości danych do skutecznego treningu. Dzięki praktycznym laboratoriom pobierzesz wstępnie wytrenowany model z Hugging Face i przeprowadzisz post-trening przy użyciu SFT, DPO i RL, aby zobaczyć, jak każda technika kształtuje zachowanie modelu.

Szczegółowo nauczysz się:

- Zrozumieć, czym jest post-trening, kiedy go używać i jak różni się od pre-treningu.

- Zbudować pipeline SFT, aby przekształcić model bazowy w model instruktażowy.

- Zbadać, jak DPO przekształca zachowanie, minimalizując stratę kontrastową—karząc słabe odpowiedzi i wzmacniając preferowane.

- Wdrożyć pipeline DPO, aby zmienić tożsamość asystenta czatu.

- Poznać metody online RL, takie jak Proximal Policy Optimization (PPO) i Group Relative Policy Optimization (GRPO), oraz jak projektować funkcje nagród.

- Trenować model z GRPO, aby poprawić jego zdolności matematyczne, korzystając z weryfikowalnej nagrody.

Post-trening jest jednym z najszybciej rozwijających się obszarów treningu LLM. Niezależnie od tego, czy budujesz asystenta kontekstowego o wysokiej dokładności, dostosowujesz ton modelu, czy poprawiasz dokładność w zadaniach specyficznych, ten kurs da ci doświadczenie w najważniejszych technikach kształtujących sposób, w jaki LLM-y są obecnie post-trenowane.

Zarejestruj się tutaj:

109,54K

Chciałbym podzielić się wskazówką, jak zdobyć więcej praktyki w budowaniu z AI — to znaczy, używając bloków budowlanych AI do tworzenia aplikacji lub korzystając z asystentów kodowania AI, aby szybko tworzyć potężne aplikacje: Jeśli masz tylko ograniczony czas na budowanie, zmniejsz zakres swojego projektu, aż będziesz mógł zbudować coś w dowolnym czasie, który masz.

Jeśli masz tylko godzinę, znajdź mały element pomysłu, który cię ekscytuje, a który możesz zbudować w godzinę. Dzięki nowoczesnym asystentom kodowania, takim jak Claude Code od Anthropic (mój ulubiony narzędzie deweloperskie w tej chwili), możesz być zaskoczony, ile możesz zrobić nawet w krótkich okresach czasu! To pozwala ci zacząć, a projekt zawsze możesz kontynuować później.

Aby stać się dobrym w budowaniu z AI, większość ludzi musi (i) nauczyć się odpowiednich technik, na przykład poprzez uczestnictwo w kursach online dotyczących AI, oraz (ii) praktykować budowanie. Znam deweloperów, którzy przez miesiące rozmyślają nad pomysłami, nie budując niczego — ja też to robiłem! — ponieważ czujemy, że nie mamy czasu, aby zacząć. Jeśli znajdziesz się w tej sytuacji, zachęcam cię do dalszego zmniejszania początkowego zakresu projektu, aż zidentyfikujesz mały element, który możesz zbudować od razu.

Pozwól, że zilustruję to przykładem — jednym z wielu moich małych, zabawnych projektów weekendowych, które mogą nigdy nie przynieść efektów, ale cieszę się, że je zrobiłem.

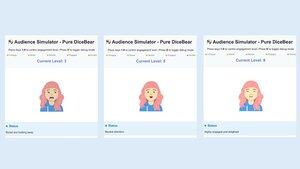

Oto pomysł: Wiele osób boi się wystąpień publicznych. A wystąpienia publiczne są trudne do ćwiczenia, ponieważ trudno zorganizować publiczność. Pomyślałem więc, że interesujące byłoby zbudowanie symulatora publiczności, aby zapewnić cyfrową publiczność składającą się z dziesiątek do setek wirtualnych osób na monitorze komputera i pozwolić użytkownikowi ćwiczyć, mówiąc do nich.

Pewnego sobotniego popołudnia znalazłem się w kawiarni z kilkoma godzinami wolnego czasu i postanowiłem spróbować stworzyć symulator publiczności. Moja znajomość kodowania grafiki jest ograniczona, więc zamiast budować skomplikowany symulator dużej publiczności i pisać oprogramowanie AI do symulacji odpowiednich reakcji publiczności, postanowiłem znacznie zmniejszyć zakres do (a) symulacji publiczności składającej się z jednej osoby (co mogłem później powielić, aby symulować N osób), (b) pominięcia AI i pozwolenia ludzkiemu operatorowi na ręczne wybieranie reakcji symulowanej publiczności (podobnie jak w prototypowaniu Wizard of Oz), oraz (c) wdrożenia grafiki przy użyciu prostego 2D awatara.

Używając mieszanki kilku asystentów kodowania, zbudowałem podstawową wersję w czasie, który miałem. Awatar mógł subtelnie się poruszać i mrugać, ale w przeciwnym razie używał podstawowej grafiki. Mimo że znacznie odbiegał od wyrafinowanego symulatora publiczności, cieszę się, że to zbudowałem. Oprócz posunięcia projektu naprzód i pozwolenia mi na eksplorację różnych projektów, zwiększyło to moją wiedzę na temat podstawowej grafiki. Ponadto posiadanie tego prymitywnego prototypu do pokazania znajomym pomogło mi uzyskać opinie użytkowników, które ukształtowały moje poglądy na temat pomysłu na produkt.

Na moim laptopie mam listę pomysłów na rzeczy, które uważam za interesujące do zbudowania. Większość z nich zajmie znacznie więcej czasu niż garstka godzin, które mogę mieć, aby spróbować czegoś w danym dniu, ale poprzez zmniejszenie ich zakresu mogę zacząć, a początkowy postęp w projekcie pomaga mi zdecydować, czy warto inwestować w to dalej. Dodatkowo, hackowanie na szeroką gamę aplikacji pomaga mi ćwiczyć szeroki zakres umiejętności. Ale najważniejsze jest to, że pozwala to wydobyć pomysł z mojej głowy i potencjalnie pokazać go przyszłym użytkownikom w celu uzyskania opinii, co pozwala projektowi posuwać się szybciej.

295,52K

Nowy kurs: ACP: Protokół komunikacji agentów

Naucz się budować agentów, którzy komunikują się i współpracują w różnych ramach, korzystając z ACP w tym krótkim kursie stworzonym we współpracy z @IBMResearch's BeeAI, prowadzonym przez @sandi_besen, inżyniera badań AI i lidera ekosystemu w IBM, oraz @nicholasrenotte, szefa promocji deweloperów AI w IBM.

Budowanie systemu wieloagentowego z agentami stworzonymi lub używanymi przez różne zespoły i organizacje może być wyzwaniem. Może być konieczne pisanie niestandardowych integracji za każdym razem, gdy zespół aktualizuje projekt swojego agenta lub zmienia wybór ramy orkiestracji agentów.

Protokół komunikacji agentów (ACP) to otwarty protokół, który rozwiązuje ten problem, standaryzując sposób, w jaki agenci się komunikują, korzystając z jednolitego interfejsu RESTful, który działa w różnych ramach. W tym protokole hostujesz agenta wewnątrz serwera ACP, który obsługuje żądania od klienta ACP i przekazuje je do odpowiedniego agenta. Użycie standardowego interfejsu klient-serwer pozwala wielu zespołom ponownie wykorzystywać agentów w różnych projektach. Ułatwia to również przełączanie się między ramami, zastępowanie agenta nową wersją lub aktualizowanie systemu wieloagentowego bez refaktoryzacji całego systemu.

W tym kursie nauczysz się łączyć agentów za pomocą ACP. Zrozumiesz cykl życia agenta ACP i jak porównuje się on z innymi protokołami, takimi jak MCP (Model Context Protocol) i A2A (Agent-to-Agent). Zbudujesz agentów zgodnych z ACP i wdrożysz zarówno sekwencyjne, jak i hierarchiczne przepływy pracy wielu agentów współpracujących za pomocą ACP.

Poprzez praktyczne ćwiczenia zbudujesz:

- Agenta RAG z CrewAI i umieścisz go wewnątrz serwera ACP.

- Klienta ACP, aby wykonywać wywołania do utworzonego przez Ciebie serwera ACP.

- Sekwencyjny przepływ pracy, który łączy serwer ACP, stworzony z Smolagents, z agentem RAG.

- Hierarchiczny przepływ pracy z użyciem agenta routera, który przekształca zapytania użytkowników w zadania, delegowane do agentów dostępnych przez serwery ACP.

- Agenta, który używa MCP do uzyskiwania dostępu do narzędzi i ACP do komunikacji z innymi agentami.

Na koniec zaimportujesz swoich agentów ACP do platformy BeeAI, otwartego rejestru do odkrywania i dzielenia się agentami.

ACP umożliwia współpracę między agentami w różnych zespołach i organizacjach. Pod koniec tego kursu będziesz w stanie budować agentów i przepływy pracy ACP, które komunikują się i współpracują niezależnie od ram.

88,23K

Przedstawiamy "Budowanie z Llama 4." Ten krótki kurs został stworzony we współpracy z @Meta @AIatMeta i prowadzony przez @asangani7, dyrektora ds. inżynierii partnerskiej w zespole AI Meta.

Nowy Llama 4 od Meta dodał trzy nowe modele i wprowadził architekturę Mixture-of-Experts (MoE) do swojej rodziny modeli o otwartych wagach, co czyni je bardziej efektywnymi w obsłudze.

W tym kursie będziesz pracować z dwoma z trzech nowych modeli wprowadzonych w Llama 4. Pierwszy to Maverick, model o 400B parametrach, z 128 ekspertami i 17B aktywnymi parametrami. Drugi to Scout, model o 109B parametrach z 16 ekspertami i 17B aktywnymi parametrami. Maverick i Scout obsługują długie okna kontekstowe do miliona tokenów i 10M tokenów, odpowiednio. To wystarczająco dużo, aby bezpośrednio wprowadzać nawet dość duże repozytoria GitHub do analizy!

W praktycznych lekcjach zbudujesz aplikacje wykorzystujące nowe multimodalne możliwości Llama 4, w tym rozumowanie w oparciu o wiele obrazów oraz identyfikację elementów w obrazach. Będziesz także korzystać z oficjalnego API Llama, pracować z długimi kontekstami Llama 4 i poznasz najnowsze narzędzia open-source Llama: narzędzie do optymalizacji promptów, które automatycznie poprawia systemowe prompty oraz zestaw danych syntetycznych, który generuje wysokiej jakości zbiory danych do fine-tuningu.

Jeśli potrzebujesz otwartego modelu, Llama to świetna opcja, a rodzina Llama 4 jest ważną częścią zestawu narzędzi każdego dewelopera GenAI. Dzięki temu kursowi nauczysz się wywoływać Llama 4 za pomocą API, korzystać z jego narzędzi optymalizacyjnych i budować funkcje obejmujące tekst, obrazy i duży kontekst.

Zarejestruj się tutaj:

57,43K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi