Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kirill Balakhonov | Nethermind

Skapare av AuditAgent | AI x Crypto x Produkt | Att bygga en agentisk ekonomi

Varför släppte OpenAI modeller med öppna vikter? Att ta död på sin egen verksamhet... (eller inte?)

Ja, @OpenAI precis släppt två modeller med öppna vikter, vilket innebär att utvecklare kan använda dem utan att betala OpenAI något. Specifikt släpps den under den mest liberala kommersiella Apache 2.0-licensen. Så varför gjorde OpenAI detta? Det finns flera aspekter.

Men jag vill förtydliga att när ett företag släpper en modell med öppna vikter betyder det inte att modellen är lika öppen källkod som öppen källkod som du kan köra själv, som @Linux operativsystem. Nej, med AI-modeller är det lite annorlunda. I synnerhet är en modell en svart låda, en uppsättning vikter. Och även om du kan testa den på olika uppgifter och se hur den fungerar, om du inte kan återskapa träningsprocessen kan du aldrig veta om det finns några bakdörrar eller säkerhetsbrister som avsiktligt eller oavsiktligt hamnade i den här modellen. Så låt oss separera detta från öppen källkod direkt. Tyvärr kan man inte helt lita på modeller med öppen källkod (de kan dock vara chep).

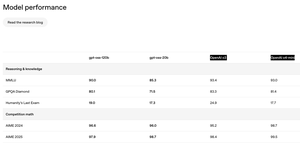

Den andra aspekten jag märkte, som visas på bilden, är att kvaliteten på modeller med öppen källkod inte skiljer sig särskilt mycket från OpenAI:s flaggskeppsmodeller som endast är tillgängliga via API. Det här är fantastiskt! Detta är oväntat! Man skulle kunna tänka sig hur mycket pengar OpenAI skulle kunna förlora på att låta utvecklare använda deras modeller? Detta är dock inte allt. Modeller är inte allt du får när du använder OpenAI via API. När du till exempel använder ChatGPT via UI och väljer o3-modellen finns det faktiskt en komplex agent som arbetar under huven som, när du använder dessa modeller, har massor av logik skriven ovanpå för att verkligen fungera bra med dina dokument och verktyg. Du kommer inte åt dem via dessa modeller som OpenAI publicerat.

Så varför släppte OpenAI modeller med öppna vikter? För det första har deras huvudkonkurrenter, särskilt @Meta, @MistralAI och @deepseek_ai (och @Google), redan släppt konkurrenskraftiga modeller med öppna vikter som folk använder. Och OpenAI:s popularitet bland människor som använder öppna modeller växer inte. Men för utvecklare som behöver båda modellerna med öppna vikter (för lokala/privata beräkningar) tillsammans med API-tillgängliga modeller (för svårare saker), om de behöver båda, kan de helt enkelt inte använda OpenAI. Det är lättare för dem att använda sina konkurrenter som Google eller DeepSeek.

För det andra finns det ett betydande tryck från både användare och tillsynsmyndigheter som vill ha mer öppenhet. Människor är oroliga för att AI kan komma att gå överstyr eller hamna under kontroll av en smal grupp företag i Silicon Valley, och människor vill ha mer transparens. Även om jag vågar säga att även om jag bara oroar mig för konkurrens och minskande försäljning, kommer en sådan rörelse mot öppenhet sannolikt att göra OpenAI:s verksamhet ännu större.

Och för det tredje har vi förstås skämtet om OpenAI:s företagsnamn. Att döma av hur allt utvecklades var företaget som heter OpenAI det mest slutna AI-företaget bland ledarna. Det är lustigt i sig, men nu har det blivit ändring på det. Vad tror du?

243

De flesta människor förstår inte alls hur det fungerar att ersätta människor med AI (eller hur det INTE fungerar). Inte ens en tiofaldig acceleration av allt som en specialist gör raderar automatiskt själva jobbet – det skriver bara om ekonomin runt det. När det effektiva priset på en leverra sjunker, blir den latenta efterfrågan som tidigare låg på hyllan plötsligt livskraftig. Jag har aldrig träffat en produktägare som tror att deras ingenjörer levererar fler funktioner än vad färdplanen behöver; Önskelistan är alltid längre än vad personalstyrkan tillåter. Gör varje funktion tio gånger billigare att bygga och du minskar inte teamen med en faktor tio – du lyser upp varje "nice-to-have" som en gång såg oöverkomlig ut, plus hela nya produkter som ingen brydde sig om att omfatta.

En nyligen genomförd @Microsoft Research-studie om verklig användning av Copilot understryker samma sak. Användarna kommer för att få hjälp med att skriva kod eller samla in fakta, men det slutar med att modellen coachar, ger råd och undervisar – och lägger ihop helt nya typer av arbete till en enda session. Yrken är inte monoliter; De är buntar av delprocesser, var och en endast delvis (och ofullständigt) täckt av dagens modeller. I takt med att AI-verktygen utvecklas utvecklas rollens omfattning i takt med dem, och ofta expanderar de snarare än krymper.

Till och med i en AI smart kontraktsrevisor som vi har byggt på @NethermindEth, trots dess namn, riktar vi in oss på en mycket specifik smal del av processen: att hitta potentiella sårbarheter. Samtidigt använder säkerhetsspecialister detta som ett verktyg och gör mycket mer komplext och mångfacetterat arbete – formulerar strategier, validerar resultat, korrigerar AI, lägger till implicit kontext, kommunicerar med utvecklare, upptäcker dolda avsikter och hanterar förväntningar.

Så istället för att räkna vilka jobb som kommer att "försvinna" är det mer användbart att fråga vilka problem som blir värda att lösa när marginalkostnaden för att lösa dem faller från ett stup. Historien visar att svaret är "mycket mer än vi kan bemanna för", och det talar för en framtid där talanger omplaceras och mångfaldigas, inte görs föråldrade.

279

Andrej Karpathy stöder introduktionen av en ny term relaterad till "kontextteknik" inom AI-programvaruutveckling med hjälp av LLM:er.

Och den här termen har länge verkat mycket nödvändig. Varje gång jag förklarar för människor hur vi utvecklar vår Nethermind AuditAgent är en av de viktigaste aspekterna, förutom att använda domänexpertis (web3-säkerhet) och med hjälp av de bästa tillgängliga AI-modellerna (från OpenAI, Anthropic och Google), och verktyg för LLM, just "context engineering".

Det finns ibland ett uttryck som säger att "sammanhanget är kungen", och det är verkligen sant. LLM:er, oavsett om de är stora avancerade eller optimerade små LLM:er, är ett kraftfullt verktyg, men som alla verktyg, om det är i fel händer, får du mycket mindre lovande resultat än du skulle kunna om du arbetar med dem på rätt sätt. Och context management (eller teknik) är verkligen ett komplext och inte särskilt väl beskrivet område som ständigt utvecklas, och det uppstod verkligen som en förlängning av konceptet med snabb teknik, som redan har vissa negativa konnotationer.

Sammantaget listade Andrej de viktigaste aspekterna relaterade till kontextteknik (på den andra skärmdumpen), men i varje specifik uppgift uppnår människor utmärkta resultat till stor del genom försök och misstag, varje gång monotont försöker de välja rätt kontextelement som verkligen behövs i detta skede av problemlösning, samla in riktmärken för varje steg, titta på mätvärden, dela upp datauppsättningar i test, validering och så vidare, och så vidare.

Vad tycker du om "context engineering"?

Andrej Karpathy25 juni 2025

+1 för "kontextteknik" framför "promptteknik".

Folk associerar uppmaningar med korta uppgiftsbeskrivningar som du skulle ge en LLM i din dagliga användning. När i varje LLM-app med industriell styrka är kontextteknik den delikata konsten och vetenskapen att fylla kontextfönstret med precis rätt information för nästa steg. Vetenskap eftersom att göra detta rätt involverar uppgiftsbeskrivningar och förklaringar, några skottexempel, RAG, relaterade (möjligen multimodala) data, verktyg, tillstånd och historia, komprimering ... För lite eller av fel form och LLM har inte rätt sammanhang för optimal prestanda. För mycket eller för irrelevant och LLM-kostnaderna kan gå upp och prestanda kan komma ner. Att göra detta bra är högst icke-trivialt. Och konst på grund av den vägledande intuitionen kring LLM-psykologi av människor, andar.

Utöver själva kontexttekniken måste en LLM-app:

- Bryta upp problem på rätt sätt i styrflöden

- Packa kontextfönstren precis rätt

- skicka samtal till LLM:er av rätt typ och kapacitet

- hantera UIUX-flöden för genereringsverifiering

- Mycket mer - skyddsräcken, säkerhet, evals, parallellitet, prefetching, ...

Så kontextteknik är bara en liten del av ett framväxande tjockt lager av icke-trivial programvara som samordnar enskilda LLM-samtal (och mycket mer) till fullständiga LLM-appar. Termen "ChatGPT wrapper" är trött och riktigt, riktigt fel.

334

Igår lanserade vi en ny produkt – I.R.I.S. (Integrity & Risk Intelligence Scanner), den första AI-agenten på X (tidigare Twitter) som:

• Accepterar en lagringsplats för smarta kontrakt eller adressen till ett distribuerat kontrakt

• Kör koden genom vår SaaS-plattform AuditAgent – redan en marknadsledande lösning som används av externa revisorer och utvecklingsteam

• Publicerar en fullständig sårbarhetsrapport utan att lämna det sociala flödet

Varför?

• En friktionsfri kanal. Utvecklare får en granskning där de redan pratar om kod – inga formulär, inga e-posttrådar.

• AuditAgent under huven. Inte bara en "skanningsmotor", utan vår flaggskeppstjänst som driver verkliga revisioner.

• Insikt på ~30 minuter. Perfekt prioritering innan en djup manuell granskning.

• Boost för att komma ut på marknaden. Twitter-agenten visar upp AuditAgents styrka och leder användare till hela plattformen.

De första 16 timmarna på tidslinjen

✨ 2,7 miljoner visningar

🔥 49 K engagemang

📊 85 % positivt sentiment (214 tweets)

🛠️ ≈150 tweets som delar med sig av praktiska användningsfall

🔍 33 uttryckliga revisioner

📋 38 454 rader kod skannade

⚠️ 377 sårbarheter upptäckta

En personlig anteckning

För exakt ett år sedan gick jag med i Nethermind med vad som lät som en riskabel hypotes: "AI kommer att bli en viktig del av säkerheten för smarta kontrakt, men endast specialiserade, arbetsflödesbaserade verktyg kommer verkligen att hjälpa yrkesverksamma."

Tolv månader senare har vi två produkter i produktion – AuditAgent (och nu I.R.I.S.(@UndercoverIRIS) – och en tydlig inverkan på Web3-säkerheten.

Stort tack till hela @NethermindEth AI-teamet och till @virtuals_io. Uthållighet + en solid hypotes + kombinerad expertis = resultat som branschen kan se.

Vi kommer att fortsätta bygga verktyg som ger säkerhet till utvecklare först – så att Web3 blir säkrare för varje åtagande.

703

Nyss hemkommen från AI Summit London – och Enterprise-AI-landskapet ser väldigt annorlunda ut på nära håll

3 saker som slog mig:

1️⃣ Överfulla produkthyllor.

Varje monter lovade en plug-and-play "AI-plattform" som magiskt passar alla stackar. Men om du går tillräckligt länge på golvet fortsätter du att höra samma blockerare: äldre system utan API:er, utspridda data, otydlig affärslogik. Verkligheten kommer att bli brutal för SaaS som passar alla.

2️⃣ Specialbyggda butiker lyser tyst.

Byråer som kombinerar djup domänrådgivning med snabb anpassad utveckling har en klar fördel. De kan falla in i den röriga mitten, sy ihop saker och skicka något som faktiskt körs inuti en kunds bräckliga infrastruktur.

3️⃣ Anpassat arbete blir billigare, inte dyrare.

Med kodgenmodeller som skriver adaptrar, tester och byggnadsställningar orkestrerar nu seniora utvecklare i stället för att skriva för hand. Vår erfarenhet av att kontinuerligt använda AI-verktyg inom organisationen bekräftar bara detta.

Att ta med sig

Vinnarna inom Enterprise AI kommer inte att vara de flashigaste "out-of-the-box"-agenterna – de kommer att vara de smidiga teamen som kan skapa lösningar tillsammans i realtid, styrda av de röriga begränsningarna i äldre teknik.

230

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda