Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kirill Balakhonov | Nethermind

Twórca AuditAgent | AI x Crypto x Produkt | Budowanie ekonomii agenturalnej

Dlaczego OpenAI wydało modele z otwartymi wagami? Aby zabić własny biznes... (czyż nie?)

Tak, @OpenAI właśnie wydało dwa modele z otwartymi wagami, co oznacza, że deweloperzy mogą z nich korzystać, nie płacąc OpenAI nic. Konkretnie, zostały one wydane na najbardziej liberalnej komercyjnej licencji Apache 2.0. Więc dlaczego OpenAI to zrobiło? Jest kilka aspektów.

Ale chcę wyjaśnić, że kiedy firma wydaje model z otwartymi wagami, nie oznacza to, że model jest tak samo otwartoźródłowy jak kod otwartoźródłowy, który możesz uruchomić samodzielnie, jak system operacyjny @Linux. Nie, w przypadku modeli AI jest to trochę inne. W szczególności model to czarna skrzynka, zestaw wag. I chociaż możesz go testować na różnych zadaniach i zobaczyć, jak działa, jeśli nie możesz odtworzyć procesu treningowego, nigdy nie będziesz wiedział, czy w tym modelu nie ma żadnych tylnych drzwi ani luk bezpieczeństwa, które przypadkowo lub celowo się w nim znalazły. Więc oddzielmy to od otwartego źródła od razu. Niestety, modele z otwartymi wagami nie mogą być w pełni zaufane (choć mogą być tanie).

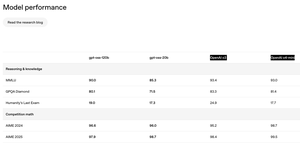

Inny aspekt, który zauważyłem, pokazany na zdjęciu, to to, że jakość modeli otwartoźródłowych nie różni się zbytnio od flagowych modeli OpenAI, które są dostępne tylko przez API. To świetnie! To niespodziewane! Można by pomyśleć, ile pieniędzy OpenAI mogłoby stracić, pozwalając deweloperom korzystać z ich modeli? Jednak to nie wszystko. Modele to nie wszystko, co otrzymujesz, korzystając z OpenAI przez API. Na przykład, gdy korzystasz z ChatGPT przez UI i wybierasz model o3, tak naprawdę działa tam złożony agent, który, korzystając z tych modeli, ma dużo logiki napisanej na górze, aby naprawdę dobrze współpracować z twoimi dokumentami i narzędziami. Nie masz do nich dostępu przez te modele opublikowane przez OpenAI.

Więc dlaczego OpenAI wydało modele z otwartymi wagami? Po pierwsze, ich główni konkurenci, szczególnie @Meta, @MistralAI i @deepseek_ai (o, i @Google), już wydali konkurencyjne modele z otwartymi wagami, z których ludzie korzystają. A popularność OpenAI wśród osób korzystających z otwartych modeli nie rośnie. Jednak dla deweloperów, którzy potrzebują zarówno modeli z otwartymi wagami (do obliczeń lokalnych/prywatnych), jak i modeli dostępnych przez API (do trudniejszych rzeczy), jeśli potrzebują obu, po prostu nie mogą korzystać z OpenAI. Łatwiej jest im korzystać z konkurencji, takiej jak Google czy DeepSeek.

Po drugie, istnieje znaczna presja ze strony zarówno użytkowników, jak i regulatorów, którzy chcą większej otwartości. Ludzie obawiają się, że AI może wymknąć się spod kontroli lub znaleźć się pod kontrolą wąskiej grupy firm w Dolinie Krzemowej, a ludzie chcą większej przejrzystości. Chociaż ośmielam się powiedzieć, że nawet martwiąc się o konkurencję i spadające sprzedaże, taki ruch w kierunku otwartości prawdopodobnie sprawi, że biznes OpenAI stanie się jeszcze większy.

A po trzecie, oczywiście, jest żart o nazwie firmy OpenAI. Sądząc po tym, jak wszystko się rozwijało, firma o nazwie OpenAI była najbardziej zamkniętą firmą AI wśród liderów. To samo w sobie jest zabawne, ale teraz to się zmieniło. Co o tym myślisz?

242

Większość ludzi w ogóle nie rozumie, jak działa zastępowanie ludzi przez AI (lub jak to NIE działa). Nawet dziesięciokrotne przyspieszenie wszystkiego, co robi specjalista, nie usuwa automatycznie samej pracy—po prostu przepisuje ekonomię wokół niej. Gdy efektywna cena dostarczanego produktu spada, ukryty popyt, który wcześniej leżał na półce, nagle staje się opłacalny. Nigdy nie spotkałem właściciela produktu, który uważa, że jego inżynierowie dostarczają więcej funkcji, niż potrzebuje mapa drogowa; lista życzeń zawsze jest dłuższa, niż pozwala na to liczba pracowników. Spraw, aby każda funkcja była dziesięć razy tańsza do zbudowania, a nie zmniejszasz zespołów dziesięciokrotnie—rozświetlasz każdą "miłą do posiadania", która kiedyś wydawała się nieosiągalna, plus całe nowe produkty, które nikt nie miał ochoty zdefiniować.

Niedawne badanie @Microsoft Research dotyczące rzeczywistego użycia Copilota podkreśla tę samą kwestię. Użytkownicy przychodzą po pomoc w pisaniu kodu lub zbieraniu faktów, ale model kończy jako coach, doradca i nauczyciel—łącząc zupełnie nowe rodzaje pracy w jednej sesji. Zawody nie są monolitami; są zbiorami podprocesów, z których każdy jest tylko częściowo (i niedoskonale) pokryty przez dzisiejsze modele. W miarę jak narzędzia AI ewoluują, zakres roli ewoluuje razem z nimi, często się rozszerzając, a nie kurcząc.

Nawet w audytorze inteligentnych kontraktów AI, który zbudowaliśmy w @NethermindEth, mimo jego nazwy, celujemy w bardzo specyficzną, wąską część procesu: znajdowanie potencjalnych luk. Tymczasem specjaliści ds. bezpieczeństwa używają tego jako narzędzia i wykonują znacznie bardziej złożoną i wieloaspektową pracę—formułując strategie, weryfikując ustalenia, korygując AI, dodając kontekst implicitny, komunikując się z deweloperami, odkrywając ukryte intencje i zarządzając oczekiwaniami.

Zamiast więc zliczać, które zawody "znikną", bardziej użyteczne jest zapytanie, jakie problemy stają się warte rozwiązania, gdy marginalny koszt ich rozwiązania spada na dno. Historia sugeruje, że odpowiedź brzmi "znacznie więcej, niż możemy obsadzić", co przemawia za przyszłością, w której talenty są redeployowane i mnożone, a nie stają się przestarzałe.

278

Andrej Karpathy popiera wprowadzenie nowego terminu związanego z "inżynierią kontekstu" w rozwoju oprogramowania AI przy użyciu LLM.

I ten termin od dawna wydaje się bardzo potrzebny. Za każdym razem, gdy wyjaśniam ludziom, jak rozwijamy nasz Nethermind AuditAgent, jednym z kluczowych aspektów, oprócz wykorzystania wiedzy z dziedziny (bezpieczeństwo web3) i używania najlepszych dostępnych modeli AI (od OpenAI, Anthropic i Google) oraz narzędzi dla LLM, jest właśnie "inżynieria kontekstu".

Czasami pojawia się wyrażenie "kontekst jest królem" i to naprawdę prawda. LLM, niezależnie od tego, czy są ogromne i zaawansowane, czy zoptymalizowane małe LLM, są potężnym narzędziem, ale jak każde narzędzie, jeśli jest w niewłaściwych rękach, uzyskasz znacznie mniej obiecujące wyniki, niż mógłbyś, gdybyś pracował z nimi poprawnie. A zarządzanie kontekstem (lub inżynieria) jest rzeczywiście złożonym i niezbyt dobrze opisanym obszarem, który nieustannie się rozwija, a naprawdę wyłonił się jako rozszerzenie koncepcji inżynierii podpowiedzi, która już ma pewne negatywne konotacje.

Ogólnie rzecz biorąc, Andrej wymienił główne aspekty związane z inżynierią kontekstu (na drugim zrzucie ekranu), ale w każdym konkretnym zadaniu ludzie osiągają doskonałe wyniki w dużej mierze dzięki próbom i błędom, za każdym razem monotonnie próbując wybrać odpowiednie elementy kontekstu, które są naprawdę potrzebne na tym etapie rozwiązywania problemu, zbierając benchmarki dla każdego etapu, patrząc na metryki, dzieląc zbiory danych na testowe, walidacyjne i tak dalej.

Co myślisz o "inżynierii kontekstu"?

Andrej Karpathy25 cze 2025

+1 dla "inżynierii kontekstu" w porównaniu do "inżynierii podpowiedzi".

Ludzie kojarzą podpowiedzi z krótkimi opisami zadań, które podajesz LLM w codziennym użytkowaniu. Kiedy w każdej aplikacji LLM o przemysłowej mocy, inżynieria kontekstu to delikatna sztuka i nauka wypełniania okna kontekstowego dokładnie tymi informacjami, które są potrzebne do następnego kroku. Nauka, ponieważ zrobienie tego dobrze wymaga opisów zadań i wyjaśnień, przykładów w małej liczbie, RAG, powiązanych (możliwie multimodalnych) danych, narzędzi, stanu i historii, kompresji... Zbyt mało lub w niewłaściwej formie, a LLM nie ma odpowiedniego kontekstu do optymalnej wydajności. Zbyt dużo lub zbyt nieistotne, a koszty LLM mogą wzrosnąć, a wydajność może spaść. Zrobienie tego dobrze jest wysoce nietrywialne. A sztuka, ponieważ chodzi o intuicję prowadzącą w psychologii LLM i duchach ludzi.

Oprócz samej inżynierii kontekstu, aplikacja LLM musi:

- odpowiednio dzielić problemy na przepływy kontrolne

- odpowiednio pakować okna kontekstowe

- wysyłać wywołania do LLM o odpowiednim rodzaju i możliwościach

- obsługiwać przepływy UIUX generacji-weryfikacji

- wiele więcej - zabezpieczenia, bezpieczeństwo, oceny, równoległość, wstępne pobieranie, ...

Więc inżynieria kontekstu to tylko mały kawałek wschodzącej grubej warstwy nietrywialnego oprogramowania, które koordynuje indywidualne wywołania LLM (i wiele więcej) w pełne aplikacje LLM. Termin "wrapper ChatGPT" jest zmęczony i naprawdę, naprawdę błędny.

333

Wczoraj wprowadziliśmy nowy produkt do produkcji—I.R.I.S. (Integrity & Risk Intelligence Scanner), pierwszy agent AI na X (wcześniej Twitter), który:

• Akceptuje repozytorium smart kontraktów lub adres wdrożonego kontraktu

• Uruchamia kod przez naszą platformę SaaS AuditAgent—już wiodące rozwiązanie na rynku używane przez zewnętrznych audytorów i zespoły deweloperskie

• Publikuje pełny raport o podatnościach bez opuszczania kanału społecznościowego

Dlaczego?

• Bezproblemowy kanał. Deweloperzy otrzymują audyt tam, gdzie już rozmawiają o kodzie—bez formularzy, bez wątków e-mailowych.

• AuditAgent pod maską. Nie tylko „silnik skanujący”, ale nasza flagowa usługa wspierająca audyty w rzeczywistym świecie.

• Wgląd w ~30 minut. Idealna triage przed głębokim przeglądem manualnym.

• Wzrost na rynku. Agent Twittera pokazuje siłę AuditAgent i kieruje użytkowników do pełnej platformy.

Pierwsze 16 godzin na osi czasu

✨ 2,7 M wyświetleń

🔥 49 K interakcji

📊 85 % pozytywnego nastawienia (214 tweetów)

🛠️ ≈150 tweetów dzielących się praktycznymi przypadkami użycia

🔍 33 audyty ekspresowe

📋 38 454 linie kodu zeskanowane

⚠️ 377 wykrytych podatności

Osobista uwaga

Dokładnie rok temu dołączyłem do Nethermind z tym, co brzmiało jak ryzykowna hipoteza: "AI stanie się niezbędną częścią bezpieczeństwa smart kontraktów, ale tylko wyspecjalizowane, natywne narzędzia robocze naprawdę pomogą profesjonalistom."

Dwanaście miesięcy później mamy dwa produkty w produkcji—AuditAgent ( oraz teraz I.R.I.S.(@UndercoverIRIS) —i wyraźny wpływ na bezpieczeństwo Web3.

Ogromne podziękowania dla całego zespołu AI @NethermindEth oraz dla @virtuals_io. Wytrwałość + solidna hipoteza + połączona wiedza = wyniki, które przemysł może zobaczyć.

Będziemy dalej budować narzędzia, które przynoszą bezpieczeństwo deweloperom jako pierwszym—aby Web3 stawało się bezpieczniejsze z każdym commitem.

702

Właśnie wróciłem z AI Summit w Londynie — a krajobraz Enterprise-AI wygląda zupełnie inaczej z bliska.

3 rzeczy, które mnie uderzyły:

1️⃣ Przepełnione półki z produktami.

Każde stoisko obiecywało „platformę AI” gotową do użycia, która magicznie pasuje do każdego stosu. Ale jeśli wystarczająco długo spacerujesz po sali, ciągle słyszysz ten sam problem: systemy dziedziczone bez API, rozproszone dane, niejasna logika biznesowa. Rzeczywistość będzie brutalna dla SaaS, który jest uniwersalny.

2️⃣ Sklepy budujące na zamówienie cicho błyszczą.

Agencje, które łączą głębokie doradztwo w danej dziedzinie z szybkim rozwojem na zamówienie, mają wyraźną przewagę. Mogą wpaść w chaotyczne środkowe obszary, połączyć różne elementy i dostarczyć coś, co naprawdę działa w kruchym infrastrukturze klienta.

3️⃣ Praca na zamówienie staje się tańsza, a nie droższa.

Dzięki modelom generującym kod, które piszą adaptery, testy i szkielet, doświadczeni programiści teraz orkiestrują, zamiast ręcznie pisać. Nasze doświadczenie z ciągłym korzystaniem z narzędzi AI w organizacji tylko to potwierdza.

Wnioski

Zwycięzcami w Enterprise AI nie będą najbardziej efektowne „gotowe do użycia” agenty — będą to zwinne zespoły, które mogą współtworzyć rozwiązania w czasie rzeczywistym, kierując się chaotycznymi ograniczeniami technologii dziedziczonej.

229

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi