Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kirill Balakhonov | Nethermind

Schöpfer von AuditAgent | AI x Crypto x Produkt | Baumittelwirtschaft

Warum hat OpenAI Modelle mit offenen Gewichten veröffentlicht? Um ihr eigenes Geschäft zu ruinieren... (oder nicht?)

Ja, @OpenAI hat gerade zwei Modelle mit offenen Gewichten veröffentlicht, was bedeutet, dass Entwickler sie nutzen können, ohne OpenAI etwas zu zahlen. Genauer gesagt, es wurde unter der liberalsten kommerziellen Apache 2.0 Lizenz veröffentlicht. Warum hat OpenAI das also getan? Es gibt mehrere Aspekte.

Aber ich möchte klarstellen, dass wenn ein Unternehmen ein Modell mit offenen Gewichten veröffentlicht, das nicht bedeutet, dass das Modell so Open Source ist wie Open-Source-Code, den man selbst ausführen kann, wie das @Linux-Betriebssystem. Nein, bei KI-Modellen ist es ein bisschen anders. Insbesondere ist ein Modell eine Black Box, ein Satz von Gewichten. Und während man es bei verschiedenen Aufgaben testen und sehen kann, wie es funktioniert, kann man, wenn man den Trainingsprozess nicht reproduzieren kann, niemals wissen, ob es irgendwelche Hintertüren oder Sicherheitsanfälligkeiten gibt, die absichtlich oder versehentlich in dieses Modell gelangt sind. Lassen Sie uns das also sofort von Open Source trennen. Leider können Modelle mit offenen Gewichten nicht vollständig vertraut werden (sie können jedoch billig sein).

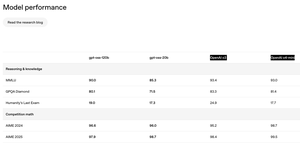

Der andere Aspekt, den ich bemerkt habe, wie im Bild gezeigt, ist, dass die Qualität von Open-Source-Modellen nicht sehr unterschiedlich von den Flaggschiffmodellen von OpenAI ist, die nur über die API verfügbar sind. Das ist großartig! Das ist unerwartet! Man würde denken, wie viel Geld OpenAI verlieren könnte, indem sie Entwicklern erlauben, ihre Modelle zu nutzen? Allerdings ist das nicht alles. Modelle sind nicht alles, was man erhält, wenn man OpenAI über die API nutzt. Zum Beispiel, wenn Sie ChatGPT über die Benutzeroberfläche verwenden und das o3-Modell wählen, gibt es tatsächlich einen komplexen Agenten, der im Hintergrund arbeitet, der, während er diese Modelle verwendet, viel Logik darüber geschrieben hat, um wirklich gut mit Ihren Dokumenten und Werkzeugen zu arbeiten. Sie greifen nicht über diese Modelle zu, die OpenAI veröffentlicht hat.

Warum hat OpenAI also Modelle mit offenen Gewichten veröffentlicht? Erstens, ihre Hauptkonkurrenten, insbesondere @Meta, @MistralAI und @deepseek_ai (oh, und @Google), haben bereits wettbewerbsfähige Modelle mit offenen Gewichten veröffentlicht, die die Leute nutzen. Und die Beliebtheit von OpenAI unter den Menschen, die offene Modelle verwenden, wächst nicht. Für Entwickler, die sowohl Modelle mit offenen Gewichten (für lokale/private Berechnungen) als auch API-zugängliche Modelle (für schwierigere Aufgaben) benötigen, wenn sie beide benötigen, können sie OpenAI einfach nicht nutzen. Es ist einfacher für sie, ihre Konkurrenten wie Google oder DeepSeek zu nutzen.

Zweitens gibt es erheblichen Druck von sowohl Nutzern als auch Regulierungsbehörden, die mehr Offenheit wollen. Die Menschen sind besorgt, dass KI außer Kontrolle geraten oder unter die Kontrolle einer kleinen Gruppe von Unternehmen im Silicon Valley fallen könnte, und die Menschen wollen mehr Transparenz. Obwohl ich wage zu sagen, dass selbst nur die Sorge um Wettbewerb und sinkende Verkaufszahlen, ein solcher Schritt in Richtung Offenheit wahrscheinlich OpenAIs Geschäft noch größer machen wird.

Und drittens gibt es natürlich den Witz über den Firmennamen von OpenAI. Nach dem, wie sich alles entwickelt hat, war das Unternehmen namens OpenAI das geschlossenste KI-Unternehmen unter den führenden. Das ist an sich schon lustig, aber jetzt hat sich das geändert. Was denken Sie?

292

Die meisten Menschen verstehen überhaupt nicht, wie der Ersatz von Menschen durch KI funktioniert (oder wie er NICHT funktioniert). Selbst eine zehnfache Beschleunigung von allem, was ein Spezialist tut, löscht nicht automatisch den Job selbst – sie verändert nur die Wirtschaftlichkeit darum herum. Wenn der effektive Preis eines Liefergegenstands in den Keller fällt, wird die latente Nachfrage, die früher auf dem Regal lag, plötzlich rentabel. Ich habe noch nie einen Produktverantwortlichen getroffen, der denkt, dass seine Ingenieure mehr Funktionen liefern, als der Fahrplan benötigt; die Wunschliste ist immer länger, als es die Anzahl der Mitarbeiter zulässt. Mach jede Funktion zehnmal günstiger zu erstellen, und du kürzt die Teams nicht um den Faktor zehn – du aktivierst jedes "nice-to-have", das einst unerschwinglich schien, plus ganze Greenfield-Produkte, die niemand in Betracht gezogen hat.

Eine aktuelle Studie von @Microsoft Research zur Nutzung von Copilot in der realen Welt unterstreicht denselben Punkt. Die Nutzer kommen, um Hilfe beim Entwerfen von Code oder beim Sammeln von Fakten zu erhalten, aber das Modell endet damit, dass es coacht, berät und lehrt – ganz neue Arten von Arbeit in eine einzige Sitzung integriert. Berufe sind keine Monolithen; sie sind Bündel von Teilprozessen, von denen jeder nur teilweise (und unvollkommen) von den heutigen Modellen abgedeckt wird. Wenn sich KI-Tools weiterentwickeln, entwickelt sich auch der Umfang der Rolle mit ihnen, oft expandierend statt schrumpfend.

Selbst in einem KI-Smart-Contract-Auditor, den wir bei @NethermindEth entwickelt haben, zielen wir trotz seines Namens auf einen sehr spezifischen, engen Teil des Prozesses ab: das Finden potenzieller Schwachstellen. In der Zwischenzeit nutzen Sicherheitsspezialisten dies als Werkzeug und leisten viel komplexere und facettenreichere Arbeit – Strategien formulieren, Ergebnisse validieren, die KI korrigieren, impliziten Kontext hinzufügen, mit Entwicklern kommunizieren, verborgene Absichten entdecken und Erwartungen managen.

Anstatt also zu zählen, welche Jobs "verschwinden" werden, ist es nützlicher zu fragen, welche Probleme es wert sind, gelöst zu werden, sobald die Grenzkosten für deren Lösung in den Keller fallen. Die Geschichte legt nahe, dass die Antwort "weit mehr, als wir besetzen können" ist, und das spricht für eine Zukunft, in der Talente umverteilt und vervielfacht werden, nicht obsolet gemacht.

325

Andrej Karpathy unterstützt die Einführung eines neuen Begriffs im Zusammenhang mit "Kontextengineering" in der KI-Softwareentwicklung unter Verwendung von LLMs.

Und dieser Begriff scheint schon lange sehr notwendig zu sein. Jedes Mal, wenn ich den Leuten erkläre, wie wir unseren Nethermind AuditAgent entwickeln, ist einer der Schlüsselaspekte, neben der Nutzung von Fachwissen (Web3-Sicherheit) und der Verwendung der besten verfügbaren KI-Modelle (von OpenAI, Anthropic und Google) sowie Tools für LLM, genau das "Kontextengineering".

Es gibt manchmal den Ausdruck "Kontext ist König", und das ist wirklich wahr. LLMs, ob riesige fortschrittliche oder optimierte kleine LLMs, sind ein mächtiges Werkzeug, aber wie jedes Werkzeug, wenn es in den falschen Händen ist, erhält man viel weniger vielversprechende Ergebnisse, als man könnte, wenn man richtig mit ihnen arbeitet. Und das Kontextmanagement (oder -engineering) ist in der Tat ein komplexes und nicht sehr gut beschriebenes Gebiet, das sich ständig weiterentwickelt und wirklich als Erweiterung des Konzepts des Prompt-Engineerings entstanden ist, das bereits einige negative Konnotationen hat.

Insgesamt hat Andrej die Hauptaspekte im Zusammenhang mit dem Kontextengineering aufgelistet (auf dem zweiten Screenshot), aber in jeder spezifischen Aufgabe erzielen die Menschen hervorragende Ergebnisse größtenteils durch Versuch und Irrtum, indem sie jedes Mal monoton versuchen, die richtigen Kontextelemente auszuwählen, die in dieser Phase der Problemlösung wirklich benötigt werden, Benchmarks für jede Phase sammeln, Metriken betrachten, Datensätze in Test-, Validierungs- usw. unterteilen und so weiter.

Was haltet ihr von "Kontextengineering"?

Andrej Karpathy25. Juni 2025

+1 für "Kontext-Engineering" gegenüber "Prompt-Engineering".

Die Leute assoziieren Prompts mit kurzen Aufgabenbeschreibungen, die man einem LLM im täglichen Gebrauch geben würde. In jeder industrietauglichen LLM-Anwendung ist Kontext-Engineering jedoch die feine Kunst und Wissenschaft, das Kontextfenster mit genau den richtigen Informationen für den nächsten Schritt zu füllen. Wissenschaft, weil es richtig zu machen, Aufgabenbeschreibungen und Erklärungen, wenige Beispielanfragen, RAG, verwandte (möglicherweise multimodale) Daten, Werkzeuge, Zustand und Geschichte, Komprimierung... erfordert. Zu wenig oder in der falschen Form und das LLM hat nicht den richtigen Kontext für optimale Leistung. Zu viel oder zu irrelevant und die Kosten des LLM könnten steigen und die Leistung könnte sinken. Das gut zu machen, ist äußerst anspruchsvoll. Und Kunst, wegen der leitenden Intuition rund um die Psychologie von LLMs und den Geistern der Menschen.

Neben dem Kontext-Engineering selbst muss eine LLM-Anwendung:

- Probleme genau richtig in Kontrollflüsse aufteilen

- die Kontextfenster genau richtig packen

- Anrufe an LLMs der richtigen Art und Fähigkeit dispatchen

- Generierung-Verifizierung UIUX-Flüsse handhaben

- viel mehr - Sicherheitsvorkehrungen, Sicherheit, Bewertungen, Parallelität, Vorababruf, ...

Kontext-Engineering ist also nur ein kleines Stück eines sich entwickelnden dicken Schicht von anspruchsvoller Software, die individuelle LLM-Anrufe (und viel mehr) in vollständige LLM-Anwendungen koordiniert. Der Begriff "ChatGPT-Wrapper" ist müde und wirklich, wirklich falsch.

382

Gestern haben wir ein neues Produkt in die Produktion gebracht—I.R.I.S. (Integrity & Risk Intelligence Scanner), der erste KI-Agent auf X (ehemals Twitter), der:

• Ein Smart-Contract-Repo oder die Adresse eines bereitgestellten Vertrags akzeptiert

• Den Code über unsere SaaS-Plattform AuditAgent ausführt—bereits eine marktführende Lösung, die von externen Prüfern und Entwicklerteams genutzt wird

• Einen vollständigen Sicherheitsbericht veröffentlicht, ohne den sozialen Feed zu verlassen

Warum?

• Ein reibungsloser Kanal. Entwickler erhalten ein Audit, während sie bereits über Code sprechen—keine Formulare, keine E-Mail-Threads.

• AuditAgent im Hintergrund. Nicht nur eine „Scan-Engine“, sondern unser Flaggschiff-Service, der reale Audits ermöglicht.

• Einblick in ~30 Minuten. Perfekte Triage vor einer tiefen manuellen Überprüfung.

• Markteinführungs-Boost. Der Twitter-Agent zeigt die Stärke von AuditAgent und leitet die Nutzer zur vollständigen Plattform.

Die ersten 16 Stunden auf der Timeline

✨ 2,7 M Impressionen

🔥 49 K Engagements

📊 85 % positive Stimmung (214 Tweets)

🛠️ ≈150 Tweets, die praktische Anwendungsfälle teilen

🔍 33 Express-Audits

📋 38 454 Zeilen Code gescannt

⚠️ 377 entdeckte Schwachstellen

Eine persönliche Anmerkung

Genau vor einem Jahr bin ich zu Nethermind gekommen mit dem, was sich wie eine riskante Hypothese anhörte: "KI wird ein wesentlicher Bestandteil der Sicherheit von Smart Contracts werden, aber nur spezialisierte, workflow-native Tools werden Fachleuten wirklich helfen."

Zwölf Monate später haben wir zwei Produkte in der Produktion—AuditAgent (und jetzt I.R.I.S.(@UndercoverIRIS))—und einen klaren Einfluss auf die Sicherheit von Web3.

Ein riesiges Dankeschön an das gesamte @NethermindEth KI-Team und an @virtuals_io. Beharrlichkeit + eine solide Hypothese + kombinierte Expertise = Ergebnisse, die die Branche sehen kann.

Wir werden weiterhin Tools entwickeln, die Sicherheit zuerst für Entwickler bringen—damit Web3 mit jedem Commit sicherer wird.

751

Gerade zurück vom AI Summit London – und die Enterprise-AI-Landschaft sieht aus der Nähe ganz anders aus.

3 Dinge, die mir aufgefallen sind:

1️⃣ Überfüllte Produktregale.

Jeder Stand versprach eine Plug-and-Play "AI-Plattform", die magisch in jeden Stack passt. Aber wenn man lange genug über die Messe geht, hört man immer wieder dasselbe Hindernis: veraltete Systeme ohne APIs, verstreute Daten, unklare Geschäftslogik. Die Realität wird brutal für SaaS-Lösungen, die für alle passen.

2️⃣ Maßgeschneiderte Shops glänzen leise.

Agenturen, die tiefgehende Fachberatung mit schneller individueller Entwicklung kombinieren, haben einen klaren Vorteil. Sie können in das chaotische Mittelfeld eintauchen, Dinge zusammenfügen und etwas liefern, das tatsächlich in der brüchigen Infrastruktur eines Kunden funktioniert.

3️⃣ Maßgeschneiderte Arbeiten werden günstiger, nicht teurer.

Mit Code-Generierungsmodellen, die Adapter, Tests und Gerüste schreiben, orchestrieren erfahrene Entwickler jetzt, anstatt alles von Hand zu tippen. Unsere Erfahrung, kontinuierlich KI-Tools innerhalb der Organisation zu nutzen, bestätigt dies nur.

Die Erkenntnis

Die Gewinner im Enterprise AI werden nicht die auffälligsten "Out-of-the-Box"-Agenten sein – sie werden die agilen Teams sein, die in Echtzeit Lösungen co-kreieren können, geleitet von den chaotischen Einschränkungen der veralteten Technologie.

280

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten