Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kirill Balakhonov | Nethermind

Maker van AuditAgent | AI x Crypto x Product | Agentische economie opbouwen

Waarom heeft OpenAI modellen met open gewichten vrijgegeven? Om hun eigen bedrijf te killen... (of niet?)

Ja, @OpenAI heeft zojuist twee modellen met open gewichten vrijgegeven, wat betekent dat ontwikkelaars ze kunnen gebruiken zonder OpenAI iets te betalen. Specifiek is het vrijgegeven onder de meest liberale commerciële Apache 2.0-licentie. Dus waarom heeft OpenAI dit gedaan? Er zijn verschillende aspecten.

Maar ik wil verduidelijken dat wanneer een bedrijf een model met open gewichten vrijgeeft, dit niet betekent dat het model net zo open-source is als open-source code die je zelf kunt draaien, zoals het @Linux-besturingssysteem. Nee, met AI-modellen is het een beetje anders. In het bijzonder is een model een black box, een set gewichten. En hoewel je het op verschillende taken kunt testen en kunt zien hoe het werkt, als je het trainingsproces niet kunt reproduceren, zul je nooit weten of er achterdeurtjes of beveiligingskwetsbaarheden zijn die opzettelijk of per ongeluk in dit model zijn beland. Dus laten we dit meteen scheiden van open source. Helaas kunnen modellen met open-source gewichten niet volledig worden vertrouwd (ze kunnen echter goedkoop zijn).

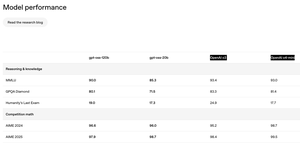

Het andere aspect dat ik opmerkte, zoals te zien is op de afbeelding, is dat de kwaliteit van open-source modellen niet veel verschilt van de vlaggenschipmodellen van OpenAI die alleen via API beschikbaar zijn. Dit is geweldig! Dit is onverwacht! Je zou denken hoeveel geld OpenAI zou kunnen verliezen door ontwikkelaars hun modellen te laten gebruiken? Echter, dit is niet alles. Modellen zijn niet alles wat je krijgt wanneer je OpenAI via API gebruikt. Bijvoorbeeld, wanneer je ChatGPT via de UI gebruikt en het o3-model kiest, is er eigenlijk een complexe agent die op de achtergrond werkt die, terwijl deze modellen worden gebruikt, veel logica heeft geschreven om echt goed samen te werken met jouw documenten en tools. Je krijgt er geen toegang toe via deze modellen die OpenAI heeft gepubliceerd.

Dus waarom heeft OpenAI modellen met open gewichten vrijgegeven? Ten eerste hebben hun belangrijkste concurrenten, met name @Meta, @MistralAI en @deepseek_ai (oh, en @Google), al concurrerende modellen met open gewichten vrijgegeven die mensen gebruiken. En de populariteit van OpenAI onder mensen die open modellen gebruiken, groeit niet. Echter, voor ontwikkelaars die zowel modellen met open gewichten (voor lokale/private berekeningen) als API-toegankelijke modellen (voor moeilijkere dingen) nodig hebben, als ze beide nodig hebben, kunnen ze simpelweg OpenAI niet gebruiken. Het is gemakkelijker voor hen om hun concurrenten zoals Google of DeepSeek te gebruiken.

Ten tweede is er aanzienlijke druk van zowel gebruikers als regelgevers die meer openheid willen. Mensen maken zich zorgen dat AI uit de hand kan lopen of onder controle kan komen van een smalle groep bedrijven in Silicon Valley, en mensen willen meer transparantie. Hoewel ik durf te zeggen dat zelfs alleen al de bezorgdheid over concurrentie en dalende verkopen, zo'n stap naar openheid waarschijnlijk OpenAI's bedrijf nog groter zal maken.

En ten derde is er natuurlijk de grap over de bedrijfsnaam van OpenAI. Afgaande op hoe alles zich heeft ontwikkeld, was het bedrijf genaamd OpenAI het meest gesloten AI-bedrijf onder de leiders. Dit is op zich al grappig, maar nu is dit veranderd. Wat denk jij?

244

De meeste mensen begrijpen helemaal niet hoe de vervanging van mensen door AI werkt (of hoe het NIET werkt). Zelfs een tienvoudige versnelling van alles wat een specialist doet, wist de baan zelf niet automatisch uit—het herschrijft gewoon de economie eromheen. Wanneer de effectieve prijs van een leverbaar product in elkaar stort, wordt latente vraag die eerder op de plank lag ineens levensvatbaar. Ik heb nog nooit een producteigenaar ontmoet die denkt dat hun ingenieurs meer functies leveren dan de roadmap nodig heeft; de verlanglijst is altijd langer dan het aantal medewerkers toelaat. Maak elke functie tien keer goedkoper om te bouwen en je snijdt de teams niet met een factor tien—je activeert elke "nice-to-have" die ooit onbetaalbaar leek, plus hele nieuwe producten waar niemand zich ooit mee bezig heeft gehouden.

Een recente studie van @Microsoft Research over het gebruik van Copilot in de echte wereld onderstreept hetzelfde punt. Gebruikers komen voor hulp bij het opstellen van code of het verzamelen van feiten, maar het model eindigt met coachen, adviseren en onderwijzen—het voegt gloednieuwe soorten arbeid samen in één sessie. Beroepen zijn geen monolieten; het zijn bundels van subprocessen, die elk slechts gedeeltelijk (en onvolmaakt) worden gedekt door de modellen van vandaag. Naarmate AI-tools zich ontwikkelen, evolueert de reikwijdte van de rol met hen mee, vaak uitbreidend in plaats van krimpend.

Zelfs in een AI smart contract auditor die we hebben gebouwd bij @NethermindEth, richten we ons ondanks de naam op een zeer specifiek smal deel van het proces: het vinden van potentiële kwetsbaarheden. Ondertussen gebruiken beveiligingsspecialisten dit als een hulpmiddel en doen ze veel complexer en veelzijdiger werk—strategieën formuleren, bevindingen valideren, de AI corrigeren, impliciete context toevoegen, communiceren met ontwikkelaars, verborgen intenties ontdekken en verwachtingen beheren.

Dus in plaats van te tellen welke banen zullen "verdwijnen," is het nuttiger om te vragen welke problemen het waard worden om op te lossen zodra de marginale kosten om ze op te lossen van de klif vallen. De geschiedenis suggereert dat het antwoord is "veel meer dan we kunnen bemensen," en dat pleit voor een toekomst waarin talent wordt herverdeeld en vermenigvuldigd, niet overbodig wordt gemaakt.

280

Andrej Karpathy ondersteunt de introductie van een nieuwe term gerelateerd aan "context engineering" in de ontwikkeling van AI-software met behulp van LLM's.

En deze term lijkt al lange tijd zeer noodzakelijk. Elke keer als ik mensen uitleg hoe we onze Nethermind AuditAgent ontwikkelen, is een van de belangrijkste aspecten, naast het gebruik van domeinexpertise (web3-beveiliging) en het gebruik van de beste beschikbare AI-modellen (van OpenAI, Anthropic en Google), en tools voor LLM, precies "context engineering".

Er is soms een uitdrukking "context is koning," en dat is echt waar. LLM's, of ze nu enorme geavanceerde zijn of geoptimaliseerde kleine LLM's, zijn een krachtig hulpmiddel, maar zoals elk hulpmiddel, als het in de verkeerde handen is, krijg je veel minder veelbelovende resultaten dan je zou kunnen krijgen als je er correct mee werkt. En contextbeheer (of engineering) is inderdaad een complex en niet erg goed beschreven gebied dat voortdurend evolueert, en het is echt ontstaan als een uitbreiding van het concept van prompt engineering, dat al enkele negatieve connotaties heeft.

Over het algemeen heeft Andrej de belangrijkste aspecten gerelateerd aan context engineering opgesomd (op de tweede screenshot), maar in elke specifieke taak behalen mensen uitstekende resultaten grotendeels door trial and error, elke keer monotoon proberen de juiste contextelementen te selecteren die echt nodig zijn in deze fase van probleemoplossing, benchmarks verzamelen voor elke fase, kijken naar metrics, datasets verdelen in test-, validatie- enzovoort, en ga zo maar door.

Wat vind je van "context engineering"?

Andrej Karpathy25 jun 2025

+1 voor "context engineering" boven "prompt engineering".

Mensen associëren prompts met korte taakbeschrijvingen die je een LLM zou geven in je dagelijkse gebruik. Terwijl in elke industriële LLM-app, context engineering de delicate kunst en wetenschap is van het vullen van het contextvenster met precies de juiste informatie voor de volgende stap. Wetenschap omdat het goed doen hiervan taakbeschrijvingen en uitleg, enkele voorbeelden, RAG, gerelateerde (mogelijk multimodale) gegevens, tools, staat en geschiedenis, compact maken... Te weinig of van de verkeerde vorm en de LLM heeft niet de juiste context voor optimale prestaties. Te veel of te irrelevant en de kosten van de LLM kunnen stijgen en de prestaties kunnen dalen. Dit goed doen is zeer niet-triviaal. En kunst vanwege de leidende intuïtie rond de LLM-psychologie van de geest van mensen.

Bovenop de context engineering zelf, moet een LLM-app:

- problemen precies goed opsplitsen in controleflows

- de contextvensters precies goed inpakken

- oproepen naar LLM's van het juiste soort en capaciteit dispatchen

- generatie-verificatie UIUX-flows afhandelen

- nog veel meer - veiligheidsmaatregelen, beveiliging, evaluaties, parallelisme, prefetching, ...

Dus context engineering is slechts één klein onderdeel van een opkomende dikke laag van niet-triviale software die individuele LLM-oproepen (en veel meer) coördineert in volledige LLM-apps. De term "ChatGPT-wrapper" is moe en echt, echt verkeerd.

335

Gisteren hebben we een nieuw product in productie genomen—I.R.I.S. (Integrity & Risk Intelligence Scanner), de eerste AI-agent op X (voorheen Twitter) die:

• Een smart-contract repo of het adres van een gedeployed contract accepteert

• De code door onze SaaS-platform AuditAgent draait—al een marktleidende oplossing die wordt gebruikt door externe auditors en ontwikkelteams

• Een volledig kwetsbaarheidsrapport publiceert zonder de sociale feed te verlaten

Waarom?

• Een frictievrije kanaal. Ontwikkelaars krijgen een audit waar ze al over code praten—geen formulieren, geen e-mailthreads.

• AuditAgent onder de motorkap. Niet alleen een "scanning engine," maar onze vlaggenschipservice die echte audits aandrijft.

• Inzicht in ~30 minuten. Perfecte triage voor een diepgaande handmatige beoordeling.

• Go-to-market boost. De Twitter-agent toont de kracht van AuditAgent en leidt gebruikers naar het volledige platform.

Eerste 16 uur op de tijdlijn

✨ 2,7 M impressies

🔥 49 K betrokkenheden

📊 85 % positieve sentiment (214 tweets)

🛠️ ≈150 tweets die praktische gebruiksgevallen delen

🔍 33 express audits

📋 38 454 regels code gescand

⚠️ 377 kwetsbaarheden gedetecteerd

Een persoonlijke noot

Precies een jaar geleden ben ik bij Nethermind gekomen met wat klonk als een riskante hypothese: "AI zal een essentieel onderdeel worden van smart-contractbeveiliging, maar alleen gespecialiseerde, workflow-native tools zullen professionals echt helpen."

Twaalf maanden later hebben we twee producten in productie—AuditAgent (en nu I.R.I.S.(@UndercoverIRIS))—en een duidelijke impact op Web3-beveiliging.

Grote dank aan het hele @NethermindEth AI-team en aan @virtuals_io. Volharding + een solide hypothese + gecombineerde expertise = resultaten die de industrie kan zien.

We blijven tools bouwen die beveiliging eerst naar ontwikkelaars brengen—zodat Web3 veiliger wordt met elke commit.

704

Net terug van de AI Summit in Londen—en het Enterprise-AI landschap ziet er van dichtbij heel anders uit.

3 dingen die me opvielen:

1️⃣ Overvolle productrekken.

Elke stand beloofde een plug-and-play “AI-platform” dat magisch in elke stack past. Maar als je lang genoeg over de vloer loopt, hoor je steeds dezelfde blokkade: legacy-systemen zonder API's, verspreide data, onduidelijke bedrijfslogica. De realiteit zal hard zijn voor one-size-fits-all SaaS.

2️⃣ Op maat gemaakte bedrijven stralen stilletjes.

Bureau's die diepgaande domeinconsulting combineren met snelle maatwerkontwikkeling hebben een duidelijk voordeel. Ze kunnen in het rommelige midden duiken, dingen aan elkaar naaien en iets afleveren dat daadwerkelijk draait binnen de kwetsbare infrastructuur van een klant.

3️⃣ Maatwerk wordt goedkoper, niet duurder.

Met code-gen modellen die adapters, tests en scaffolding schrijven, orchestreren senior ontwikkelaars nu in plaats van handmatig te typen. Onze ervaring met het continu gebruiken van AI-tools binnen de organisatie bevestigt dit alleen maar.

De conclusie

De winnaars in Enterprise AI zullen niet de meest flashy “out-of-the-box” agents zijn—het zullen de wendbare teams zijn die in real-time oplossingen kunnen co-creëren, geleid door de rommelige beperkingen van legacy-technologie.

231

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste