Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kirill Balakhonov | Nethermind

Creador de AuditAgent | IA x Cripto x Producto | Construcción de la economía agentica

¿Por qué OpenAI lanzó modelos con pesos abiertos? ¿Para acabar con su propio negocio... (o no?)

Sí, @OpenAI acaba de lanzar dos modelos con pesos abiertos, lo que significa que los desarrolladores pueden usarlos sin pagar nada a OpenAI. Específicamente, se lanzó bajo la licencia comercial más liberal, la Apache 2.0. Entonces, ¿por qué hizo esto OpenAI? Hay varios aspectos.

Pero quiero aclarar que cuando una empresa lanza un modelo con pesos abiertos, no significa que el modelo sea tan de código abierto como el código de código abierto que puedes ejecutar tú mismo, como el sistema operativo @Linux. No, con los modelos de IA es un poco diferente. En particular, un modelo es una caja negra, un conjunto de pesos. Y aunque puedes probarlo en diferentes tareas y ver cómo funciona, si no puedes reproducir el proceso de entrenamiento, nunca podrás saber si hay puertas traseras o vulnerabilidades de seguridad que terminaron dentro de este modelo, ya sea intencional o accidentalmente. Así que separémoslo de inmediato del código abierto. Desafortunadamente, los modelos con pesos de código abierto no pueden ser completamente confiables (aunque pueden ser baratos).

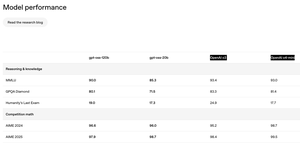

El otro aspecto que noté, mostrado en la imagen, es que la calidad de los modelos de código abierto no es muy diferente de los modelos insignia de OpenAI que solo están disponibles a través de la API. ¡Esto es genial! ¡Esto es inesperado! ¿Pensarías cuánto dinero podría perder OpenAI al permitir que los desarrolladores usen sus modelos? Sin embargo, esto no es todo. Los modelos no son todo lo que obtienes al usar OpenAI a través de la API. Por ejemplo, cuando usas ChatGPT a través de la interfaz de usuario y eliges el modelo o3, en realidad hay un agente complejo trabajando en segundo plano que, mientras usa estos modelos, tiene mucha lógica escrita encima para realmente funcionar bien con tus documentos y herramientas. No accedes a ellos a través de estos modelos que OpenAI publicó.

Entonces, ¿por qué OpenAI lanzó modelos con pesos abiertos? Primero, sus principales competidores, particularmente @Meta, @MistralAI y @deepseek_ai (oh, y @Google), ya han lanzado modelos competitivos con pesos abiertos que la gente usa. Y la popularidad de OpenAI entre las personas que usan modelos abiertos no está creciendo. Sin embargo, para los desarrolladores que necesitan tanto modelos con pesos abiertos (para cálculos locales/privados) como modelos accesibles a través de la API (para cosas más difíciles), si necesitan ambos, simplemente no pueden usar OpenAI. Es más fácil para ellos usar a sus competidores como Google o DeepSeek.

En segundo lugar, hay una presión significativa tanto de los usuarios como de los reguladores que quieren más apertura. A la gente le preocupa que la IA pueda salirse de control o caer bajo el control de un grupo reducido de empresas en Silicon Valley, y la gente quiere más transparencia. Aunque me atrevería a decir que incluso solo preocupándose por la competencia y la disminución de ventas, tal movimiento hacia la apertura probablemente hará que el negocio de OpenAI sea aún más grande.

Y en tercer lugar, por supuesto, está la broma sobre el nombre de la empresa OpenAI. A juzgar por cómo se desarrolló todo, la empresa llamada OpenAI era la empresa de IA más cerrada entre los líderes. Esto es divertido en sí mismo, pero ahora esto ha cambiado. ¿Qué piensas?

245

La mayoría de las personas no entienden en absoluto cómo funciona el reemplazo de personas por IA (o cómo NO funciona). Incluso una aceleración diez veces mayor de todo lo que hace un especialista no borra automáticamente el trabajo en sí; simplemente reescribe la economía que lo rodea. Cuando el precio efectivo de un entregable se desploma, la demanda latente que solía estar en la estantería de repente se vuelve viable. Nunca he conocido a un propietario de producto que piense que sus ingenieros están entregando más características de las que necesita la hoja de ruta; la lista de deseos siempre es más larga de lo que permite el número de empleados. Haz que cada característica cueste diez veces menos construirla y no reduces los equipos en un factor de diez; enciendes cada "bonito de tener" que antes parecía inasequible, además de productos completamente nuevos que nadie se molestó en definir.

Un estudio reciente de @Microsoft Research sobre el uso del Copilot en el mundo real subraya el mismo punto. Los usuarios vienen en busca de ayuda para redactar código o recopilar hechos, pero el modelo termina entrenando, asesorando y enseñando, incorporando nuevos tipos de trabajo en una sola sesión. Las profesiones no son monolitos; son conjuntos de subprocessos, cada uno cubierto solo parcialmente (y de manera imperfecta) por los modelos actuales. A medida que las herramientas de IA evolucionan, el alcance del rol evoluciona con ellas, a menudo expandiéndose en lugar de encogerse.

Incluso en un auditor de contratos inteligentes de IA que hemos construido en @NethermindEth, a pesar de su nombre, nos dirigimos a una parte muy específica y estrecha del proceso: encontrar vulnerabilidades potenciales. Mientras tanto, los especialistas en seguridad utilizan esto como una herramienta y realizan un trabajo mucho más complejo y multifacético: formulando estrategias, validando hallazgos, corrigiendo la IA, añadiendo contexto implícito, comunicándose con los desarrolladores, descubriendo intenciones ocultas y gestionando expectativas.

Así que en lugar de contar qué trabajos "desaparecerán", es más útil preguntar qué problemas se vuelven dignos de resolver una vez que el costo marginal de resolverlos cae en picada. La historia sugiere que la respuesta es "mucho más de lo que podemos dotar de personal", y eso aboga por un futuro donde el talento se redistribuye y multiplica, no se vuelve obsoleto.

281

Andrej Karpathy apoya la introducción de un nuevo término relacionado con "ingeniería de contexto" en el desarrollo de software de IA utilizando LLMs.

Y este término ha parecido muy necesario desde hace tiempo. Cada vez que explico a las personas cómo desarrollamos nuestro Nethermind AuditAgent, uno de los aspectos clave, además de utilizar experiencia en el dominio (seguridad web3) y los mejores modelos de IA disponibles (de OpenAI, Anthropic y Google), y herramientas para LLM, es precisamente "ingeniería de contexto".

A veces hay una expresión que dice "el contexto es el rey", y realmente es cierto. Los LLMs, ya sean enormes avanzados o pequeños LLMs optimizados, son una herramienta poderosa, pero como cualquier herramienta, si está en las manos equivocadas, obtendrás resultados mucho menos prometedores de lo que podrías si trabajas con ellos correctamente. Y la gestión (o ingeniería) del contexto es, de hecho, un área compleja y no muy bien descrita que está en constante evolución, y realmente surgió como una extensión del concepto de ingeniería de prompts, que ya tiene algunas connotaciones negativas.

En general, Andrej enumeró los principales aspectos relacionados con la ingeniería de contexto (en la segunda captura de pantalla), pero en cada tarea específica, las personas logran excelentes resultados en gran medida a través de prueba y error, cada vez intentando monótonamente seleccionar los elementos de contexto correctos que realmente se necesitan en esta etapa de resolución de problemas, recopilando puntos de referencia para cada etapa, observando métricas, dividiendo conjuntos de datos en prueba, validación, y así sucesivamente.

¿Qué opinas sobre "ingeniería de contexto"?

Andrej Karpathy25 jun 2025

+1 por "ingeniería de contexto" en lugar de "ingeniería de indicaciones".

La gente asocia las indicaciones con descripciones de tareas cortas que le darías a un LLM en tu uso diario. Cuando en cada aplicación de LLM de alta capacidad, la ingeniería de contexto es el delicado arte y ciencia de llenar la ventana de contexto con la información justa para el siguiente paso. Ciencia porque hacerlo bien implica descripciones de tareas y explicaciones, ejemplos de pocos disparos, RAG, datos relacionados (posiblemente multimodales), herramientas, estado e historia, compactación... Muy poco o de la forma incorrecta y el LLM no tiene el contexto adecuado para un rendimiento óptimo. Demasiado o demasiado irrelevante y los costos del LLM podrían aumentar y el rendimiento podría disminuir. Hacer esto bien es altamente no trivial. Y arte por la intuición guía en torno a la psicología de los LLM y los espíritus de las personas.

Además de la ingeniería de contexto en sí, una aplicación de LLM tiene que:

- descomponer los problemas de la manera correcta en flujos de control

- empaquetar las ventanas de contexto de la manera correcta

- despachar llamadas a LLMs del tipo y capacidad adecuados

- manejar flujos de UIUX de generación-verificación

- mucho más - barandillas, seguridad, evaluaciones, paralelismo, prefetching, ...

Así que la ingeniería de contexto es solo una pequeña parte de una capa gruesa emergente de software no trivial que coordina llamadas individuales de LLM (y mucho más) en aplicaciones completas de LLM. El término "wrapper de ChatGPT" está cansado y realmente, realmente equivocado.

336

Ayer lanzamos un nuevo producto en producción: I.R.I.S. (Escáner de Inteligencia de Riesgo e Integridad), el primer agente de IA en X (anteriormente Twitter) que:

• Acepta un repositorio de contratos inteligentes o la dirección de un contrato desplegado

• Ejecuta el código a través de nuestra plataforma SaaS AuditAgent, ya una solución líder en el mercado utilizada por auditores externos y equipos de desarrollo

• Publica un informe completo de vulnerabilidades sin salir del feed social

¿Por qué?

• Un canal sin fricciones. Los desarrolladores obtienen una auditoría donde ya están hablando sobre código: sin formularios, sin hilos de correo electrónico.

• AuditAgent bajo el capó. No solo un "motor de escaneo", sino nuestro servicio insignia que potencia auditorías en el mundo real.

• Perspectiva en ~30 minutos. Perfecta para un triaje antes de una revisión manual profunda.

• Impulso para salir al mercado. El agente de Twitter muestra la fortaleza de AuditAgent y canaliza a los usuarios hacia la plataforma completa.

Primeras 16 horas en la línea de tiempo

✨ 2.7 M impresiones

🔥 49 K interacciones

📊 85 % de sentimiento positivo (214 tweets)

🛠️ ≈150 tweets compartiendo casos de uso prácticos

🔍 33 auditorías expresas

📋 38 454 líneas de código escaneadas

⚠️ 377 vulnerabilidades detectadas

Una nota personal

Exactamente hace un año me uní a Nethermind con lo que sonaba como una hipótesis arriesgada: "La IA se convertirá en una parte esencial de la seguridad de los contratos inteligentes, pero solo las herramientas especializadas y nativas del flujo de trabajo ayudarán verdaderamente a los profesionales."

Doce meses después tenemos dos productos en producción: AuditAgent (y ahora I.R.I.S. (@UndercoverIRIS)) —y un impacto claro en la seguridad de Web3.

Un enorme agradecimiento a todo el equipo de IA de @NethermindEth y a @virtuals_io. Persistencia + una hipótesis sólida + experiencia combinada = resultados que la industria puede ver.

Seguiremos construyendo herramientas que traigan seguridad a los desarrolladores primero, para que Web3 sea más seguro con cada commit.

705

Acabo de regresar de la Cumbre de IA en Londres, y el panorama de la IA empresarial se ve muy diferente de cerca.

3 cosas que me impactaron:

1️⃣ Estantes de productos abarrotados.

Cada stand prometía una "plataforma de IA" lista para usar que se adapta mágicamente a cualquier stack. Pero si caminas por el piso el tiempo suficiente, sigues escuchando el mismo obstáculo: sistemas heredados sin APIs, datos dispersos, lógica empresarial poco clara. La realidad será brutal para el SaaS de talla única.

2️⃣ Las tiendas de construcción personalizada brillan en silencio.

Las agencias que combinan una profunda consultoría de dominio con un desarrollo personalizado rápido tienen una clara ventaja. Pueden entrar en el complicado medio, unir las cosas y entregar algo que realmente funcione dentro de la infraestructura frágil de un cliente.

3️⃣ El trabajo personalizado se está volviendo más barato, no más caro.

Con modelos de generación de código escribiendo adaptadores, pruebas y andamiaje, los desarrolladores senior ahora orquestan en lugar de escribir a mano. Nuestra experiencia de usar continuamente herramientas de IA dentro de la organización solo confirma esto.

La conclusión

Los ganadores en la IA empresarial no serán los agentes más llamativos "listos para usar"; serán los equipos ágiles que pueden co-crear soluciones en tiempo real, guiados por las complicadas limitaciones de la tecnología heredada.

232

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado