Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Inventó principios de metaaprendizaje (1987), GAN (1990), Transformers (1991), aprendizaje muy profundo (1991), etc. Nuestra IA se usa muchos miles de millones de veces al día.

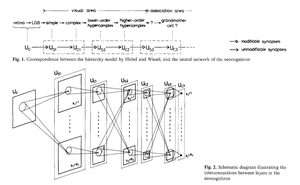

¿Quién inventó las redes neuronales convolucionales (CNN)?

1969: Fukushima tuvo ReLUs relevantes para CNN [2].

1979: Fukushima tuvo la arquitectura básica de CNN con capas de convolución y capas de submuestreo [1]. El costo de computación era 100 veces más caro que en 1989, y mil millones de veces más caro que hoy.

1987: Waibel aplicó la retropropagación de Linnainmaa de 1970 [3] a TDNNs con compartición de pesos y convoluciones unidimensionales [4].

1988: Wei Zhang et al. aplicaron CNNs "modernas" entrenadas por retropropagación en el reconocimiento de caracteres [5].

Todo lo anterior fue publicado en Japón entre 1979 y 1988.

1989: LeCun et al. aplicaron CNNs nuevamente al reconocimiento de caracteres (códigos postales) [6,10].

1990-93: El submuestreo de Fukushima basado en promedios espaciales [1] fue reemplazado por max-pooling para TDNNs unidimensionales (Yamaguchi et al.) [7] y CNNs bidimensionales (Weng et al.) [8].

2011: Mucho más tarde, mi equipo con Dan Ciresan hizo que los CNNs con max-pooling fueran realmente rápidos en GPUs de NVIDIA. En 2011, DanNet logró el primer resultado de reconocimiento de patrones sobrehumano [9]. Durante un tiempo, disfrutó de un monopolio: desde mayo de 2011 hasta septiembre de 2012, DanNet ganó todos los desafíos de reconocimiento de imágenes en los que participó, 4 de ellos consecutivos. Sin embargo, es cierto que esto se debió principalmente a la ingeniería y a escalar las ideas básicas del milenio anterior, beneficiándose de hardware mucho más rápido.

Algunos "expertos en IA" afirman que "hacer que los CNNs funcionen" (por ejemplo, [5,6,9]) fue tan importante como inventarlos. Pero "hacer que funcionen" dependía en gran medida de si tu laboratorio era lo suficientemente rico como para comprar las últimas computadoras necesarias para escalar el trabajo original. Es lo mismo que hoy. Investigación básica vs ingeniería/desarrollo - la R vs la D en I+D.

REFERENCIAS

[1] K. Fukushima (1979). Modelo de red neuronal para un mecanismo de reconocimiento de patrones no afectado por el desplazamiento en la posición — Neocognitron. Trans. IECE, vol. J62-A, no. 10, pp. 658-665, 1979.

[2] K. Fukushima (1969). Extracción de características visuales mediante una red multicapa de elementos umbral analógicos. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Este trabajo introdujo unidades lineales rectificadas (ReLUs), ahora utilizadas en muchas CNNs.

[3] S. Linnainmaa (1970). Tesis de maestría, Univ. Helsinki, 1970. La primera publicación sobre "retropropagación moderna", también conocida como el modo inverso de diferenciación automática. (Ver la conocida visión general de retropropagación de Schmidhuber: "¿Quién inventó la retropropagación?")

[4] A. Waibel. Reconocimiento de fonemas utilizando redes neuronales de retardo temporal. Reunión de IEICE, Tokio, Japón, 1987. Retropropagación para un TDNN con compartición de pesos y convoluciones unidimensionales.

[5] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Red neuronal de reconocimiento de patrones invariante al desplazamiento y su arquitectura óptica. Proc. Conferencia Anual de la Sociedad Japonesa de Física Aplicada, 1988. Primer CNN bidimensional entrenado por retropropagación, con aplicaciones al reconocimiento de caracteres en inglés.

[6] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel: Retropropagación aplicada al reconocimiento de códigos postales manuscritos, Neural Computation, 1(4):541-551, 1989. Ver también la Sec. 3 de [10].

[7] K. Yamaguchi, K. Sakamoto, A. Kenji, T. Akabane, Y. Fujimoto. Una red neuronal para el reconocimiento de palabras aisladas independientes del hablante. Primera Conferencia Internacional sobre Procesamiento del Lenguaje Hablado (ICSLP 90), Kobe, Japón, Nov 1990. Un TDNN unidimensional convolucional que utiliza Max-Pooling en lugar del Promedio Espacial de Fukushima [1].

[8] Weng, J., Ahuja, N., y Huang, T. S. (1993). Aprendizaje de reconocimiento y segmentación de objetos 3-D a partir de imágenes 2-D. Proc. 4ta Conferencia Internacional de Visión por Computadora, Berlín, pp. 121-128. Un CNN bidimensional cuyas capas de submuestreo utilizan Max-Pooling (que se ha vuelto muy popular) en lugar del Promedio Espacial de Fukushima [1].

[9] En 2011, el CNN rápido y profundo basado en GPU llamado DanNet (7+ capas) logró el primer rendimiento sobrehumano en un concurso de visión por computadora. Ver resumen: "2011: DanNet desencadena la revolución de los CNN profundos."

[10] Cómo 3 ganadores del premio Turing republicaron métodos e ideas clave cuyos creadores no acreditaron. Informe Técnico IDSIA-23-23, Laboratorio de IA Suizo IDSIA, 14 de diciembre de 2023. Ver también el video de YouTube de la ceremonia del premio Bower 2021: J. Schmidhuber elogia a Kunihiko Fukushima.

347,19K

¿Quién inventó la retropropagación (BP)? Su versión moderna (también llamada el modo inverso de diferenciación automática) fue publicada por primera vez en 1970 por el estudiante de maestría finlandés Seppo Linnainmaa. Un precursor de BP fue publicado por Henry J. Kelley en 1960. La primera aplicación específica de BP en redes neuronales fue descrita por Paul Werbos en 1982 (pero no en su tesis de 1974, como a veces se afirma).

Algunos preguntan: "¿No es la retropropagación simplemente la regla de la cadena de Leibniz (1676)?" No, es la forma eficiente de aplicar la regla de la cadena a grandes redes con nodos diferenciables. (También hay muchas formas ineficientes de hacer esto.) No se publicó hasta 1970.

Consulta la página web de resumen de retropropagación para más detalles:

Consulta también la "Historia Anotada de la IA Moderna y el Aprendizaje Profundo" (2022):

34,71K

IA física hace 10 años: robot bebé inventa sus propios experimentos para mejorar su modelo neural del mundo

Kompella, Stollenga, Luciw, Schmidhuber. Adquisición continua de habilidades impulsada por la curiosidad a partir de entradas de video de alta dimensión para robots humanoides. Inteligencia Artificial, 2015

10,91K

Hace 1 década: Ingeniero de Prompts de Aprendizaje por Refuerzo en la Sec. 5.3 de «Aprender a pensar...» [2]. ¡Cadena de pensamiento adaptativa! Una red de RL aprende a consultar otra red para el razonamiento abstracto y la toma de decisiones. Ir más allá del Modelo Mundial de 1990 para la planificación milisegundo a milisegundo [1].

[2] J. Schmidhuber (JS, 2015). «Sobre aprender a pensar: teoría algorítmica de la información para combinaciones novedosas de controladores RL y modelos de mundo neuronal recurrentes». ArXiv 1210.0118

[1] JS (1990). «Hacer que el mundo sea diferenciable: sobre el uso de redes neuronales autosupervisadas totalmente recurrentes para el aprendizaje y la planificación de refuerzo dinámico en entornos no estacionarios». TR FKI-126-90, TUM. (Este informe también introdujo la curiosidad artificial y la motivación intrínseca a través de redes generativas antagónicas).

24,18K

10 years ago, in May 2015, we published the first working very deep gradient-based feedforward neural networks (FNNs) with hundreds of layers (previous FNNs had a maximum of a few dozen layers). To overcome the vanishing gradient problem, our Highway Networks used the residual connections first introduced in 1991 by @HochreiterSepp to achieve constant error flow in recurrent NNs (RNNs), gated through multiplicative gates similar to the forget gates (Gers et al., 1999) of our very deep LSTM RNN. Highway NNs were made possible through the work of my former PhD students @rupspace and Klaus Greff. Setting the Highway NN gates to 1.0 effectively gives us the ResNet published 7 months later.

Deep learning is all about NN depth. LSTMs brought essentially unlimited depth to recurrent NNs; Highway Nets brought it to feedforward NNs.

20,89K

1991: primera destilación de redes neuronales [1-3]. Lo llamé "colapsar", en ese entonces, no "destilar".

Referencias

[1] J. Schmidhuber (1991). Fragmentos de secuencias neuronales. Informe técnico FKI-148-91, Universidad Tecnológica de Múnich. Sección 3.2.2. & Sec. 4 tratan sobre "colapsar" o "destilar" o "comprimir" el conocimiento de una red neuronal en otra red neuronal.

[2] JS (1992). Aprendizaje de secuencias complejas y extendidas utilizando el principio de compresión de la historia. Computación neuronal, 4 (2): 234-242, 1992. Basado en [1].

[3] JS (AI Blog, 2021, actualizado en 2025). 1991: Primer aprendizaje muy profundo con pre-entrenamiento no supervisado. Primera destilación de redes neuronales.

16,41K

Todo el mundo habla de la automejora recursiva y de las máquinas de Gödel ahora y de cómo esto conducirá a la AGI. ¡Qué cambio con respecto a hace 15 años! Tuvimos AGI'2010 en Lugano y presidimos AGI'2011 en Google. La columna vertebral de las conferencias de AGI fue la IA universal matemáticamente óptima: la Máquina Gödel de 2003 ( y el AIXI de @mhutter42 - véase su libro UAI de 2005 y su reciente actualización de 2024 ( Estoy orgulloso de que el trabajo de AIXI de Marcus Hutter haya sido financiado por mi beca suiza SNF de 2000 cuando era postdoc en IDSIA.

57,39K

¿AGI? Algún día, pero todavía no. La única IA que funciona bien en este momento es la que está detrás de la pantalla [12-17]. Pero pasar la prueba de Turing [9] detrás de una pantalla es fácil en comparación con la IA real para robots reales en el mundo real. Ningún robot impulsado por IA actual podría certificarse como plomero [13-17]. Por lo tanto, el test de Turing no es una buena medida de la inteligencia (y tampoco lo es el coeficiente intelectual). Y AGI sin dominio del mundo físico no es AGI. Es por eso que creé el TUM CogBotLab para aprender robots en 2004 [5], cofundé una empresa para la IA en el mundo físico en 2014 [6] e hice que los equipos de TUM, IDSIA y ahora KAUST trabajaran en robots bebés [4,10-11,18]. Estos robots blandos no solo imitan servilmente a los humanos y no funcionan simplemente descargando la web como los LLM/VLM. No. En su lugar, explotan los principios de la Curiosidad Artificial para mejorar sus Modelos de Mundo neuronal (dos términos que utilicé en 1990 [1-4]). Estos robots funcionan con muchos sensores, pero solo con actuadores débiles, de modo que no pueden dañarse fácilmente [18] cuando recopilan datos útiles ideando y ejecutando sus propios experimentos inventados por ellos mismos.

Sorprendentemente, desde la década de 1970, muchos se han burlado de mi antiguo objetivo de construir un AGI que se mejore a sí mismo y sea más inteligente que yo y luego retirarme. Recientemente, sin embargo, muchos finalmente han comenzado a tomar esto en serio, y ahora algunos de ellos de repente son DEMASIADO optimistas. Estas personas a menudo desconocen felizmente los desafíos restantes que tenemos que resolver para lograr una IA real. Mi charla TED de 2024 [15] resume algo de eso.

REFERENCIAS (fácil de encontrar en la web):

[1] J. Schmidhuber. Hacer que el mundo sea diferenciable: Sobre el uso de redes neuronales autosupervisadas (NN) totalmente recurrentes para el aprendizaje y la planificación de refuerzos dinámicos en entornos no estacionarios. TR FKI-126-90, TUM, febrero de 1990, revisado en noviembre de 1990. Este artículo también introdujo la curiosidad artificial y la motivación intrínseca a través de redes generativas adversarias donde un generador NN está luchando contra un predictor NN en un juego minimax.

[2] J. S. Una posibilidad para implementar la curiosidad y el aburrimiento en la construcción de modelos de controladores neuronales. En J. A. Meyer y S. W. Wilson, editores, Proc. de la Conferencia Internacional sobre Simulación de Comportamiento Adaptativo: De los Animales a los Animats, páginas 222-227. MIT Press/Bradford Books, 1991. Basado en [1].

[3] Blog de J.S. AI (2020). 1990: Planificación y Aprendizaje por Refuerzo con Modelos Mundiales Recurrentes y Curiosidad Artificial. Resumiendo aspectos de [1][2] y muchos artículos posteriores, incluyendo [7][8].

[4] J.S. AI Blog (2021): Curiosidad artificial y creatividad desde 1990. Resumiendo aspectos de [1][2] y muchos artículos posteriores, incluyendo [7][8].

[5] J.S. TU, Munich, CogBotLab para el aprendizaje de robots (2004-2009)

[6] NNAISENSE, fundada en 2014, para la IA en el mundo físico

[7] J.S. (2015). Sobre aprender a pensar: Teoría algorítmica de la información para combinaciones novedosas de controladores de aprendizaje por refuerzo (RL) y modelos de mundo neuronal recurrentes. arXiv 1210.0118. La sección 5.3 describe a un ingeniero de avisos de RL que aprende a consultar su modelo para el razonamiento abstracto y la planificación y toma de decisiones. Hoy en día, a esto se le llama "cadena de pensamiento".

[8] J.S. (2018). Una gran red para todo. arXiv 1802.08864. Véase también el US11853886B2 de patentes y mi tweet de DeepSeek: DeepSeek utiliza elementos del ingeniero de sugerencias de aprendizaje por refuerzo de 2015 [7] y su refinamiento de 2018 [8] que colapsa la máquina RL y el modelo mundial de [7] en una sola red. Esto utiliza mi procedimiento de destilación de redes neuronales de 1991: una cadena destilada de sistema de pensamiento.

[9] J.S. Turing sobrevendido. Sin embargo, no es culpa de Turing. AI Blog (2021, fue #1 en Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Los robots inteligentes estarán fascinados por la vida). F.A.Z., 2015

[11] J.S. en Falling Walls: El pasado, presente y futuro de la inteligencia artificial. Scientific American, Observaciones, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (La IA es una gran oportunidad para Alemania). F.A.Z., 2018

[13] H. Jones. J.S. dice que el trabajo de su vida no lo llevará a la distopía. Revista Forbes, 2023.

[14] Entrevista con J.S. Jazzyear, Shanghái, 2024.

[15] Charla de J.S. TED en TED AI Viena (2024): Por qué 2042 será un gran año para la IA. Vea el videoclip adjunto.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (¡Construya el robot multipropósito controlado por IA!) F.A.Z., 2024

[17] J.S. 1995-2025: El declive de Alemania y Japón frente a Estados Unidos y China. ¿Pueden los robots polivalentes impulsar un regreso? AI Blog, enero de 2025, basado en [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Hacia un bebé robot extremadamente robusto con una rica capacidad de interacción para algoritmos avanzados de aprendizaje automático. Preimpresión arxiv 2404.08093, 2024.

67,49K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado