Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Vynalezl principy meta-učení (1987), GAN (1990), Transformers (1991), velmi hlubokého učení (1991) atd. Naše umělá inteligence je používána mnoho miliard krát denně.

Kdo vynalezl konvoluční neuronové sítě (CNN)?

1969: Fukušima měla ReLU relevantní pro CNN [2].

1979: Fukušima má základní architekturu CNN s konvolučními vrstvami a vrstvami převzorkování [1]. Výpočetní prostředky byly 100x dražší než v roce 1989 a miliardu x dražší než dnes.

1987: Waibel aplikoval Linnainmaovu zpětnou propagaci z roku 1970 [3] na TDNN se sdílením hmotnosti s 1-dimenzionálními konvolucemi [4].

1988: Wei Zhang et al. aplikovali "moderní" 2-dimenzionální CNN na rozpoznávání znaků [5].

Všechny výše uvedené byly publikovány v Japonsku v letech 1979-1988.

1989: LeCun et al. opět aplikovali CNN na rozpoznávání znaků (PSČ) [6,10].

1990-93: Převzorkování ve Fukušimě založené na prostorovém průměrování [1] bylo nahrazeno maximálním sdružováním pro 1-D TDNN (Yamaguchi et al.) [7] a 2-D CNN (Weng et al.) [8].

2011: Mnohem později můj tým s Danem Ciresanem opravdu zrychlil sdružování CNN na grafických kartách NVIDIA. V roce 2011 dosáhl DanNet prvního nadlidského výsledku rozpoznávání vzorů [9]. Po nějakou dobu se těšil monopolu: od května 2011 do září 2012 DanNet vyhrál každou výzvu v rozpoznávání obrazu, které se zúčastnil, 4 z nich v řadě. Je však pravda, že se jednalo především o inženýrství a rozšíření základních poznatků z minulého tisíciletí, přičemž se těžilo z mnohem rychlejšího hardwaru.

Někteří "experti na umělou inteligenci" tvrdí, že "zajistit, aby CNN fungovaly" (např. [5,6,9]) bylo stejně důležité jako je vymyslet. Ale "zajistit, aby fungovaly" do značné míry záviselo na tom, zda byla vaše laboratoř dostatečně bohatá, aby si mohla koupit nejnovější počítače potřebné k rozšíření původní práce. Je to stejné jako dnes. Základní výzkum vs inženýrství/vývoj - R vs D ve výzkumu a vývoji.

ODKAZY

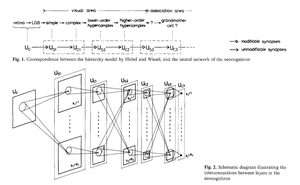

[1] K. Fukušima (1979). Model neuronové sítě pro mechanismus rozpoznávání vzorů neovlivněný změnou polohy — Neocognitron. Přel. IECE, roč. J62-A, č. 10, s. 658-665, 1979.

[2] K. Fukušima (1969). Vizuální extrakce příznaků pomocí vícevrstvé sítě analogových prahových prvků. Transakce IEEE v systémové vědě a kybernetice. 5 (4): 322-333. Tato práce představila rektifikované lineární jednotky (ReLU), které se nyní používají v mnoha CNN.

[3] S. Linnainmaa (1970). Diplomová práce, Univerzita v Helsinkách, 1970. První publikace o "moderním" zpětném šíření, známém také jako reverzní způsob automatické derivace. (Viz Schmidhuberův známý přehled zpětného šíření: "Kdo vynalezl zpětné šíření?")

[4] A. Waibel. Rozpoznávání fonémů pomocí neuronových sítí s časovým zpožděním. Zasedání IEICE, Tokio, Japonsko, 1987. Backpropagation pro TDNN se sdílením hmotnosti s 1-rozměrnými konvolucemi.

[5] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Neuronová síť s invariantním rozpoznáváním obrazů a její optická architektura. Proc. Výroční konference Japonské společnosti aplikované fyziky, 1988. První zpětně naučená 2-dimenzionální CNN, s aplikacemi na rozpoznávání anglických znaků.

[6] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel: Backpropagation Applied to Handwritten Zip Code Recognition, Neural Computation, 1(4):541-551, 1989. Viz také § 3 z [10].

[7] K. Yamaguchi, K. Sakamoto, A. Kenji, T. Akabane, Y. Fujimoto. Neuronová síť pro rozpoznávání izolovaných slov nezávislé na mluvčím. První mezinárodní konference o zpracování mluveného jazyka (ICSLP 90), Kóbe, Japonsko, listopad 1990. 1-dimenzionální konvoluční TDNN využívající Max-Pooling namísto prostorového průměrování ve Fukušimě [1].

[8] Weng, J., Ahuja, N. a Huang, T. S. (1993). Učení rozpoznávání a segmentace 3-D objektů z 2-D obrazů. Proc. 4th Intl. Conf. Computer Vision, Berlín, str. 121-128. Dvourozměrná CNN, jejíž vrstvy převzorkování používají Max-Pooling (který se stal velmi populárním) namísto prostorového průměrování ve Fukušimě [1].

[9] V roce 2011 dosáhla rychlá a hluboká CNN založená na GPU s názvem DanNet (7+ vrstev) prvního nadlidského výkonu v soutěži počítačového vidění. Viz přehled: "2011: DanNet spouští hlubokou revoluci CNN."

[10] Jak 3 držitelé Turingovy ceny znovu publikovali klíčové metody a myšlenky, jejichž tvůrcům nedokázali připsat zásluhy. Technická zpráva IDSIA-23-23, švýcarská laboratoř umělé inteligence IDSIA, 14. prosince 2023. Podívejte se také na video na YouTube ke slavnostnímu předávání Bowerových cen 2021: J. Schmidhuber chválí Kunihiko Fukušimu.

347,22K

Kdo vynalezl zpětné šíření (BP)? Jeho moderní verze (nazývaná také obrácený režim automatické derivace) byla poprvé publikována v roce 1970 finským mistrovským studentem Seppem Linnainmaa. Předchůdce BP byl publikován Henrym J. Kelleym v roce 1960. První aplikace BP specifická pro NN byla popsána Paulem Werbosem v roce 1982 (ale ještě ne ve své diplomové práci z roku 1974, jak se někdy tvrdí).

Někteří se ptají: "Není zpětné šíření jen řetězovým pravidlem Leibnize (1676)?" Ne, je to efektivní způsob aplikace pravidla řetězu na velké sítě s diferencovatelnými uzly. (Existuje také mnoho neefektivních způsobů, jak to udělat.) Publikován byl až v roce 1970.

Další podrobnosti naleznete na webové stránce s přehledem zpětného šíření:

Viz také "Komentovaná historie moderní umělé inteligence a hlubokého učení" (2022):

34,72K

Fyzická umělá inteligence před 10 lety: dětský robot vynalezl vlastní experimenty, aby vylepšil svůj model neuronového světa

Kompella, Stollenga, Luciw, Schmidhuber. Neustálé získávání dovedností poháněné zvědavostí z vysoce dimenzionálních video vstupů pro humanoidní roboty. Umělá inteligence, 2015

10,92K

Před 1 desetiletím: Inženýr posilovaného učení v kapitole 5.3 článku «Učíme se myslet ...» [2]. Adaptivní myšlenkový řetězec! RL síť se učí dotazovat se jiné sítě pro abstraktní uvažování a rozhodování. Překonává světový model z roku 1990 v plánování milisekundy po milisekundách [1].

[2] J. Schmidhuber (JS, 2015). «O učení se myslet: Algoritmická teorie informace pro nové kombinace RL regulátorů a modelů rekurentního neuronového světa.» ArXiv 1210.0118

[1] JS (1990). "Making the world differentiable (Vytváření diferencovatelnosti): O využití plně rekurentních neuronových sítí pod vlastním dohledem pro dynamické zpětnovazební učení a plánování v nestacionárních prostředích." TR FKI-126-90, TUM. (Tato zpráva také představila umělou zvědavost a vnitřní motivaci prostřednictvím generativních nepřátelských sítí.)

24,19K

Před 10 lety, v květnu 2015, jsme publikovali první funkční velmi hluboké dopředné neuronové sítě (FNN) založené na gradientech se stovkami vrstev (předchozí FNN měly maximálně několik desítek vrstev). K překonání problému mizejícího gradientu využily naše dálniční sítě reziduální spojení, která poprvé zavedla v roce 1991 společnost @HochreiterSepp, aby dosáhla konstantního toku chyb v rekurentních NN (RNN), které jsou řízeny multiplikativními hradly podobnými zápoložným hradlům (Gers et al., 1999) našeho velmi hlubokého LSTM RNN. Dálniční sítě byly umožněny díky práci mých bývalých doktorandů @rupspace a Klause Greffa. Nastavením bran Highway NN na 1.0 získáme ResNet zveřejněný o 7 měsíců později.

Hluboké učení je především o hloubce NN. LSTM přinesly v podstatě neomezenou hloubku opakujícím se NN; Highway Nets to přinesly do dopředných NN.

20,9K

1991: První destilace neuronových sítí [1-3]. Tehdy jsem tomu říkal "kolaps", ne "destilace".

Odkazy

[1] J. Schmidhuber (1991). Neuronové sekvence chunkery. Technická zpráva FKI-148-91, Technická univerzita v Mnichově. Oddíl 3.2.2. Oddíl 4 se týká "kolapsu" nebo "destilace" nebo "komprese" znalostí neuronové sítě do jiné neuronové sítě.

[2] JS (1992). Učení složitých, rozšířených sekvencí pomocí principu komprese historie. Neuronové výpočty, 4(2):234-242, 1992. Na základě [1].

[3] JS (AI Blog, 2021, aktualizováno 2025). 1991: První velmi hluboké učení s předtréninkem bez učitele. První destilace neuronových sítí.

16,42K

Všichni nyní mluví o rekurzivním sebezdokonalování a Gödelových strojích a o tom, jak to povede k AGI. Jaká změna oproti době před 15 lety! Měli jsme AGI'2010 v Luganu a předsedali jsme AGI'2011 ve společnosti Google. Páteří konferencí AGI byla matematicky optimální univerzální AI: Gödelův stroj z roku 2003 (a AIXI z roku @mhutter42 - viz jeho kniha UAI z roku 2005 a její nedávná aktualizace z roku 2024 (Jsem hrdý na to, že práce Marcuse Huttera v AIXI byla financována mým švýcarským grantem SNF z roku 2000, když byl postdoktorandem na IDSIA.

57,4K

AGI? Jednoho dne, ale ještě ne. Jediná umělá inteligence, která v současné době funguje dobře, je ta za obrazovkou [12-17]. Ale projít Turingovým testem [9] za obrazovkou je snadné ve srovnání s reálnou umělou inteligencí pro skutečné roboty v reálném světě. Žádný současný robot řízený umělou inteligencí by nemohl být certifikován jako instalatér [13-17]. Turingův test tedy není dobrým měřítkem inteligence (stejně jako IQ). A AGI bez ovládnutí fyzického světa není AGI. Proto jsem v roce 2004 vytvořil TUM CogBotLab pro učící se roboty [5], v roce 2014 jsem spoluzaložil společnost pro umělou inteligenci ve fyzickém světě [6] a nechal jsem týmy v TUM, IDSIA a nyní KAUST pracovat na dětských robotech [4,10-11,18]. Takoví měkcí roboti nejen otrocky napodobují lidi, ale nefungují tak, že si prostě stáhnou web jako LLM/VLM. Místo toho využívají principy umělé zvědavosti ke zlepšení svých neuronových modelů světa (dva termíny, které jsem použil v roce 1990 [1-4]). Tito roboti pracují se spoustou senzorů, ale pouze se slabými aktuátory, takže si nemohou snadno ublížit [18], když shromažďují užitečná data tím, že vymýšlejí a provádějí experimenty, které si sami vymyslí.

Pozoruhodné je, že od roku 1970 si mnozí dělali legraci z mého starého cíle vybudovat sebezdokonalující se AGI, chytřejší než jsem já, a pak odejít do důchodu. V poslední době to však mnozí konečně začali brát vážně a nyní jsou někteří z nich najednou PŘÍLIŠ optimističtí. Tito lidé si často blaženě neuvědomují zbývající výzvy, které musíme vyřešit, abychom dosáhli skutečné umělé inteligence. Moje přednáška na TEDu v roce 2024 [15] něco z toho shrnuje.

REFERENCE (snadno dostupné na webu):

[1] J. Schmidhuber. Making the world differentiable (Vytváření odlišnosti): O používání plně rekurentních neuronových sítí s vlastním dohledem (NN) pro dynamické zpětnovazební učení a plánování v nestacionárních prostředích. TR FKI-126-90, TUM, únor 1990, revidováno v listopadu 1990. Tento článek také představil umělou zvědavost a vnitřní motivaci prostřednictvím generativních adversariálních sítí, kde generátor NN bojuje s prediktorem NN ve hře minimax.

[2] J. S. Možnost implementace zvědavosti a nudy do neuronových kontrolérů vytvářejících modely. In J. A. Meyer a S. W. Wilson, editoři, Proc. Mezinárodní konference o simulaci adaptivního chování: Od zvířat k animatům, strany 222-227. MIT Press/Bradford Books, 1991. Na základě [1].

[3] Blog J.S. AI (2020). 1990: Plánování a zpětnovazební učení s opakujícími se modely světa a umělou zvědavostí. Shrnutí aspektů [1][2] a spousty pozdějších článků včetně [7][8].

[4] J.S. AI Blog (2021): Umělá zvědavost a kreativita od roku 1990. Shrnutí aspektů [1][2] a spousty pozdějších článků včetně [7][8].

[5] J.S. TU Mnichov CogBotLab pro učící se roboty (2004-2009)

[6] NNAISENSE, založený v roce 2014, pro umělou inteligenci ve fyzickém světě

[7] J. S. (2015). O učení se myslet: Algoritmická teorie informace pro nové kombinace ovladačů zpětnovazebního učení (RL) a modelů opakujícího se neuronového světa. arXiv 1210.0118. Oddíl 5.3 popisuje inženýra RL Prompt, který se učí dotazovat se svého modelu na abstraktní uvažování, plánování a rozhodování. Dnes se tomu říká "myšlenkový řetěz".

[8] J. S. (2018). Jedna velká síť na všechno. arXiv 1802.08864. Viz také patentové US11853886B2 a můj tweet DeepSeek: DeepSeek uses elements of 2015 reinforcement learning prompt engineer [7] a jeho vylepšení z roku 2018 [8], které zhroutí RL stroj a model světa [7] do jediné sítě. To využívá můj postup destilace neuronové sítě z roku 1991: destilovaný řetězec myšlenkového systému.

[9] J.S. Turing přeprodaný. Není to však Turingova chyba. AI Blog (2021, byl #1 na Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Inteligentní roboti budou fascinováni životem.) F.A.Z., 2015

[11] J. S. v Falling Walls: The Past, Present and Future of Artificial Intelligence. Scientific American, Pozorování, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (Umělá inteligence je pro Německo obrovskou šancí.) F.A.Z., 2018

[13] H. Jones. J.S. říká, že jeho životní dílo nepovede k dystopii. Časopis Forbes, 2023.

[14] Rozhovor s J. S. Jazzyearem, Šanghaj, 2024.

[15] Přednáška J.S. TEDA na konferenci TED AI ve Vídni (2024): Proč bude rok 2042 velkým rokem pro umělou inteligenci. Podívejte se na přiložený videoklip.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Postavte si univerzálního robota ovládaného umělou inteligencí!) F.A.Z., 2024

[17] J.S. 1995-2025: Úpadek Německa a Japonska vs. USA a Číny. Mohou univerzální roboti podpořit návrat? Blog o umělé inteligenci, leden 2025, na základě [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Směrem k extrémně robustnímu dětskému robotu s bohatou schopností interakce pro pokročilé algoritmy strojového učení. Preprint arxiv 2404.08093, 2024.

67,51K

Top

Hodnocení

Oblíbené

Co je v trendu on-chain

Populární na X

Nejvyšší finanční vklady v poslední době

Nejpozoruhodnější