トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

メタラーニング(1987年)、GAN(1990年)、トランスフォーマー(1991年)、非常にディープラーニング(1991年)などの原理を発明しました。私たちのAIは、毎日何十億回も使用されています。

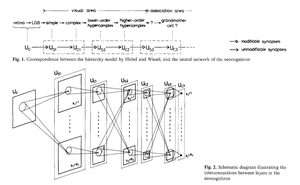

畳み込みニューラルネットワーク(CNN)を発明したのは誰ですか?

1969年:福島にはCNN関連のReLUがありました[2]。

1979年:福島は、畳み込み層とダウンサンプリング層を備えた基本的なCNNアーキテクチャを持っていました[1]。コンピューティングのコストは 1989 年の 100 倍、現在の 10 億倍のコストでした。

1987年:Waibelは、Linnainmaaの1970年のバックプロパゲーション[3]を、1次元畳み込み[4]を持つ重み分担TDNNに適用しました。

1988年:Wei Zhangらは、「最新の」バックプロップトレーニングされた2次元CNNを文字認識に適用しました[5]。

上記はすべて1979年から1988年にかけて日本で出版されたものです。

1989年:LeCunらはCNNを文字認識(郵便番号)に再び適用しました[6,10]。

1990-93: 空間平均に基づく福島のダウンサンプリング [1] は、1 次元 TDNN の最大プーリングに置き換えられました (Yamaguchi et al.)[7] および 2-D CNN (Weng et al.)[8].

2011年:ずっと後、私のチームはDan Ciresanとともに、NVIDIA GPU上で最大プーリングCNNを非常に高速に作成しました。2011年、DanNetは初の超人的なパターン認識結果を達成しました[9]。2011年5月から2012年9月まで、DanNetは参加したすべての画像認識チャレンジで4回連続で優勝しました。しかし、確かに、これは主に、前千年紀の基本的な洞察をエンジニアリングしてスケールアップし、はるかに高速なハードウェアから利益を得ることでした。

一部の「AI専門家」は、「CNNを機能させること」(例:[5,6,9])は、CNNを発明することと同じくらい重要であると主張しています。しかし、「それらを機能させる」かどうかは、研究室が元の研究をスケールアップするために必要な最新のコンピューターを購入できるほど裕福であるかどうかに大きく依存していました。それは今日と同じです。基礎研究とエンジニアリング/開発 - R&DにおけるRとD。

参照

[1] K. 福島 (1979)。位置移動の影響を受けないパターン認識機構のニューラルネットワークモデル ネオコグニトロンIECE、vol. J62-A、no. 10、658-665 ページ、1979 年。

[2] K. 福島 (1969)。アナログしきい値要素の多層ネットワークによる視覚的特徴抽出システム科学とサイバネティクスに関するIEEEトランザクション。5 (4): 322-333.この研究により、現在多くのCNNで使用されている整流線形ユニット(ReLU)が導入されました。

[3] S. リンナインマー (1970)。修士論文、ヘルシンキ大学、1970年。自動微分の逆モードとしても知られる「最新の」バックプロパゲーションに関する最初の出版物。(シュミットフーバーのよく知られたバックプロパゲーションの概要「バックプロパゲーションを発明したのは誰ですか?」を参照してください)

[4] A.ワイベル。時間遅延ニューラルネットワークを用いた音素認識電子情報通信学会大会、東京、日本、1987年。1次元畳み込みによる重み分担TDNNのバックプロパゲーション

[5] W. Zhang、J. Tanida、K. Itoh、Y. Ichioka。シフト不変パターン認識ニューラルネットワークとその光アーキテクチャ応用物理学会大会講演論文集, 1988.英語文字認識への応用による最初のバックプロパゲーション学習2次元CNN

[6] Y. LeCun、B. Boser、JS Denker、D. Henderson、RE Howard、W. Hubbard、LD Jackel: 手書きの郵便番号認識に適用されるバックプロパゲーション、神経計算、1(4):541-551、1989。[10]の第3条も参照してください。

[7] 山口健一郎, 坂本健二, 健二 淳一, 赤羽隆一郎, 藤本祐一.話者に依存しない孤立した単語認識のためのニューラルネットワークFirst International Conference on Spoken Language Processing (ICSLP 90), 神戸, 日本, 1990年11月.福島の空間平均化の代わりにMax-Poolingを使用した1次元畳み込みTDNN[1]。

[8] ウェン、J.、アフジャ、N.、および黄、TS (1993)。2次元画像からの3次元物体の認識とセグメンテーションの学習。Proc. 4th Intl. Conf. Computer Vision, ベルリン, pp. 121-128.ダウンサンプリング層が福島の空間平均化の代わりにMax-Pooling(非常に普及している)を使用する2次元CNN[1]。

[9] 2011年、DanNet(7+層)という高速で深いGPUベースのCNNがコンピュータビジョン公募展で初めて超人的な性能を達成した。概要「2011年:DanNetがCNNの深い革命を引き起こす」を参照してください。

[10] チューリング賞受賞者の3人が、作成者をクレジットしなかった主要な方法とアイデアを再出版した方法。テクニカルレポートIDSIA-23-23、スイスAIラボIDSIA、2023年12月14日。2021年バウアー賞授賞式のYouTubeビデオもご覧ください:J.シュミットフーバーが福島邦彦を称賛しています。

347.2K

バックプロパゲーション(BP)を発明したのは誰ですか?その現代版(自動微分の逆モードとも呼ばれます)は、1970年にフィンランドの修士課程の学生Seppo Linnainmaaによって最初に出版されました。BPの前身は、1960年にヘンリー・J・ケリーによって出版されました。BPの最初のNN固有のアプリケーションは、1982年にPaul Werbosによって説明されました(ただし、時々主張されているように、彼の1974年の論文にはまだ記載されていません)。

「バックプロパゲーションはライプニッツ(1676年)の連鎖法則にすぎないのか?」と尋ねる人もいます。いいえ、これは、微分可能なノードを持つ大規模なネットワークにチェーンルールを適用する効率的な方法です。(これを行う非効率的な方法もたくさんあります。1970年まで出版されませんでした。

詳細については、バックプロパゲーションの概要 Web ページを参照してください。

「現代のAIとディープラーニングの注釈付き歴史」(2022年)も参照してください。

34.71K

10年前:「Learning to Think...」のセクション5.3の強化学習プロンプトエンジニア[2].適応的な思考の連鎖!RLネットは、抽象的な推論と意思決定のために別のネットをクエリすることを学習します。1990年のワールドモデルを超えて、ミリ秒単位の計画[1]。

[2] J.シュミットフーバー(JS、2015年)。«考える学習について:RLコントローラーとリカレントニューラルワールドモデルの新しい組み合わせのためのアルゴリズム情報理論。ArXivの1210.0118

[1] JS(1990)。「世界を微分可能にする:非定常環境での動的強化学習と計画のための完全再帰型自己教師ありニューラルネットワークの使用について」TR FKI-126-90、タム。(このレポートでは、敵対的生成ネットワークによる人工的な好奇心と内発的動機付けも紹介されました。

24.19K

10年前の2015年5月、私たちは数百のレイヤーを持つ最初の非常に深い勾配ベースのフィードフォワードニューラルネットワーク(FNN)を発表しました(以前のFNNは最大数十のレイヤーでした)。勾配消失の問題を克服するために、当社のハイウェイネットワークは、1991年に@HochreiterSeppによって初めて導入された残留接続を使用して、非常に深いLSTM RNNの忘却ゲート(Gers et al., 1999)と同様の乗算ゲートを介してゲート化されたリカレントNN(RNN)の一定のエラーフローを達成しました。ハイウェイNNは、私の元博士課程の学生である@rupspaceとクラウス・グレフの研究によって可能になりました。Highway NN ゲートを 1.0 に設定すると、7 か月後に公開された ResNet が効果的に得られます。

ディープラーニングは、NNの深さがすべてです。LSTMは、再発性NNに本質的に無制限の深さをもたらしました。Highway NetsはそれをフィードフォワードNNに持ち込みました。

20.9K

1991年:最初のニューラルネットワーク蒸留[1-3]。当時、私はそれを「蒸留」ではなく「崩壊」と呼んでいました。

参照

[1] J.シュミットフーバー(1991)。ニューラルシーケンスチャンカー。技術レポートFKI-148-91、ミュンヘン工科大学。セクション3.2.2。第4節は、ニューラルネットワークの知識を別のニューラルネットワークに「崩壊」または「蒸留」または「圧縮」することについてです。

[2] JS(1992年)。履歴圧縮の原理を使用して、複雑で拡張されたシーケンスを学習します。ニューラルコンピュテーション, 4(2):234-242, 1992.[1]に基づきます。

[3] JS (AI ブログ、2021年、2025年更新)。1991年:教師なし事前学習による最初の非常に深い学習。最初のニューラルネットワークの蒸留。

16.42K

今、誰もが再帰的な自己改善とゲーデルマシンについて、そしてそれがAGIにどのようにつながるかについて話しています。15年前とはなんという変化でしょう。ルガーノでAGI'2010を開催し、GoogleでAGI'2011の議長を務めました。AGIカンファレンスのバックボーンは、数学的に最適なユニバーサルAIでした:2003年のゲーデルマシン(および@mhutter42のAIXI-彼の2005年のUAIの本とその最近の2024年の更新を参照してください(マーカス・フッターのAIXIの研究が、彼がIDSIAのポスドクだったときに私の2000年のスイスSNF助成金によって資金提供されたことを誇りに思っています。

57.39K

AGIですか?ある日、しかしまだです。現在、うまく機能している唯一のAIは、画面の後ろにいるAIです[12-17]。しかし、画面の後ろでチューリングテスト[9]に合格することは、現実世界の実際のロボットの実際のAIと比較すると簡単です。現在のAI駆動ロボットは配管工として認定できませんでした[13-17]。したがって、チューリングテストは知能の適切な尺度ではありません(IQもそうではありません)。そして、物理世界を支配していないAGIはAGIではありません。だからこそ、私は2004年に学習ロボットのためのTUM CogBotLabを設立し[5]、2014年には物理世界でのAIのための会社を共同設立し[6]、TUM、IDSIA、そして現在のKAUSTのチームにベビーロボットに向けて取り組んでいました[4,10-11,18]。このようなソフトロボットは、ただ人間を模倣するだけでなく、LLM/VLMのようにウェブをダウンロードするだけでは動作しません。それどころか、彼らは人工的好奇心の原理を利用して、神経世界モデル(私が1990年に使用した2つの用語[1-4])を改善しています。これらのロボットは多くのセンサーで動作しますが、アクチュエーターは弱いため、自分で発明した実験を考案して実行することで有用なデータを収集するときに、簡単に自分自身を傷つけることはありません[18]。

驚くべきことに、1970年代以降、多くの人が、自分よりも賢い自己改善型AGIを構築し、その後引退するという私の古い目標をからかってきました。しかし、最近になって、多くの人がようやくこれを真剣に受け止め始め、今では突然楽観的になりすぎている人もいます。これらの人々は、真のAIを実現するために解決しなければならない残りの課題に気づいていないことがよくあります。私の2024年のTEDトーク [15] は、その一部をまとめています。

参考文献(ウェブ上で簡単に見つけることができます):

[1] J.シュミットフーバー。世界を区別可能にする:非定常環境での動的強化学習と計画のための完全再帰型自己教師ありニューラルネットワーク(NN)の使用について。TR FKI-126-90、TUM、1990年2月、1990年11月改訂。また、この論文では、ミニマックスゲームでジェネレータNNが予測子NNと戦っている敵対的生成ネットワークを通じて、人工的な好奇心と内発的動機づけを紹介しました。

[2] J.S.さん好奇心と退屈をモデル構築のニューラルコントローラーに実装する可能性。J. A. MeyerおよびSW Wilson、編集者、適応行動のシミュレーションに関する国際会議の議事録:動物から動物まで、222-227ページ。MITプレス/ブラッドフォードブックス、1991年。[1]に基づきます。

[3] J.S. AIブログ (2020).1990年:リカレントワールドモデルと人工的好奇心による計画と強化学習。[1][2]の側面と[7][8]を含む多くの後の論文をまとめたものです。

[4] J.S. AI Blog (2021): 1990年以降の人工的な好奇心と創造性。[1][2]の側面と[7][8]を含む多くの後の論文をまとめたものです。

[5] J.S. TU Munich CogBotLab for learning robots (2004-2009)

[6] NNAISENSEは、2014年に設立され、物理世界のAI向けです。

[7] JS(2015年)。考えるための学習について:強化学習(RL)コントローラーと再帰型ニューラルワールドモデルの新しい組み合わせのためのアルゴリズム情報理論。arXiv 1210.0118。セクション5.3では、抽象的な推論、計画、および意思決定のためにモデルをクエリすることを学習するRLプロンプトエンジニアについて説明しています。今日、これは「思考の連鎖」と呼ばれています。

[8] JS(2018年)。1つの大きなネットですべてに。arXiv 1802.08864。特許US11853886B2と私のDeepSeekのツイートも参照してください:DeepSeekは、2015年の強化学習プロンプトエンジニア[7]とその2018年改良[8]の要素を使用しており、RLマシンと[7]の世界モデルを1つのネットに折りたたんでいます。これは、1991年の私のニューラルネット蒸留手順、つまり蒸留された思考連鎖システムを使用しています。

[9] JSチューリング売られ過ぎ。しかし、それはチューリングのせいではありません。AIブログ(2021年、Hacker Newsで#1でした)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein.(知能ロボットは生命に魅了されるでしょう。F.A.Z., 2015 (英語)

[11] J.S. at Falling Walls:人工知能の過去、現在、未来。サイエンティフィック・アメリカン、オブザベーション、2017年。

[12] J.S. KI ist eine Riesenchance für Deutschland.(AIはドイツにとって大きなチャンスです。F.A.Z., 2018 (英語)

[13] H.ジョーンズ。J.S.は、自分のライフワークがディストピアにつながらないと言っています。フォーブス誌、2023年。

[14] J.S. Jazzyearへのインタビュー、上海、2024年。

[15] TED AI Vienna(2024年)でのJ.S. TEDトーク:なぜ2042年はAIにとって大きな年になるのか。添付のビデオクリップをご覧ください。

[16] J.S. Baut den KI-gesteuerten Allzweckroboter!(AI制御の万能ロボットを作ろう!F.A.Z., 2024 (英語)

[17] J.S. 1995-2025: ドイツと日本 vs アメリカと中国の衰退。万能ロボットはカムバックの原動力になれるか?AIブログ、2025年1月、[16]に基づいています。

[18] M.アルハカミ、DRアシュリー、J.ダナム、Y.ダイ、F.ファッチョ、E.フェロン、J.シュミットフーバー。高度な機械学習アルゴリズムのための豊富なインタラクション能力を備えた非常に堅牢なベビーロボットに向けて。プレプリントarxiv 2404.08093、2024年。

67.5K

トップ

ランキング

お気に入り

Trending onchain

Trending on X

Recent top fundings

Most notable