Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Inventou princípios de meta-aprendizagem (1987), GANs (1990), Transformers (1991), aprendizagem muito profunda (1991), etc. Nossa IA é usada muitos bilhões de vezes todos os dias.

Quem inventou as redes neurais convolucionais (CNNs)?

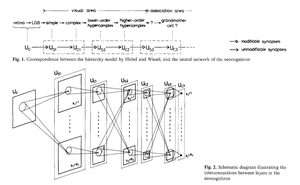

1969: Fukushima teve ReLUs relevantes para CNN [2].

1979: Fukushima teve a arquitetura básica de CNN com camadas de convolução e camadas de downsampling [1]. O custo computacional era 100 vezes mais caro do que em 1989, e um bilhão de vezes mais caro do que hoje.

1987: Waibel aplicou a retropropagação de Linnainmaa de 1970 [3] a TDNNs com compartilhamento de pesos e convoluções unidimensionais [4].

1988: Wei Zhang et al. aplicaram CNNs bidimensionais treinadas por retropropagação "modernas" ao reconhecimento de caracteres [5].

Tudo o que foi mencionado acima foi publicado no Japão entre 1979 e 1988.

1989: LeCun et al. aplicaram CNNs novamente ao reconhecimento de caracteres (códigos postais) [6,10].

1990-93: O downsampling de Fukushima baseado em média espacial [1] foi substituído por max-pooling para TDNNs unidimensionais (Yamaguchi et al.) [7] e CNNs bidimensionais (Weng et al.) [8].

2011: Muito mais tarde, minha equipe com Dan Ciresan fez com que as CNNs com max-pooling fossem realmente rápidas em GPUs NVIDIA. Em 2011, DanNet alcançou o primeiro resultado de reconhecimento de padrões super-humano [9]. Por um tempo, desfrutou de um monopólio: de maio de 2011 a setembro de 2012, DanNet venceu todos os desafios de reconhecimento de imagem que participou, 4 deles consecutivos. Admitidamente, no entanto, isso se deveu principalmente à engenharia e à escalabilidade das percepções básicas do milênio anterior, beneficiando-se de hardware muito mais rápido.

Alguns "especialistas em IA" afirmam que "fazer as CNNs funcionarem" (por exemplo, [5,6,9]) foi tão importante quanto inventá-las. Mas "fazer com que funcionem" dependia em grande parte de se o seu laboratório era rico o suficiente para comprar os computadores mais recentes necessários para escalar o trabalho original. É o mesmo que hoje. Pesquisa básica vs engenharia/desenvolvimento - o R vs o D em P&D.

REFERÊNCIAS

[1] K. Fukushima (1979). Modelo de rede neural para um mecanismo de reconhecimento de padrões não afetado por deslocamento de posição — Neocognitron. Trans. IECE, vol. J62-A, no. 10, pp. 658-665, 1979.

[2] K. Fukushima (1969). Extração de características visuais por uma rede multilayer de elementos de limiar analógico. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Este trabalho introduziu unidades lineares retificadas (ReLUs), agora usadas em muitas CNNs.

[3] S. Linnainmaa (1970). Dissertação de Mestrado, Univ. Helsinki, 1970. A primeira publicação sobre "retropropagação moderna", também conhecida como o modo reverso de diferenciação automática. (Veja a visão geral bem conhecida de retropropagação de Schmidhuber: "Quem Inventou a Retropropagação?")

[4] A. Waibel. Reconhecimento de Fonemas Usando Redes Neurais de Atraso de Tempo. Reunião da IEICE, Tóquio, Japão, 1987. Retropropagação para um TDNN com compartilhamento de pesos e convoluções unidimensionais.

[5] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Rede neural de reconhecimento de padrões invariante a deslocamentos e sua arquitetura óptica. Proc. Conferência Anual da Sociedade Japonesa de Física Aplicada, 1988. Primeira CNN bidimensional treinada por retropropagação, com aplicações ao reconhecimento de caracteres em inglês.

[6] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel: Retropropagação Aplicada ao Reconhecimento de Códigos Postais Manuscritos, Neural Computation, 1(4):541-551, 1989. Veja também a Sec. 3 de [10].

[7] K. Yamaguchi, K. Sakamoto, A. Kenji, T. Akabane, Y. Fujimoto. Uma Rede Neural para Reconhecimento de Palavras Isoladas Independente do Falante. Primeira Conferência Internacional sobre Processamento de Linguagem Falada (ICSLP 90), Kobe, Japão, Nov 1990. Um TDNN unidimensional convolucional usando Max-Pooling em vez da Média Espacial de Fukushima [1].

[8] Weng, J., Ahuja, N., e Huang, T. S. (1993). Aprendendo reconhecimento e segmentação de objetos 3-D a partir de imagens 2-D. Proc. 4ª Conferência Internacional de Visão Computacional, Berlim, pp. 121-128. Uma CNN bidimensional cujas camadas de downsampling usam Max-Pooling (que se tornou muito popular) em vez da Média Espacial de Fukushima [1].

[9] Em 2011, a CNN rápida e profunda baseada em GPU chamada DanNet (7+ camadas) alcançou o primeiro desempenho super-humano em um concurso de visão computacional. Veja a visão geral: "2011: DanNet desencadeia a revolução das CNNs profundas."

[10] Como 3 premiados com o prêmio Turing republicaram métodos e ideias-chave cujos criadores falharam em creditar. Relatório Técnico IDSIA-23-23, Laboratório de IA Suíço IDSIA, 14 de dezembro de 2023. Veja também o vídeo do YouTube para a Cerimônia do Prêmio Bower 2021: J. Schmidhuber elogia Kunihiko Fukushima.

347,21K

Quem inventou a retropropagação (BP)? A sua versão moderna (também chamada de modo reverso de diferenciação automática) foi publicada pela primeira vez em 1970 pelo estudante de mestrado finlandês Seppo Linnainmaa. Um precursor da BP foi publicado por Henry J. Kelley em 1960. A primeira aplicação específica de BP em redes neurais foi descrita por Paul Werbos em 1982 (mas ainda não na sua tese de 1974, como às vezes se afirma).

Alguns perguntam: "A retropropagação não é apenas a regra da cadeia de Leibniz (1676)?" Não, é a forma eficiente de aplicar a regra da cadeia a grandes redes com nós diferenciáveis. (Existem também muitas maneiras ineficientes de fazer isso.) Não foi publicada até 1970.

Veja a página da web de visão geral da retropropagação com mais detalhes:

Veja também a "História Anotada da IA Moderna e Aprendizagem Profunda" (2022):

34,72K

IA Física há 10 anos: robô bebé inventa os seus próprios experimentos para melhorar o seu modelo neural do mundo

Kompella, Stollenga, Luciw, Schmidhuber. Aquisição contínua de habilidades impulsionada pela curiosidade a partir de entradas de vídeo de alta dimensão para robôs humanoides. Inteligência Artificial, 2015

10,92K

Há 1 década: Engenheiro Imediato de Aprendizagem por Reforço na Secção 5.3 de «Aprender a Pensar...» [2]. Cadeia de pensamento adaptativa! Uma rede RL aprende a consultar outra rede para raciocínio abstrato e tomada de decisão. Ir além do Modelo Mundial de 1990 para o planeamento de milissegundos por milissegundos [1].

[2] J. Schmidhuber (JS, 2015). «Sobre Aprender a Pensar: Teoria da Informação Algorítmica para Novas Combinações de Controladores RL e Modelos de Mundo Neural Recorrentes.» ArXiv 1210.0118

[1] JS (1990). "Tornando o mundo diferenciável: sobre o uso de redes neurais autosupervisionadas totalmente recorrentes para aprendizagem e planejamento de reforço dinâmico em ambientes não estacionários." TR FKI-126-90, TUM. (Este relatório também introduziu curiosidade artificial e motivação intrínseca através de redes generativas adversariais.)

24,19K

10 years ago, in May 2015, we published the first working very deep gradient-based feedforward neural networks (FNNs) with hundreds of layers (previous FNNs had a maximum of a few dozen layers). To overcome the vanishing gradient problem, our Highway Networks used the residual connections first introduced in 1991 by @HochreiterSepp to achieve constant error flow in recurrent NNs (RNNs), gated through multiplicative gates similar to the forget gates (Gers et al., 1999) of our very deep LSTM RNN. Highway NNs were made possible through the work of my former PhD students @rupspace and Klaus Greff. Setting the Highway NN gates to 1.0 effectively gives us the ResNet published 7 months later.

Deep learning is all about NN depth. LSTMs brought essentially unlimited depth to recurrent NNs; Highway Nets brought it to feedforward NNs.

20,9K

1991: primeira destilação de redes neurais [1-3]. Eu chamei isso de "colapso", naquela época, não de "destilação".

Referências

[1] J. Schmidhuber (1991). Fragmentos de sequência neural. Relatório técnico FKI-148-91, Tech Univ. Secção 3.2.2. & Sec. 4 são sobre "colapsar" ou "destilar" ou "comprimir" o conhecimento de uma rede neural em outra rede neural.

[2] JS (1992). Aprendizagem de sequências complexas e estendidas usando o princípio da compressão da história. Computação Neural, 4(2):234-242, 1992. Com base em [1].

[3] JS (AI Blog, 2021, atualizado em 2025). 1991: Primeira aprendizagem muito profunda com pré-formação não supervisionada. Primeira destilação de redes neurais.

16,42K

Todo mundo fala sobre autoaperfeiçoamento recursivo & Gödel Machines agora & como isso levará ao AGI. Que mudança de 15 anos atrás! Tivemos AGI'2010 em Lugano e presidimos AGI'2011 no Google. A espinha dorsal das conferências AGI foi matematicamente ótima Universal AI: a Máquina de Gödel de 2003 (e AIXI de @mhutter42 - veja seu livro UAI de 2005 e sua recente atualização de 2024 ( Estou orgulhoso de que o trabalho AIXI de Marcus Hutter foi financiado pela minha bolsa SNF suíça de 2000 quando ele era um pós-doutorado na IDSIA.

57,4K

AGI? Um dia, mas ainda não. A única IA que funciona bem agora é a que está atrás da tela [12-17]. Mas passar no Teste de Turing [9] atrás de uma tela é fácil em comparação com a IA real para robôs reais no mundo real. Nenhum robô atual baseado em IA poderia ser certificado como canalizador [13-17]. Assim, o Teste de Turing não é uma boa medida de inteligência (e o QI também não). E AGI sem domínio do mundo físico não é AGI. É por isso que criei o TUM CogBotLab para robôs de aprendizagem em 2004 [5], cofundei uma empresa de IA no mundo físico em 2014 [6] e tive equipas na TUM, IDSIA e agora KAUST a trabalhar para robôs bebés [4,10-11,18]. Esses robôs suaves não apenas imitam servilmente os seres humanos e eles não funcionam apenas baixando a web como LLMs / VLMs. Não. Em vez disso, eles exploram os princípios da Curiosidade Artificial para melhorar seus Modelos de Mundo neurais (dois termos que usei em 1990 [1-4]). Estes robôs trabalham com muitos sensores, mas apenas com atuadores fracos, de tal forma que não podem facilmente prejudicar-se a si próprios [18] quando recolhem dados úteis através da conceção e execução das suas próprias experiências autoinventadas.

Notavelmente, desde a década de 1970, muitos tiraram sarro do meu antigo objetivo de construir uma AGI auto-melhorada mais inteligente do que eu e depois me aposentar. Recentemente, no entanto, muitos finalmente começaram a levar isso a sério, e agora alguns deles estão repentinamente otimistas demais. Essas pessoas muitas vezes desconhecem os desafios remanescentes que temos que resolver para alcançar a IA real. A minha palestra TED de 2024 [15] resume um pouco disso.

REFERÊNCIAS (fácil de encontrar na web):

[1] J. Schmidhuber. Tornando o mundo diferenciável: Sobre o uso de redes neurais autosupervisionadas (NNs) totalmente recorrentes para aprendizagem e planejamento de reforço dinâmico em ambientes não estacionários. TR FKI-126-90, TUM, fevereiro de 1990, revisto em novembro de 1990. Este artigo também introduziu curiosidade artificial e motivação intrínseca através de redes adversárias generativas onde um NN gerador está lutando contra um NN preditor em um jogo minimax.

[2] J. S. Uma possibilidade para implementar curiosidade e tédio em controladores neurais de construção de modelos. In J. A. Meyer e S. W. Wilson, editores, Proc. da Conferência Internacional sobre Simulação de Comportamento Adaptativo: Dos Animais aos Animats, páginas 222-227. MIT Press/Bradford Books, 1991. Com base em [1].

[3] Blog J.S. AI (2020). 1990: Planeamento e Aprendizagem por Reforço com Modelos de Mundo Recorrentes e Curiosidade Artificial. Resumindo aspetos de [1][2] e muitos artigos posteriores, incluindo [7][8].

[4] J.S. AI Blog (2021): Curiosidade artificial e criatividade desde 1990. Resumindo aspetos de [1][2] e muitos artigos posteriores, incluindo [7][8].

[5] J.S. TU Munich CogBotLab para robôs de aprendizagem (2004-2009)

[6] NNAISENSE, fundada em 2014, para IA no mundo físico.

[7] J.S. (2015). Sobre Aprender a Pensar: Teoria da Informação Algorítmica para Novas Combinações de Controladores de Aprendizagem por Reforço (RL) e Modelos de Mundo Neural Recorrente. arXiv 1210.0118. A Seção 5.3 descreve um engenheiro de prompt RL que aprende a consultar seu modelo para raciocínio abstrato, planejamento e tomada de decisão. Hoje isso é chamado de "cadeia de pensamento".

[8] J.S. (2018). Uma grande rede para tudo. arXiv 1802.08864. Veja também o US11853886B2 de patentes e meu tweet DeepSeek: O DeepSeek usa elementos do engenheiro de aprendizado de reforço de 2015 [7] e seu refinamento de 2018 [8], que colapsa a máquina RL e o modelo mundial de [7] em uma única rede. Isso usa meu procedimento de destilação de rede neural de 1991: um sistema de cadeia de pensamento destilado.

[9] J.S. Turing sobrevendido. Mas a culpa não é de Turing. AI Blog (2021, foi #1 no Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Os robôs inteligentes ficarão fascinados pela vida.) F.A.Z., 2015

[11] J.S. em Falling Walls: O Passado, o Presente e o Futuro da Inteligência Artificial. Scientific American, Observações, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (A IA é uma grande oportunidade para a Alemanha.) F.A.Z., 2018

[13] H. Jones. J.S. diz que o trabalho de sua vida não levará à distopia. Revista Forbes, 2023.

[14] Entrevista com J.S. Jazzyear, Xangai, 2024.

[15] J.S. TED talk no TED AI Viena (2024): Por que 2042 será um grande ano para a IA. Veja o vídeo em anexo.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Construa o robô polivalente controlado por IA!) F.A.Z., 2024

[17] J.S. 1995-2025: O declínio da Alemanha & Japão vs EUA vs. China. Os robôs polivalentes podem alimentar um regresso? AI Blog, janeiro de 2025, com base em [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Rumo a um robô bebé extremamente robusto com uma rica capacidade de interação para algoritmos avançados de aprendizagem automática. Pré-impressão arxiv 2404.08093, 2024.

67,5K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável