Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Винайдені принципи мета-навчання (1987), GANs (1990), Transformers (1991), very deep learning (1991) та ін. Наш штучний інтелект використовується багато мільярдів разів щодня.

Хто винайшов згорткові нейронні мережі (CNN)?

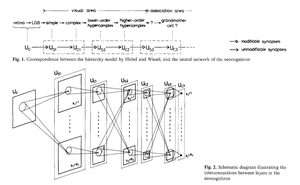

1969: На Фукусімі з'явилися ReLU, що відповідають CNN [2].

1979: На Фукусімі з'явилася базова архітектура CNN зі згортковими шарами та шарами даунсемплінгу [1]. Обчислення були в 100 разів дорожчими, ніж у 1989 році, і в мільярд разів дорожчими, ніж сьогодні.

1987: Вайбел застосував зворотне поширення Linnainmaa 1970 року [3] до TDNN з розподілом ваги з 1-вимірними звивинами [4].

1988: Wei Zhang et al. застосували «сучасні» 2-вимірні CNN, навчені зворотним реквізитом, для розпізнавання символів [5].

Все перераховане було опубліковано в Японії в 1979-1988 роках.

1989: LeCun et al. знову застосували CNN для розпізнавання символів (поштових індексів) [6,10].

1990-93: Даунсемлінг Фукусіми на основі просторового усереднення [1] був замінений максимальним об'єднанням для 1-D TDNN (Yamaguchi et al.) [7] і 2-D CNN (Weng et al.) [8].

2011: Набагато пізніше моя команда з Деном Чіресаном (Dan Ciresan) зробила CNN з максимальним об'ємом продажів на графічних процесорах NVIDIA. У 2011 році компанія DanNet досягла першого надлюдського результату розпізнавання образів [9]. Деякий час вона користувалася монополією: з травня 2011 року по вересень 2012 року DanNet вигравала всі виклики з розпізнавання зображень, в яких брала участь, 4 з них поспіль. Слід визнати, однак, що це в основному стосувалося розробки та масштабування базових ідей попереднього тисячоліття, отримуючи вигоду від набагато швидшого обладнання.

Деякі «експерти зі штучного інтелекту» стверджують, що «змусити CNN працювати» (наприклад, [5,6,9]) було так само важливо, як і їх винахід. Але «змусити їх працювати» багато в чому залежало від того, чи була ваша лабораторія достатньо багатою, щоб купити найновіші комп'ютери, необхідні для масштабування оригінальної роботи. Це те ж саме, що і сьогодні. Фундаментальні дослідження vs інженерія/розробка - R vs D у R&D.

ПОСИЛАННЯ

[1] К. Фукусіма (1979). Нейромережева модель для механізму розпізнавання образів, на які не впливає зміна положення — Neocognitron. Переклад IECE, т. J62-A, No 10, с. 658-665, 1979.

[2] К. Фукусіма (1969). Візуальне виділення ознак багатошаровою мережею аналогових порогових елементів. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. У цій роботі були введені випрямлені лінійні одиниці (ReLUs), які зараз використовуються в багатьох CNN.

[3] S. Linnainmaa (1970). Магістерська дисертація, Гельсінський ун-т, 1970. Перша публікація, присвячена «сучасному» зворотному поширенню, також відомому як зворотний режим автоматичної диференціації. (Див. відомий огляд зворотного поширення Шмідгубера: «Хто винайшов зворотне поширення?»)

[4] А. Вайбель. Розпізнавання фонем за допомогою нейронних мереж із затримкою в часі. Зустріч IEICE, Токіо, Японія, 1987 рік. Зворотне поширення для TDNN з розподілом ваги з 1-вимірними звивинами.

[5] В. Чжан, Я. Таніда, К. Іто, Ю. Ічіока. Нейронна мережа з інваріантним розпізнаванням образів зі зсувом та її оптична архітектура. Щорічна конференція Японського товариства прикладної фізики, 1988. Перший навчений зворотному поширенню 2-вимірний CNN, з додатками для розпізнавання англійських символів.

[6] Ю. Лекун, Б. Босер, Д. С. Денкер, Д. Хендерсон, Р. Е. Говард, В. Хаббард, Л. Д. Джекель: Зворотне поширення, застосоване до розпізнавання рукописних поштових індексів, нейронні обчислення, 1(4):541-551, 1989. Дивіться також п. 3 [10].

[7] К. Ямагуті, К. Сакамото, А. Кенджі, Т. Акабане, Ю. Фудзімото. Нейронна мережа для незалежного від мовця розпізнавання ізольованих слів. Перша міжнародна конференція з обробки розмовної мови (ICSLP 90), Кобе, Японія, листопад 1990 р. 1-вимірна згорткова TDNN з використанням Max-Pooling замість просторового усереднення Фукусіми [1].

[8] Венг, Дж., Ахуджа, Н., і Хуанг, Т. С. (1993). Навчання розпізнаванню та сегментації 3-D об'єктів за 2-D зображеннями. 4-та міжнародна конференція комп'ютерного зору, Берлін, с. 121-128. 2-вимірний CNN, шари спадної дискретизації якого використовують Max-Pooling (який став дуже популярним) замість просторового усереднення Фукусіми [1].

[9] У 2011 році швидкий і глибокий CNN на основі графічного процесора під назвою DanNet (7+ шарів) досяг першого надлюдського виступу в змаганні з комп'ютерного зору. Дивіться огляд: "2011: DanNet запускає глибоку революцію CNN."

[10] Як 3 лауреати премії Тюрінга перевидавали ключові методи та ідеї, творців яких вони не змогли вказати. Технічний звіт IDSIA-23-23, Швейцарська лабораторія штучного інтелекту IDSIA, 14 грудня 2023 р. Дивіться також відео на YouTube до церемонії нагородження Bower Award 2021: Й. Шмідхубер хвалить Куніхіко Фукусіму.

347,22K

Хто винайшов зворотне поширення (ВР)? Його сучасна версія (також звана зворотним режимом автоматичної диференціації) була вперше опублікована в 1970 році фінським магістрантом Сеппо Ліннайнмаа. Попередник ВР був опублікований Генрі Дж. Перше NN-специфічне застосування БП було описано Полом Вербосом у 1982 році (але ще не в його дисертації 1974 року, як іноді стверджують).

Дехто запитує: «Чи не є зворотне поширення просто ланцюговим правилом Лейбніца (1676)?» Ні, це ефективний спосіб застосування правила ланцюга до великих мереж з диференційовними вузлами. (Існує також багато неефективних способів зробити це.) Він не був опублікований до 1970 року.

Дивіться веб-сторінку огляду зворотного поширення з більш детальною інформацією:

Дивіться також "Анотована історія сучасного штучного інтелекту та глибокого навчання" (2022):

34,72K

Фізичний штучний інтелект 10 років тому: робот-малюк винаходить власні експерименти, щоб покращити свою модель нейронного світу

Компелла, Столленга, Люців, Шмідхубер. Постійне набуття навичок на основі цікавості за допомогою високорозмірних відеовходів для гуманоїдних роботів. Штучний інтелект, 2015

10,92K

1 десятиліття тому: Інженер з підготовкою до навчання з підкріпленням в розділі 5.3 «Вчимося думати ...» [2]. Адаптивний ланцюжок думок! Мережа RL вчиться запитувати іншу мережу для абстрактних міркувань і прийняття рішень. Вихід за рамки Світової моделі 1990 року для планування мілісекунди на мілісекунду [1].

[2] Й. Шмідгубер (JS, 2015). «Про навчання мислити: алгоритмічна теорія інформації для нових комбінацій контролерів RL та рекурентних моделей нейронного світу.» ArXiv 1210.0118

[1] JS (1990). «Робимо світ диференційованим: про використання повністю рекурентних самоконтрольованих нейронних мереж для динамічного навчання та планування з підкріпленням у нестаціонарних середовищах.» ТР ФКІ-126-90, ТУМ. (Цей звіт також представив штучну цікавість і внутрішню мотивацію за допомогою генеративних змагальних мереж.)

24,19K

10 років тому, у травні 2015 року, ми опублікували перші робочі нейронні мережі прямого зв'язку (FNN) на основі дуже глибокого градієнта (FNN) із сотнями шарів (попередні FNN мали максимум кілька десятків шарів). Щоб подолати проблему зникаючого градієнта, наші мережі автомагістралей використовували залишкові з'єднання, вперше представлені в 1991 році @HochreiterSepp для досягнення постійного потоку помилок у рекурентних NN (RNN), закритих через мультиплікативні вентилі, подібні до задніх воріт (Gers et al., 1999) нашого дуже глибокого LSTM RNN. Будівництво автомагістралей NN стало можливим завдяки роботі моїх колишніх аспірантів @rupspace та Клауса Греффа. Встановлення воріт Highway NN на 1.0 фактично дає нам ResNet, опублікований через 7 місяців.

Глибоке навчання – це глибина NN. ЛСТМ принесли практично необмежену глибину в рекурентні НН; Highway Nets вивели його на зворотний зв'язок NN.

20,9K

1991 р. – перша дистиляція нейронних мереж [1-3]. Тоді я назвав це «руйнуванням», а не «дистиляцією».

Посилання

[1] J. Schmidhuber (1991). Фрагменти нейронних послідовностей. Технічний звіт FKI-148-91, Технічний ун-т Мюнхен. Розділ 3.2.2. & Розділ 4 присвячені «згортанню» або «дистиляції», або «стисненню» знань нейронної мережі в іншу нейронну мережу.

[2] JS (1992). Розучування складних, розширених послідовностей з використанням принципу стиснення історії. Нейронні обчислення, 4(2):234-242, 1992. На основі [1].

[3] JS (AI Blog, 2021, оновлено 2025). 1991: Перше дуже глибоке навчання з попередньою підготовкою без нагляду. Перша дистиляція нейронних мереж.

16,42K

Всі говорять про рекурсивне самовдосконалення та машини Геделя зараз і як це призведе до AGI. Яка ж зміна в порівнянні з тим, що було 15 років тому! Ми проводили AGI'2010 у Лугано та очолювали AGI'2011 у Google. Основою конференцій AGI був математично оптимальний Універсальний штучний інтелект: машина Геделя 2003 року (і AIXI @mhutter42 - див. його книгу UAI 2005 року та її нещодавнє оновлення 2024 року ( Я пишаюся тим, що робота Маркуса Хаттера AIXI була профінансована за рахунок мого швейцарського гранту SNF 2000 року, коли він був постдоком в IDSIA.

57,4K

АГІ? Одного разу, але ще ні. Єдиний штучний інтелект, який зараз добре працює, – це той, що за екраном [12-17]. Але пройти тест Тюрінга [9] за екраном легко в порівнянні з реальним штучним інтелектом для реальних роботів в реальному світі. Жоден сучасний робот, керований штучним інтелектом, не може бути сертифікований як сантехнік [13-17]. Отже, тест Тюрінга не є хорошим показником інтелекту (як і IQ). А AGI без володіння фізичним світом – це не AGI. Ось чому у 2004 році я створив TUM CogBotLab для навчання роботів [5], у 2014 році став співзасновником компанії зі штучного інтелекту у фізичному світі [6], і мав команди в TUM, IDSIA, а тепер і KAUST, які працюють над роботами-малюками [4,10-11,18]. Такі м'які роботи не просто рабськи імітують людей, і вони не працюють, просто завантажуючи веб, як LLM/VLM. Ні. Замість цього вони використовують принципи штучної цікавості для вдосконалення своїх нейронних моделей світу (два терміни, які я використовував ще в 1990 році [1-4]). Ці роботи працюють з великою кількістю датчиків, але лише зі слабкими виконавчими механізмами, так що вони не можуть легко завдати собі шкоди [18], коли збирають корисні дані, розробляючи та проводячи власні експерименти, вигадані самостійно.

Примітно, що з 1970-х років багато хто висміював мою стару мету побудувати самовдосконалюваний AGI, розумніший за мене, а потім піти на пенсію. Однак останнім часом багато хто нарешті почав ставитися до цього серйозно, і тепер деякі з них раптом стали ЗАНАДТО оптимістичними. Ці люди часто блаженно не знають про проблеми, що залишилися, які нам потрібно вирішити, щоб досягти справжнього штучного інтелекту. Мій виступ на TED 2024 року [15] підсумовує дещо з цього.

СПИСОК ЛІТЕРАТУРИ (легко знайти в Інтернеті):

[1] Й. Шмідгубер. Робимо світ диференційованим: Про використання повністю повторюваних самоконтрольованих нейронних мереж (NNs) для динамічного навчання та планування з підкріпленням у нестаціонарних середовищах. TR FKI-126-90, TUM, лютий 1990 р., переглянутий у листопаді 1990 р. Ця стаття також представила штучну цікавість і внутрішню мотивацію за допомогою генеративних змагальних мереж, де генератор NN бореться з предиктором NN у мінімаксній грі.

[2] Дж. Можливість реалізації цікавості та нудьги в нейронних контролерах, що будують моделі. У J. A. Meyer and S. W. Wilson, редактори, Proc. of the International Conference on Simulation of Adaptive Behavior: From Animals to Animats, pages 222-227. Видавництво Массачусетського технологічного інституту / Бредфорд Букс, 1991. На основі [1].

[3] Блог J.S. AI (2020). 1990: Планування та навчання з підкріпленням за допомогою повторюваних моделей світу та штучної цікавості. Узагальнення аспектів [1][2] та багатьох пізніших робіт, включаючи [7][8].

[4] Блог J.S. AI (2021): Штучна цікавість і творчість з 1990 року. Узагальнення аспектів [1][2] та багатьох пізніших робіт, включаючи [7][8].

[5] J.S. TU Мюнхенська лабораторія CogBotLab для навчання роботів (2004-2009)

[6] NNAISENSE, заснована у 2014 році, для штучного інтелекту у фізичному світі

[7] Ж.С. (2015). Про навчання мислити: алгоритмічна теорія інформації для нових комбінацій контролерів навчання з підкріпленням (RL) та рекурентних моделей нейронного світу. arXiv 1210.0118. У п. 5.3 описаний інженер RL, який вчиться запитувати свою модель для абстрактних міркувань і планування та прийняття рішень. Сьогодні це називається «ланцюгом думок».

[8] Ж.С. (2018). Одна велика сітка для всього. arXiv 1802.08864. Дивіться також патентний US11853886B2 та мій твіт DeepSeek: DeepSeek використовує елементи інженера швидкого навчання з підкріпленням 2015 року [7] та його доопрацювання 2018 року [8], що зводить машину RL та світову модель [7] в єдину мережу. Для цього використовується моя процедура дистиляції нейронної мережі 1991 року: дистильований ланцюг системи думок.

[9] Дж.С. Тюрінг Перепроданий. Однак це не провина Тюрінга. AI Blog (2021, був #1 на Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Розумні роботи будуть зачаровані життям.) Ф.А.З., 2015

[11] J.S. у Falling Walls: минуле, сьогодення та майбутнє штучного інтелекту. Науковий американець, Спостереження, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (Штучний інтелект – це величезний шанс для Німеччини.) Ф.А.З., 2018

[13] Г. Джонс. Джей Сі каже, що справа його життя не призведе до антиутопії. Журнал Forbes, 2023.

[14] Інтерв'ю з J.S. Jazzyear, Шанхай, 2024 рік.

[15] Виступ J.S. TED на TED AI у Відні (2024): Чому 2042 рік стане важливим роком для штучного інтелекту. Дивіться прикріплений відеоролик.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Створіть універсального робота, керованого штучним інтелектом!) Ф.А.З., 2024

[17] J.S. 1995-2025: Занепад Німеччини та Японії проти США та Китаю. Чи можуть універсальні роботи сприяти поверненню? AI Blog, січень 2025 р., на основі [16].

[18] М. Альхакамі, Д. Р. Ешлі, Дж. На шляху до надзвичайно надійного робота-малюка з багатими можливостями взаємодії для передових алгоритмів машинного навчання. Препринт arxiv 2404.08093, 2024.

67,51K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги