Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

A inventat principiile meta-învățării (1987), GAN (1990), Transformers (1991), învățare foarte profundă (1991) etc. Inteligența noastră artificială este folosită de multe miliarde de ori în fiecare zi.

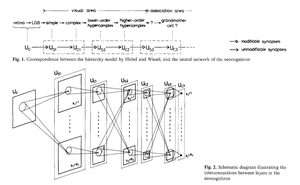

Cine a inventat rețelele neuronale convoluționale (CNN)?

1969: Fukushima a avut ReLU-uri relevante pentru CNN [2].

1979: Fukushima a avut arhitectura de bază a CNN cu straturi de convoluție și straturi de subeșantionare [1]. Calculul a fost de 100 de ori mai costisitor decât în 1989 și de un miliard de ori mai costisitor decât astăzi.

1987: Waibel a aplicat retropropagarea lui Linnainmaa din 1970 [3] la TDNN-urile de împărțire a greutății cu circumvoluții unidimensionale [4].

1988: Wei Zhang et al. au aplicat CNN-urile bidimensionale "moderne" antrenate de backprop la recunoașterea caracterelor [5].

Toate cele de mai sus au fost publicate în Japonia între 1979 și 1988.

1989: LeCun et al. au aplicat din nou CNN-urile la recunoașterea caracterelor (coduri poștale) [6,10].

1990-93: Reducerea eșantionării de la Fukushima bazată pe media spațială [1] a fost înlocuită cu max-pooling pentru TDNN-uri 1-D (Yamaguchi et al.) [7] și CNN-uri 2-D (Weng et al.) [8].

2011: Mult mai târziu, echipa mea cu Dan Ciresan a făcut ca CNN-urile să fie foarte rapide pe GPU-urile NVIDIA. În 2011, DanNet a obținut primul rezultat de recunoaștere a modelelor supraumane [9]. Pentru o vreme, s-a bucurat de un monopol: din mai 2011 până în septembrie 2012, DanNet a câștigat toate provocările de recunoaștere a imaginii la care a participat, 4 dintre ele la rând. Desigur, totuși, a fost vorba în mare parte despre inginerie și extinderea cunoștințelor de bază din mileniul precedent, profitând de hardware mult mai rapid.

Unii "experți în inteligență artificială" susțin că "a face CNN-urile să funcționeze" (de exemplu, [5,6,9]) a fost la fel de important ca și inventarea lor. Dar "a le face să funcționeze" depindea în mare măsură de faptul dacă laboratorul tău era suficient de bogat pentru a cumpăra cele mai recente computere necesare pentru a extinde munca originală. Este la fel ca astăzi. Cercetare de bază vs inginerie/dezvoltare - R vs D în cercetare și dezvoltare.

REFERINŢE

[1] K. Fukushima (1979). Model de rețea neuronală pentru un mecanism de recunoaștere a modelelor neafectat de schimbarea poziției - Neocognitron. Trans. IECE, vol. J62-A, nr. 10, pp. 658-665, 1979.

[2] K. Fukushima (1969). Extragerea caracteristicilor vizuale printr-o rețea multistratificată de elemente de prag analogice. Tranzacții IEEE privind știința sistemelor și cibernetică. 5 (4): 322-333. Această lucrare a introdus unități liniare rectificate (ReLU), acum utilizate în multe CNN-uri.

[3] S. Linnainmaa (1970). Teză de masterat, Univ. Helsinki, 1970. Prima publicație despre retropropagarea "modernă", cunoscută și sub numele de modul invers de diferențiere automată. (Vezi binecunoscuta prezentare generală a lui Schmidhuber: "Cine a inventat retropropagarea?")

[4] A. Waibel. Recunoașterea fonemelor folosind rețele neuronale cu întârziere. Reuniunea IEICE, Tokyo, Japonia, 1987. Retropropagare pentru un TDNN de împărțire a greutății cu circumvoluții 1-dimensionale.

[5] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Rețea neuronală de recunoaștere a modelelor invariante și arhitectura sa optică. Proc. Conferința anuală a Societății Japoneze de Fizică Aplicată, 1988. Primul CNN bidimensional antrenat de retropropagare, cu aplicații pentru recunoașterea caracterelor în limba engleză.

[6] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel: Retropropagare aplicată la recunoașterea codurilor poștale scrise de mână, Neural Computation, 1(4):541-551, 1989. A se vedea, de asemenea, secțiunea 3 din [10].

[7] K. Yamaguchi, K. Sakamoto, A. Kenji, T. Akabane, Y. Fujimoto. O rețea neuronală pentru recunoașterea cuvintelor izolate independente de vorbitor. Prima Conferință Internațională privind Procesarea Limbajului Vorbit (ICSLP 90), Kobe, Japonia, noiembrie 1990. Un TDNN convoluțional 1-dimensional folosind Max-Pooling în loc de Spatial Averaging de la Fukushima [1].

[8] Weng, J., Ahuja, N. și Huang, T. S. (1993). Învățarea recunoașterii și segmentării obiectelor 3D din imagini 2D. Proc. 4th Intl. Conf. Computer Vision, Berlin, pp. 121-128. Un CNN bidimensional ale cărui straturi de downsampling folosesc Max-Pooling (care a devenit foarte popular) în loc de Spatial Averaging de la Fukushima [1].

[9] În 2011, CNN-ul rapid și profund bazat pe GPU numit DanNet (7+ straturi) a obținut prima performanță supraomenească într-un concurs de viziune computerizată. Vezi prezentarea generală: "2011: DanNet declanșează o revoluție CNN profundă".

[10] Cum 3 premianți Turing au republicat metode și idei cheie ai căror creatori nu au reușit să-i crediteze. Raport tehnic IDSIA-23-23, Swiss AI Lab IDSIA, 14 decembrie 2023. Vezi și videoclipul de pe YouTube pentru ceremonia de decernare a premiilor Bower 2021: J. Schmidhuber îl laudă pe Kunihiko Fukushima.

347,22K

Cine a inventat retropropagarea (BP)? Versiunea sa modernă (numită și modul invers de diferențiere automată) a fost publicată pentru prima dată în 1970 de studentul finlandez Seppo Linnainmaa. Un precursor al BP a fost publicat de Henry J. Kelley în 1960. Prima aplicație specifică NN a BP a fost descrisă de Paul Werbos în 1982 (dar nu încă în teza sa din 1974, așa cum se pretinde uneori).

Unii întreabă: "Nu este propagarea inversă doar regula lanțului a lui Leibniz (1676)?" Nu, este modul eficient de a aplica regula lanțului la rețelele mari cu noduri diferențiabile. (Există, de asemenea, multe moduri ineficiente de a face acest lucru.) Nu a fost publicată până în 1970.

Vedeți pagina web de prezentare generală a propagării inverse cu mai multe detalii:

A se vedea, de asemenea, "Istoria adnotată a IA modernă și a învățării profunde" (2022):

34,72K

IA fizică acum 10 ani: bebelușul robot își inventează propriile experimente pentru a-și îmbunătăți modelul lumii neuronale

Kompella, Stollenga, Luciw, Schmidhuber. Dobândirea continuă de abilități bazate pe curiozitate din intrări video de înaltă dimensiune pentru roboți umanoizi. Inteligența artificială, 2015

10,92K

acum 1 deceniu: Inginer prompt de învățare prin întărire în Sec. 5.3 din "Învățarea de a gândi ..." [2]. Lanțul de gândire adaptiv! O rețea RL învață să interogheze o altă rețea pentru raționament abstract și luare a deciziilor. Depășind modelul mondial din 1990 pentru planificarea milisecundă cu milisecundă [1].

[2] J. Schmidhuber (JS, 2015). «Despre învățarea gândirii: teoria informației algoritmice pentru noi combinații de controlere RL și modele recurente ale lumii neuronale.» ArXiv 1210.0118

[1] JS (1990). "Făcând lumea diferențiabilă: Despre utilizarea rețelelor neuronale auto-supravegheate complet recurente pentru învățarea și planificarea prin întărire dinamică în medii non-staționare." TR FKI-126-90, TUM. (Acest raport a introdus, de asemenea, curiozitatea artificială și motivația intrinsecă prin rețele generative adversare.)

24,2K

În urmă cu 10 ani, în mai 2015, am publicat primele rețele neuronale bazate pe gradient foarte profund (FNN) cu sute de straturi (FNN-urile anterioare aveau maximum câteva zeci de straturi). Pentru a depăși problema gradientului de dispariție, rețelele noastre de autostrăzi au folosit conexiunile reziduale introduse pentru prima dată în 1991 de @HochreiterSepp pentru a obține un flux constant de eroare în NN-urile recurente (RNN), închise prin porți multiplicative similare cu porțile de uitare (Gers et al., 1999) ale RNN-ului nostru LSTM foarte profund. Highway NN-uri au fost posibile datorită muncii foștilor mei doctoranzi @rupspace și Klaus Greff. Setarea porților Highway NN la 1.0 ne oferă efectiv ResNet publicat 7 luni mai târziu.

Învățarea profundă se referă la profunzimea NN. LSTM-urile au adus profunzime nelimitată NN-urilor recurente; Highway Nets l-a adus la NN-urile feedforward.

20,91K

1991: prima distilare a rețelei neuronale [1-3]. Am numit-o "prăbușire", pe atunci, nu "distilare".

Referinţe

[1] J. Schmidhuber (1991). Fragmente de secvențe neuronale. Raport tehnic FKI-148-91, Tech Univ. München. Secțiunea 3.2.2. 4 sunt despre "prăbușirea" sau "distilarea" sau "comprimarea" cunoștințelor unei rețele neuronale într-o altă rețea neuronală.

[2] JS (1992). Învățarea secvențelor complexe și extinse folosind principiul compresiei istoriei. Calcul neuronal, 4(2):234-242, 1992. Bazat pe [1].

[3] JS (AI Blog, 2021, actualizat în 2025). 1991: Prima învățare foarte profundă cu pre-instruire nesupravegheată. Prima distilare a rețelei neuronale.

16,42K

Toată lumea vorbește despre auto-îmbunătățire recursivă și despre mașinile Gödel acum și despre cum acest lucru va duce la AGI. Ce schimbare față de acum 15 ani! Am avut AGI'2010 în Lugano și am prezidat AGI'2011 la Google. Coloana vertebrală a conferințelor AGI a fost IA universală optimă din punct de vedere matematic: Mașina Gödel din 2003 (și AIXI a lui @mhutter42 - vezi cartea sa UAI din 2005 și recenta sa actualizare din 2024 ( Sunt mândru că munca AIXI a lui Marcus Hutter a fost finanțată de grantul meu SNF elvețian din 2000 când era postdoc la IDSIA.

57,4K

AGI? O zi, dar nu încă. Singura inteligență artificială care funcționează bine în acest moment este cea din spatele ecranului [12-17]. Dar trecerea testului Turing [9] în spatele unui ecran este ușoară în comparație cu IA reală pentru roboții reali din lumea reală. Niciun robot actual condus de inteligență artificială nu ar putea fi certificat ca instalator [13-17]. Prin urmare, testul Turing nu este o măsură bună a inteligenței (și nici IQ-ul). Iar AGI fără stăpânirea lumii fizice nu este AGI. De aceea am creat TUM CogBotLab pentru roboți de învățare în 2004 [5], am co-fondat o companie pentru AI în lumea fizică în 2014 [6] și am avut echipe la TUM, IDSIA și acum KAUST care lucrează la roboți pentru copii [4,10-11,18]. Astfel de roboți moi nu doar imită oamenii și nu funcționează doar descărcând web-ul ca LLM-urile/VLM-urile. În schimb, ei exploatează principiile curiozității artificiale pentru a-și îmbunătăți modelele neuronale ale lumii (doi termeni pe care i-am folosit în 1990 [1-4]). Acești roboți lucrează cu o mulțime de senzori, dar doar cu actuatori slabi, astfel încât nu se pot răni cu ușurință atunci când colectează date utile prin conceperea și rularea propriilor experimente inventate de ei înșiși.

În mod remarcabil, începând cu anii 1970, mulți au râs de vechiul meu obiectiv de a construi un AGI mai inteligent decât mine și apoi să mă pensionez. Recent, totuși, mulți au început în sfârșit să ia acest lucru în serios, iar acum unii dintre ei sunt brusc prea optimiști. Acești oameni sunt adesea inconștienți de provocările rămase pe care trebuie să le rezolvăm pentru a obține o inteligență artificială reală. Discursul meu TED din 2024 [15] rezumă o parte din asta.

REFERINȚE (ușor de găsit pe web):

[1] J. Schmidhuber. Face lumea diferențiabilă: Despre utilizarea rețelelor neuronale autosupravegheate (NN) complet recurente pentru învățarea și planificarea prin întărire dinamică în medii non-staționare. TR FKI-126-90, TUM, februarie 1990, revizuit noiembrie 1990. Această lucrare a introdus, de asemenea, curiozitatea artificială și motivația intrinsecă prin rețele generative adversare în care un generator NN se luptă cu un predictor NN într-un joc minimax.

[2] J. S. O posibilitate de implementare a curiozității și plictiselii în controlerele neuronale de construcție a modelelor. În J. A. Meyer și S. W. Wilson, editori, Proc. al Conferinței Internaționale privind Simularea Comportamentului Adaptiv: De la Animale la Animații, paginile 222-227. MIT Press/Bradford Books, 1991. Bazat pe [1].

[3] Blogul JS AI (2020). 1990: Planificare și învățare prin întărire cu modele recurente ale lumii și curiozitate artificială. Rezumând aspecte ale [1][2] și multe lucrări ulterioare, inclusiv [7][8].

[4] J.S. AI Blog (2021): Curiozitate artificială și creativitate din 1990. Rezumând aspecte ale [1][2] și multe lucrări ulterioare, inclusiv [7][8].

[5] J.S. TU München CogBotLab pentru roboți de învățare (2004-2009)

[6] NNAISENSE, fondată în 2014, pentru AI în lumea fizică

[7] J.S. (2015). Despre învățarea de a gândi: teoria informației algoritmice pentru noi combinații de controlori de învățare prin întărire (RL) și modele recurente ale lumii neuronale. arXiv 1210.0118. Sec. 5.3 descrie un inginer prompt RL care învață să-și interogheze modelul pentru raționament abstract și planificare și luare a deciziilor. Astăzi acest lucru se numește "lanț de gândire".

[8] J.S. (2018). O plasă mare pentru orice. arXiv 1802.08864. A se vedea, de asemenea, brevetul US11853886B2 și tweet-ul meu DeepSeek: DeepSeek folosește elemente ale inginerului prompt de învățare prin întărire din 2015 [7] și rafinamentul său din 2018 [8] care prăbușește mașina RL și modelul mondial al [7] într-o singură rețea. Aceasta folosește procedura mea de distilare a rețelei neuronale din 1991: un sistem de gândire distilat în lanț.

[9] J.S. Turing supravândut. Totuși, nu este vina lui Turing. AI Blog (2021, a fost #1 pe Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Roboții inteligenți vor fi fascinați de viață.) F.A.Z., 2015

[11] J.S. la Falling Walls: Trecutul, prezentul și viitorul inteligenței artificiale. Scientific American, Observații, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (AI este o șansă uriașă pentru Germania.) F.A.Z., 2018

[13] H. Jones. J.S. spune că munca sa de o viață nu va duce la distopie. Revista Forbes, 2023.

[14] Interviu cu J.S. Jazzyear, Shanghai, 2024.

[15] Discuție JS TED la TED AI Viena (2024): De ce 2042 va fi un an mare pentru AI. Vedeți videoclipul atașat.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Construiți robotul universal controlat de inteligență artificială!) F.A.Z., 2024

[17] J.S. 1995-2025: Declinul Germaniei și Japoniei față de SUA și China. Pot roboții universali să alimenteze o revenire? AI Blog, ianuarie 2025, bazat pe [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Către un robot pentru bebeluși extrem de robust, cu o capacitate bogată de interacțiune pentru algoritmi avansați de învățare automată. Preprint arxiv 2404.08093, 2024.

67,51K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante