Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Uitgevonden principes van meta-learning (1987), GAN's (1990), Transformers (1991), zeer diep leren (1991), enz. Onze AI wordt dagelijks vele miljarden keren gebruikt.

Wie heeft convolutionele neurale netwerken (CNN's) uitgevonden?

1969: Fukushima had CNN-relevante ReLUs [2].

1979: Fukushima had de basisarchitectuur van CNN met convolutielaag en downsamplinglagen [1]. De rekentijd was 100 x duurder dan in 1989, en een miljard x duurder dan vandaag.

1987: Waibel paste Linnainmaa's backpropagation uit 1970 [3] toe op gewicht-delende TDNN's met 1-dimensionale convoluties [4].

1988: Wei Zhang et al. pasten "moderne" backprop-getrainde 2-dimensionale CNN's toe op tekenherkenning [5].

Al het bovenstaande werd gepubliceerd in Japan van 1979-1988.

1989: LeCun et al. pasten CNN's opnieuw toe op tekenherkenning (postcode) [6,10].

1990-93: Fukushima’s downsampling op basis van ruimtelijke averaging [1] werd vervangen door max-pooling voor 1-D TDNN's (Yamaguchi et al.) [7] en 2-D CNN's (Weng et al.) [8].

2011: Veel later maakte mijn team met Dan Ciresan max-pooling CNN's echt snel op NVIDIA GPU's. In 2011 behaalde DanNet de eerste superieure patroonherkenningsresultaten [9]. Een tijdlang genoot het een monopolie: van mei 2011 tot september 2012 won DanNet elke beeldherkenningsuitdaging waaraan het deelnam, 4 keer achter elkaar. Toegegeven, dit had echter vooral te maken met engineering en het opschalen van de basisinzichten uit het vorige millennium, profiterend van veel snellere hardware.

Sommige "AI-experts" beweren dat "het laten werken van CNN's" (bijv. [5,6,9]) net zo belangrijk was als het uitvinden ervan. Maar "het laten werken" hing grotendeels af van of je lab rijk genoeg was om de nieuwste computers te kopen die nodig waren om het oorspronkelijke werk op te schalen. Het is hetzelfde als vandaag. Basisonderzoek versus engineering/ontwikkeling - de R versus de D in R&D.

REFERENTIES

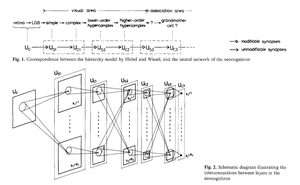

[1] K. Fukushima (1979). Neuraal netwerkmodel voor een mechanisme van patroonherkenning dat niet wordt beïnvloed door verschuiving in positie — Neocognitron. Trans. IECE, vol. J62-A, nr. 10, pp. 658-665, 1979.

[2] K. Fukushima (1969). Visuele functie-extractie door een gelaagd netwerk van analoge drempelelementen. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Dit werk introduceerde rectified linear units (ReLUs), nu gebruikt in veel CNN's.

[3] S. Linnainmaa (1970). Master's Thesis, Univ. Helsinki, 1970. De eerste publicatie over "moderne" backpropagation, ook bekend als de reverse mode van automatische differentiatie. (Zie Schmidhuber's bekende overzicht van backpropagation: "Wie heeft Backpropagation uitgevonden?")

[4] A. Waibel. Fonetische herkenning met behulp van tijdvertraging neurale netwerken. Vergadering van IEICE, Tokio, Japan, 1987. Backpropagation voor een gewicht-delende TDNN met 1-dimensionale convoluties.

[5] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Shift-invariant patroonherkenning neuraal netwerk en zijn optische architectuur. Proc. Jaarlijkse Conferentie van de Japan Society of Applied Physics, 1988. Eerste backpropagation-getrainde 2-dimensionale CNN, met toepassingen voor Engelse tekenherkenning.

[6] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel: Backpropagation Toegepast op Handgeschreven Postcodeherkenning, Neural Computation, 1(4):541-551, 1989. Zie ook Sec. 3 van [10].

[7] K. Yamaguchi, K. Sakamoto, A. Kenji, T. Akabane, Y. Fujimoto. Een Neuraal Netwerk voor Spreker-onafhankelijke Geïsoleerde Woordherkenning. Eerste Internationale Conferentie over Gesproken Taalverwerking (ICSLP 90), Kobe, Japan, nov 1990. Een 1-dimensionale convolutionele TDNN die Max-Pooling gebruikt in plaats van Fukushima's Ruimtelijke Averaging [1].

[8] Weng, J., Ahuja, N., en Huang, T. S. (1993). Leren van herkenning en segmentatie van 3-D objecten uit 2-D beelden. Proc. 4e Intl. Conf. Computer Vision, Berlijn, pp. 121-128. Een 2-dimensionale CNN waarvan de downsamplinglagen Max-Pooling gebruiken (wat zeer populair is geworden) in plaats van Fukushima's Ruimtelijke Averaging [1].

[9] In 2011 behaalde de snelle en diepe GPU-gebaseerde CNN genaamd DanNet (7+ lagen) de eerste superieure prestaties in een computer vision wedstrijd. Zie overzicht: "2011: DanNet triggert diepe CNN-revolutie."

[10] Hoe 3 Turing-prijswinnaars belangrijke methoden en ideeën herpubliceerden waarvan de makers niet werden gecrediteerd. Technisch Rapport IDSIA-23-23, Swiss AI Lab IDSIA, 14 dec 2023. Zie ook de YouTube-video voor de Bower Award Ceremony 2021: J. Schmidhuber prijst Kunihiko Fukushima.

347,19K

Wie heeft backpropagation (BP) uitgevonden? De moderne versie (ook wel de omgekeerde modus van automatische differentiatie genoemd) werd voor het eerst gepubliceerd in 1970 door de Finse masterstudent Seppo Linnainmaa. Een voorlopige versie van BP werd gepubliceerd door Henry J. Kelley in 1960. De eerste NN-specifieke toepassing van BP werd beschreven door Paul Werbos in 1982 (maar niet in zijn proefschrift van 1974, zoals soms wordt beweerd).

Sommigen vragen: "Is backpropagation niet gewoon de kettingregel van Leibniz (1676)?" Nee, het is de efficiënte manier om de kettingregel toe te passen op grote netwerken met differentieerbare knooppunten. (Er zijn ook veel inefficiënte manieren om dit te doen.) Het werd pas in 1970 gepubliceerd.

Zie de webpagina met een overzicht van backpropagation voor meer details:

Zie ook de "Geannoteerde Geschiedenis van Moderne AI en Deep Learning" (2022):

34,71K

Fysieke AI 10 jaar geleden: babyrobot uitvindt zijn eigen experimenten om zijn neurale wereldmodel te verbeteren

Kompella, Stollenga, Luciw, Schmidhuber. Voortdurende nieuwsgierigheid-gedreven vaardigheidsverwerving uit hoogdimensionale video-invoer voor humanoïde robots. Kunstmatige Intelligentie, 2015

10,91K

1 decennium geleden: Reinforcement Learning Prompt Engineer in Sec. 5.3 van «Learning to Think …» [2]. Adaptieve Denkketen! Een RL-netwerk leert een ander netwerk te ondervragen voor abstract redeneren en besluitvorming. Voorbij het World Model van 1990 voor milliseconde-voor-milliseconde planning [1].

[2] J. Schmidhuber (JS, 2015). «On Learning to Think: Algorithmic Information Theory for Novel Combinations of RL Controllers and Recurrent Neural World Models.» ArXiv 1210.0118

[1] JS (1990). “Making the world differentiable: On using fully recurrent self-supervised neural networks for dynamic reinforcement learning and planning in non-stationary environments.” TR FKI-126-90, TUM. (Dit rapport introduceerde ook kunstmatige nieuwsgierigheid en intrinsieke motivatie door middel van generatieve adversariële netwerken.)

24,18K

10 jaar geleden, in mei 2015, publiceerden we de eerste werkende zeer diepe op gradienten gebaseerde feedforward neurale netwerken (FNN's) met honderden lagen (vorige FNN's hadden een maximum van een paar dozijn lagen). Om het probleem van de verdwijnende gradient te overwinnen, gebruikten onze Highway Networks de residuele verbindingen die voor het eerst in 1991 door @HochreiterSepp werden geïntroduceerd om een constante foutstroom in recurrente neurale netwerken (RNN's) te bereiken, gated door multiplicatieve poorten die vergelijkbaar zijn met de vergeetpoorten (Gers et al., 1999) van onze zeer diepe LSTM RNN. Highway NNs werden mogelijk gemaakt door het werk van mijn voormalige PhD-studenten @rupspace en Klaus Greff. Het instellen van de Highway NN-poorten op 1.0 geeft ons effectief de ResNet die 7 maanden later werd gepubliceerd.

Diep leren draait allemaal om de diepte van neurale netwerken. LSTM's brachten in wezen onbeperkte diepte naar recurrente neurale netwerken; Highway Nets brachten het naar feedforward neurale netwerken.

20,89K

1991: eerste distillatie van neurale netwerken [1-3]. Ik noemde het toen "collapsing," niet "distilling."

Referenties

[1] J. Schmidhuber (1991). Neurale sequentie chunkers. Tech Report FKI-148-91, Tech Univ. München. Sectie 3.2.2. & Sectie 4 gaan over "collapsing" of "distilling" of "compressing" van de kennis van een neuraal netwerk naar een ander neuraal netwerk.

[2] JS (1992). Leren van complexe, uitgebreide sequenties met behulp van het principe van geschiedeniscompressie. Neural Computation, 4(2):234-242, 1992. Gebaseerd op [1].

[3] JS (AI Blog, 2021, bijgewerkt 2025). 1991: Eerste zeer diepe leren met onbewaakte voortraining. Eerste distillatie van neurale netwerken.

16,41K

Iedereen heeft het over recursieve zelfverbetering en Gödel Machines nu en hoe dit zal leiden tot AGI. Wat een verandering ten opzichte van 15 jaar geleden! We hadden AGI'2010 in Lugano en waren voorzitter van AGI'2011 bij Google. De ruggengraat van de AGI-conferenties was wiskundig optimale universele AI: de Gödel-machine uit 2003 (en de AIXI van @mhutter42 - zie zijn UAI-boek uit 2005 en de recente update uit 2024 ( Ik ben er trots op dat het AIXI-werk van Marcus Hutter werd gefinancierd door mijn Zwitserse SNF-beurs uit 2000 toen hij postdoc was bij IDSIA.

57,39K

AGI? Op een dag, maar nu nog niet. De enige AI die op dit moment goed werkt, is die achter het scherm [12-17]. Maar het slagen voor de Turing-test [9] achter een scherm is eenvoudig vergeleken met echte AI voor echte robots in de echte wereld. Geen enkele huidige AI-gestuurde robot kan worden gecertificeerd als loodgieter [13-17]. Daarom is de Turing-test geen goede maatstaf voor intelligentie (en IQ ook niet). En AGI zonder beheersing van de fysieke wereld is geen AGI. Daarom heb ik in 2004 het TUM CogBotLab voor lerende robots opgericht [5], ben ik in 2014 medeoprichter van een bedrijf voor AI in de fysieke wereld [6] en heb ik teams bij TUM, IDSIA en nu KAUST laten werken aan babyrobots [4,10-11,18]. Zulke zachte robots imiteren niet alleen slaafs mensen, en ze werken niet door alleen het web te downloaden zoals LLM's/VLM's. Nee. In plaats daarvan maken ze gebruik van de principes van kunstmatige nieuwsgierigheid om hun neurale wereldmodellen te verbeteren (twee termen die ik in 1990 gebruikte [1-4]). Deze robots werken met veel sensoren, maar alleen met zwakke actuatoren, zodat ze zichzelf niet gemakkelijk schade kunnen toebrengen [18] wanneer ze nuttige gegevens verzamelen door hun eigen zelfbedachte experimenten te bedenken en uit te voeren.

Opmerkelijk is dat velen sinds de jaren 1970 de draak hebben gestoken met mijn oude doel om een zelfverbeterende AGI op te bouwen die slimmer is dan ikzelf en vervolgens met pensioen te gaan. De laatste tijd zijn velen dit echter eindelijk serieus gaan nemen, en nu zijn sommigen van hen ineens TE optimistisch. Deze mensen zijn zich vaak niet bewust van de resterende uitdagingen die we moeten oplossen om tot Real AI te komen. Mijn TED-talk uit 2024 [15] vat daar iets van samen.

REFERENTIES (gemakkelijk te vinden op het web):

[1] J. Schmidhuber. De wereld differentieerbaar maken: Over het gebruik van volledig terugkerende zelfgesuperviseerde neurale netwerken (NN's) voor dynamisch versterkend leren en plannen in niet-stationaire omgevingen. TR FKI-126-90, TUM, februari 1990, herzien november 1990. Dit artikel introduceerde ook kunstmatige nieuwsgierigheid en intrinsieke motivatie door middel van generatieve vijandige netwerken waarbij een generator NN vecht tegen een voorspeller NN in een minimax-spel.

[2] J.S. Een mogelijkheid om nieuwsgierigheid en verveling te implementeren in neurale controllers voor het bouwen van modellen. In J. A. Meyer en S. W. Wilson, redacteuren, Proc. van de International Conference on Simulation of Adaptive Behavior: From Animals to Animats, pagina's 222-227. MIT Press/Bradford Books, 1991. Gebaseerd op [1].

[3] JS AI-blog (2020). 1990: Planning & Reinforcement Learning met Recurrent World Models en Artificial Curiosity. Samenvattende aspecten van [1][2] en veel latere artikelen, waaronder [7][8].

[4] J.S. AI Blog (2021): Kunstmatige nieuwsgierigheid en creativiteit sinds 1990. Samenvattende aspecten van [1][2] en veel latere artikelen, waaronder [7][8].

[5] J.S. TU München CogBotLab voor lerende robots (2004-2009)

[6] NNAISENSE, opgericht in 2014, voor AI in de fysieke wereld

[7] J.S. (2015). Over leren denken: algoritmische informatietheorie voor nieuwe combinaties van reinforcement learning (RL) controllers en terugkerende neurale wereldmodellen. arXiv 1210.0118. Sec. 5.3 beschrijft een RL-promptingenieur die leert om zijn model te bevragen voor abstract redeneren en plannen en besluitvorming. Tegenwoordig wordt dit 'gedachteketen' genoemd.

[8] J.S. (2018). Eén groot net voor alles. arXiv 1802.08864. Zie ook patent US11853886B2 en mijn DeepSeek-tweet: DeepSeek gebruikt elementen van de 2015 reinforcement learning prompt engineer [7] en de verfijning ervan uit 2018 [8] die de RL-machine en het wereldmodel van [7] samenvouwt tot één net. Dit maakt gebruik van mijn neurale net destillatieprocedure van 1991: een gedestilleerd gedachtegangssysteem.

[9] J.S. Turing oververkocht. Het is echter niet de schuld van Turing. AI Blog (2021, was #1 op Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Intelligente robots zullen gefascineerd zijn door het leven.) F.A.Z., 2015

[11] J.S. bij Falling Walls: het verleden, het heden en de toekomst van kunstmatige intelligentie. Wetenschappelijke Amerikaan, Observaties, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (AI is een enorme kans voor Duitsland.) F.A.Z., 2018

[13] H. Jones. J.S. zegt dat zijn levenswerk niet tot dystopie zal leiden. Forbes Tijdschrift, 2023.

[14] Interview met J.S. Jazzyear, Shanghai, 2024.

[15] J.S. TED talk op TED AI Vienna (2024): Waarom 2042 een belangrijk jaar wordt voor AI. Zie de bijgevoegde videoclip.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Bouw de AI-gestuurde robot voor alle doeleinden!) F.A.Z., 2024

[17] J.S. 1995-2025: De achteruitgang van Duitsland en Japan versus de VS en China. Kunnen robots voor alle doeleinden een comeback maken? AI Blog, januari 2025, gebaseerd op [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Naar een uiterst robuuste babyrobot met rijke interactiemogelijkheden voor geavanceerde machine learning-algoritmen. Voordruk arxiv 2404.08093, 2024.

67,49K

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste