Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

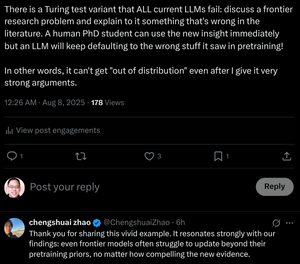

"Dokonce i hraniční modely se potýkají s aktualizací nad rámec předtrénování, bez ohledu na to, jak přesvědčivé jsou nové důkazy."

K tomu školíme doktorandy! Mohou to transformátory udělat bez změny jejich hmotnosti?

8. 8. 07:29

Je řetězové uvažování LLM fata morgánou?

... Naše výsledky ukazují, že uvažování CoT je křehký přelud, který zmizí, když je posunut za hranice distribuce tréninku. Tato práce nabízí hlubší pochopení toho, proč a kdy uvažování CoT selhává, a zdůrazňuje přetrvávající výzvu k dosažení autentického a zobecnitelného uvažování.

... Naše zjištění ukazují, že CoT uvažování funguje efektivně, když je aplikováno na in-distribuci nebo blízko

v distribuci, ale stává se křehkým a náchylným k selhání i při mírných distribučních posunech.

V některých případech LLM generují plynulé, ale logicky nekonzistentní kroky uvažování. Výsledky naznačují, že to, co se zdá být strukturovaným uvažováním, může být fata morgána, vycházející z naučených nebo interpolovaných vzorců v trénovacích datech, spíše než z logické dedukce.

... Společně tato zjištění naznačují, že LLM nejsou principiální uvažovatelé, ale spíše sofistikované simulátory textu podobného uvažování.

12,27K

Top

Hodnocení

Oblíbené