Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

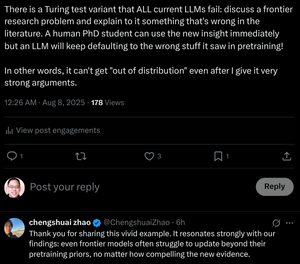

"Mesmo os modelos de fronteira lutam para se atualizar além dos anteriores de pré-treinamento, não importa o quão convincentes sejam as novas evidências."

Treinamos estudantes de doutorado para fazer isso! Os transformadores podem fazer isso sem alterar seus pesos?

8 de ago., 07:29

O raciocínio da cadeia de pensamento dos LLMs é uma miragem?

... Nossos resultados revelam que o raciocínio CoT é uma miragem frágil que desaparece quando é empurrado para além das distribuições de treinamento. Este trabalho oferece uma compreensão mais profunda de por que e quando o raciocínio CoT falha, enfatizando o desafio contínuo de alcançar um raciocínio genuíno e generalizável.

... Nossas descobertas revelam que o raciocínio CoT funciona efetivamente quando aplicado a in-distribution ou near

dados em distribuição, mas torna-se frágil e propenso a falhas, mesmo sob mudanças moderadas de distribuição.

Em alguns casos, os LLMs geram etapas de raciocínio fluentes, mas logicamente inconsistentes. Os resultados sugerem que o que parece ser um raciocínio estruturado pode ser uma miragem, emergindo de padrões memorizados ou interpolados nos dados de treinamento, em vez de inferência lógica.

... Juntas, essas descobertas sugerem que os LLMs não são raciocinadores de princípios, mas sim simuladores sofisticados de texto semelhante ao raciocínio.

12,3K

Melhores

Classificação

Favoritos