Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

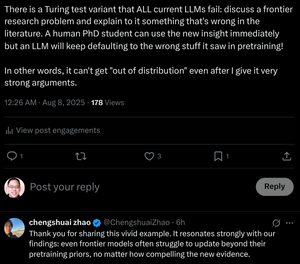

"Nawet modele graniczne mają trudności z aktualizacją poza priorytetami wstępnymi, niezależnie od tego, jak przekonujące są nowe dowody."

Szkolimy doktorantów, aby to robić! Czy transformery mogą to zrobić bez zmiany swoich wag?

8 sie, 07:29

Czy rozumowanie w stylu Chain-of-Thought LLM to miraż?

... Nasze wyniki ujawniają, że rozumowanie CoT to kruchy miraż, który znika, gdy jest popychane poza rozkłady treningowe. Ta praca oferuje głębsze zrozumienie, dlaczego i kiedy rozumowanie CoT zawodzi, podkreślając ciągłe wyzwanie osiągnięcia prawdziwego i uogólnionego rozumowania.

... Nasze odkrycia ujawniają, że rozumowanie CoT działa skutecznie, gdy jest stosowane do danych w rozkładzie lub bliskich rozkładowi.

Staje się jednak kruche i podatne na błędy nawet przy umiarkowanych przesunięciach rozkładu. W niektórych przypadkach LLM generują płynne, ale logicznie niespójne kroki rozumowania. Wyniki sugerują, że to, co wydaje się być strukturalnym rozumowaniem, może być mirażem, wynikającym z zapamiętanych lub interpolowanych wzorców w danych treningowych, a nie z logicznego wnioskowania.

... Razem te odkrycia sugerują, że LLM nie są zasadniczymi rozumującymi, lecz raczej zaawansowanymi symulatorami tekstu przypominającego rozumowanie.

12,99K

Najlepsze

Ranking

Ulubione