Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

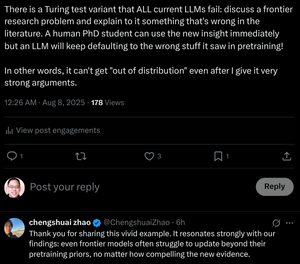

"Zelfs grensmodellen hebben moeite om verder te updaten dan de voorafgaande training, ongeacht hoe overtuigend het nieuwe bewijs is."

Wij leiden PhD-studenten op om dit te doen! Kunnen transformers dit doen zonder hun gewichten te veranderen?

8 aug, 07:29

Is Chain-of-Thought Redeneren van LLMs een Mirage?

... Onze resultaten onthullen dat CoT-redeneren een broze mirage is die verdwijnt wanneer het verder wordt geduwd dan de trainingsdistributies. Dit werk biedt een dieper inzicht in waarom en wanneer CoT-redeneren faalt, en benadrukt de voortdurende uitdaging om oprechte en generaliseerbare redenering te bereiken.

... Onze bevindingen onthullen dat CoT-redeneren effectief werkt wanneer het wordt toegepast op in-distributie of nabij in-distributie gegevens, maar fragiel en kwetsbaar wordt voor falen, zelfs onder gematigde distributieverschuivingen. In sommige gevallen genereren LLMs vloeiende maar logisch inconsistente redeneringsstappen. De resultaten suggereren dat wat lijkt op gestructureerde redenering een mirage kan zijn, voortkomend uit gememoriseerde of geïnterpoleerde patronen in de trainingsdata in plaats van logische inferentie.

... Samen suggereren deze bevindingen dat LLMs geen principiële redenaars zijn, maar eerder geavanceerde simulators van redenering-achtige tekst.

12,28K

Boven

Positie

Favorieten