Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

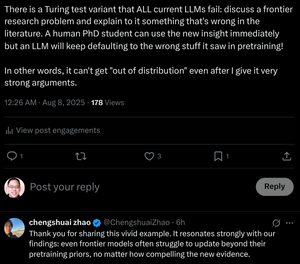

"Till och med gränsmodeller kämpar för att uppdatera bortom tidigare träning, oavsett hur övertygande de nya bevisen är."

Vi utbildar doktorander för att göra detta! Kan transformatorer göra det utan att ändra sina vikter?

8 aug. 07:29

Är LLM:s kedjeresonemang en hägring?

... Våra resultat visar att CoT-resonemang är en skör hägring som försvinner när den pressas bortom träningsfördelningar. Detta arbete ger en djupare förståelse för varför och när CoT-resonemang misslyckas, med betoning på den pågående utmaningen att uppnå genuina och generaliserbara resonemang.

... Våra resultat visar att CoT-resonemang fungerar effektivt när det tillämpas på in-distribution eller nära

data i distributionen, men blir bräcklig och benägen att misslyckas även under måttliga fördelningsförändringar.

I vissa fall genererar LLM:er flytande men ändå logiskt inkonsekventa resonemangssteg. Resultaten tyder på att det som verkar vara strukturerat resonemang kan vara en hägring, som uppstår från memorerade eller interpolerade mönster i träningsdata snarare än logisk slutsats.

... Tillsammans tyder dessa resultat på att LLM:er inte är principiella resonemang utan snarare sofistikerade simulatorer av resonemangsliknande text.

12,3K

Topp

Rankning

Favoriter