Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

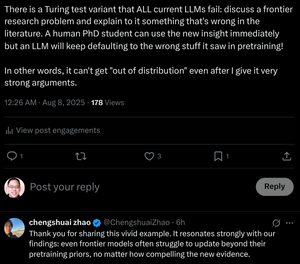

"Incluso los modelos de frontera luchan por actualizarse más allá de los priors de preentrenamiento, sin importar cuán convincente sea la nueva evidencia."

¡Entrenamos a estudiantes de doctorado para hacer esto! ¿Pueden los transformadores hacerlo sin cambiar sus pesos?

8 ago, 07:29

¿Es el razonamiento de cadena de pensamiento de los LLMs un espejismo?

... Nuestros resultados revelan que el razonamiento CoT es un espejismo frágil que desaparece cuando se empuja más allá de las distribuciones de entrenamiento. Este trabajo ofrece una comprensión más profunda de por qué y cuándo falla el razonamiento CoT, enfatizando el desafío continuo de lograr un razonamiento genuino y generalizable.

... Nuestros hallazgos revelan que el razonamiento CoT funciona de manera efectiva cuando se aplica a datos dentro de la distribución o cerca de ella, pero se vuelve frágil y propenso a fallos incluso bajo cambios moderados en la distribución. En algunos casos, los LLMs generan pasos de razonamiento fluidos pero lógicamente inconsistentes. Los resultados sugieren que lo que parece ser un razonamiento estructurado puede ser un espejismo, emergiendo de patrones memorizados o interpolados en los datos de entrenamiento en lugar de una inferencia lógica.

... Juntos, estos hallazgos sugieren que los LLMs no son razonadores con principios, sino más bien simuladores sofisticados de texto similar al razonamiento.

12.3K

Populares

Ranking

Favoritas