Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Погрузитесь в архитектуры GPU @nvidia 🐰 Hopper и ⚙️ Blackwell — последовательные шаги в вычислительной мощности и соединениях для ваших AI задач👇

🐰 Hopper (H100 и H200) представил 4-е поколение Tensor Cores + FP8 Transformer Engine, обеспечивая до 9× более быстрое обучение и 30× более быструю инференцию по сравнению с A100.

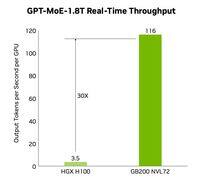

⚙️ Blackwell (B200) — поставки в конце 2024 года — объединяет два кристалла через 10 ТБ/с NV-HBI, добавляет FP4 и использует NVLink-5 для до 30× кластерной инференции.

@nvidia 🐰 Спецификации Hopper

Тензорные ядра: смешанные FP8/FP16/TF32

Память:

- H100 → 80 ГБ HBM3 @ 3.35 ТБ/с

- H200 → 141 ГБ HBM3e @ 4.8 ТБ/с

NVLink: до 900 ГБ/с на GPU

@nvidia 🐰 Хоппер в действии

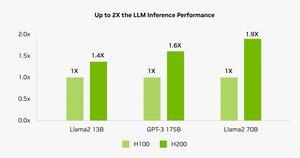

Бенчмарки показывают, что H200 обеспечивает вывод Llama-2 70B на 45–100% быстрее по сравнению с H100.

⚠️ Оба испытывали нехватку поставок в 2023–25 годах.

💻 На облаке Hyperbolic: ВМ H100 и выделенные кластеры с Ethernet + InfiniBand начиная с $1.49/ч. H200 и B200 по мгновенной报价.

@nvidia ⚙️ Blackwell Innovations

- Дизайн чиплетов (TSMC 4NP, 208 млрд транзисторов, 10 ТБ/с NV-HBI)

- 2-е поколение Transformer Engine: FP4 + улучшенный FP8

- NVLink-5: 18 соединений @ 1.8 ТБ/с всего

- Двигатель декомпрессии: 800 ГБ/с CPU↔GPU

- Полный RAS и Конфиденциальные вычисления

📊 Сравнение производительности

H100 SXM: 80 ГБ @ 3.35 ТБ/с, 3.96 PFLOPS (FP8), 1.98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 ГБ/с, 700 Вт

H200 SXM: 141 ГБ @ 4.8 ТБ/с, те же вычислительные PFLOPS/TFLOPS, NVLink 900 ГБ/с, 700 Вт

HGX B200: 180 ГБ @ 7.7 ТБ/с, 9 PFLOPS (FP8), 4.5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1.8 ТБ/с, 1000 Вт

@nvidia ❓ Что такое FLOP?

1 операция с плавающей запятой (сложение/умножение)

1 TFLOP = 10¹² операций в секунду

1 PFLOP = 10¹⁵ операций в секунду = 1000× TFLOP

Эти метрики показывают, насколько быстро графические процессоры обрабатывают огромные вычисления, стоящие за обучением ИИ и высокопроизводительными вычислениями.

@nvidia 🔚 Завершение:

🐰 Hopper установил планку с FP8 смешанной точностью и асинхронными конвейерами.

⚙️ Blackwell продвигает следующее поколение с FP4, большим объемом памяти, NVLink-5.

H100 остается рабочей лошадкой — аренда за $1.49/час.

H200 и B200 доступны по запросу.

@nvidia Читайте полную статью по адресу:

4,77K

Топ

Рейтинг

Избранное