Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Duik in @nvidia 🐰 Hopper vs ⚙️ Blackwell GPU-architecturen—successieve sprongen in rekencapaciteit en interconnecties voor je AI-werkbelastingen👇

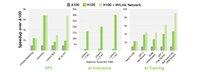

🐰 Hopper (H100 & H200) introduceerde 4e generatie Tensor Cores + een FP8 Transformer Engine, wat tot 9× snellere training en 30× snellere inferentie mogelijk maakt in vergelijking met A100.

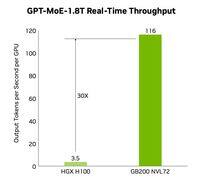

⚙️ Blackwell (B200)—verzending eind 2024—combineert twee chips over een 10 TB/s NV-HBI, voegt FP4 toe en gebruikt NVLink-5 voor tot 30× clusterinferentie.

@nvidia 🐰 Hopper Specificaties

Tensor Cores: gemengd FP8/FP16/TF32

Geheugen:

- H100 → 80 GB HBM3 @ 3,35 TB/s

- H200 → 141 GB HBM3e @ 4,8 TB/s

NVLink: tot 900 GB/s per GPU

@nvidia 🐰 Hopper in actie

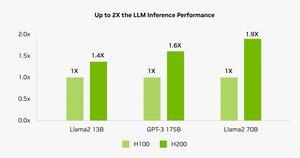

Benchmarks tonen aan dat de H200 Llama-2 70B inferentie 45–100% sneller maakt dan de H100.

⚠️ Beide zagen leveringsproblemen in 2023–25.

💻 Op Hyperbolic’s cloud: H100 VM's & bare-metal clusters met Ethernet + InfiniBand vanaf $1,49/uur. H200 & B200 via directe offerte.

@nvidia ⚙️ Blackwell Innovaties

- Chiplet ontwerp (TSMC 4NP, 208 B transistors, 10 TB/s NV-HBI)

- 2e generatie Transformer Engine: FP4 + verbeterde FP8

- NVLink-5: 18 verbindingen @ 1.8 TB/s totaal

- Decompressie Engine: 800 GB/s CPU↔GPU

- Volledige RAS & Vertrouwelijke Computing

📊 Prestaties Vergelijken

H100 SXM: 80 GB @ 3,35 TB/s, 3,96 PFLOPS (FP8), 1,98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4,8 TB/s, dezelfde compute PFLOPS/TFLOPS, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7,7 TB/s, 9 PFLOPS (FP8), 4,5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1,8 TB/s, 1000 W

@nvidia ❓ Wat is een FLOP?

1 floating-point operatie (optellen vermenigvuldigen)

1 TFLOP = 10¹² ops/s

1 PFLOP = 10¹⁵ ops/s = 1000× een TFLOP

Deze metrics tonen aan hoe snel GPU's de enorme wiskunde achter AI-training en HPC verwerken.

@nvidia 🔚 Afsluiting:

🐰 Hopper heeft de lat gelegd met FP8 gemengde precisie & asynchrone pipelines.

⚙️ Blackwell duwt de volgende generatie met FP4, meer geheugen, NVLink-5.

H100 blijft de krachtpatser—huur via $1.49/uur.

H200 & B200 beschikbaar op aanvraag via

@nvidia Lees het volledige artikel op:

4,77K

Boven

Positie

Favorieten