Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Scufundați-vă în arhitecturile GPU @nvidia 🐰 Hopper vs ⚙️ Blackwell - salturi succesive în puterea de calcul și interconexiuni pentru sarcinile👇 de lucru AI

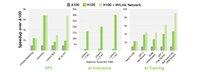

🐰 Hopper (H100 și H200) a introdus nucleele Tensor de generația a 4-a + un motor FP8 Transformator, oferind o instruire cu până la 9× mai rapidă și o inferență cu 30× mai rapidă față de A100.

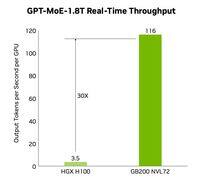

⚙️ Blackwell (B200) - livrat la sfârșitul anului 2024 - împerechează două matrițe pe un NV-HBI de 10 TB/s, adaugă FP4 și folosește NVLink-5 pentru inferența clusterului de până la 30×.

@nvidia 🐰 Specificații buncăr

Miezuri Tensor: mixte FP8 / FP16 / TF32

Memorie:

- H100 → 80 GB HBM3 @ 3.35 TB/s

- H200 → 141 GB HBM3e @ 4.8 TB/s

NVLink: până la 900 GB/s per GPU

@nvidia 🐰 Hopper în acțiune

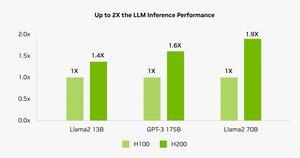

Benchmark-urile arată H200 alimentând inferența Llama-2 70B cu 45-100% mai rapidă față de H100.

⚠️ Ambele au înregistrat crize de aprovizionare în 2023-25.

💻 Pe cloud-ul Hyperbolic: H100 VM-uri și clustere bare metal cu Ethernet + InfiniBand începând de la 1,49 USD/oră. H200 și B200 prin ofertă instantanee.

@nvidia ⚙️ Inovații Blackwell

- Proiectare chiplet (TSMC 4NP, tranzistori 208 B, 10 TB/s NV-HBI)

- Motor Transformer de generația a 2-a: FP4 + FP8 îmbunătățit

- NVLink-5: 18 legături @ 1.8 TB/s în total

- Motor de decompresie: GPU CPU↔de 800 GB/s

- RAS complet și calcul confidențial

📊 Compararea performanței

H100 SXM: 80 GB @ 3,35 TB/s, 3,96 PFLOPS (FP8), 1,98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4,8 TB/s, aceleași PFLOP-uri/TFLOP-uri de calcul, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7,7 TB/s, 9 PFLOPS (FP8), 4,5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1,8 TB/s, 1000 W

@nvidia ❓ Ce este un FLOP?

1 operațiune în virgulă mobilă (adăugare/mul)

1 TFLOP = 10¹² ops/s

1 PFLOP = 10¹⁵ ops/s = 1000× un TFLOP

Aceste valori arată cât de repede GPU-urile procesează matematica masivă din spatele antrenamentului AI și HPC.

@nvidia 🔚 Încheiere:

🐰 Hopper a stabilit ștacheta cu conducte FP8 cu precizie mixtă și asincrone.

⚙️ Blackwell împinge următoarea generație cu FP4, mai multă memorie, NVLink-5.

H100 rămâne calul de povară - închiriere cu 1,49 USD/oră.

H200 și B200 disponibile la cerere prin

@nvidia Citiți articolul complet la:

4,43K

Limită superioară

Clasament

Favorite