Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zanurz się w architekturach GPU @nvidia 🐰 Hopper vs ⚙️ Blackwell—kolejne skoki w mocy obliczeniowej i połączeniach dla Twoich zadań AI👇

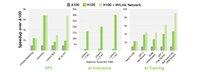

🐰 Hopper (H100 i H200) wprowadza rdzenie Tensor czwartej generacji + silnik transformacyjny FP8, oferując do 9× szybsze szkolenie i 30× szybsze wnioskowanie w porównaniu do A100.

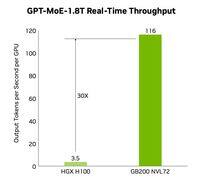

⚙️ Blackwell (B200) — wysyłka pod koniec 2024 roku — łączy dwa układy przez NV-HBI o przepustowości 10 TB/s, dodaje FP4 i wykorzystuje NVLink-5 do 30× wnioskowania w klastrze.

@nvidia 🐰 Specyfikacje Hopper

Rdzenie Tensor: mieszane FP8/FP16/TF32

Pamięć:

- H100 → 80 GB HBM3 @ 3.35 TB/s

- H200 → 141 GB HBM3e @ 4.8 TB/s

NVLink: do 900 GB/s na GPU

@nvidia 🐰 Hopper w akcji

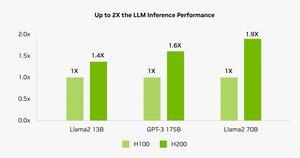

Testy pokazują, że H200 napędza inferencję Llama-2 70B od 45 do 100% szybciej w porównaniu do H100.

⚠️ Oba modele doświadczyły kryzysu dostaw w latach 2023–25.

💻 Na chmurze Hyperbolic: maszyny wirtualne H100 i klastry bare-metal z Ethernetem + InfiniBand zaczynają się od 1,49 USD/godz. H200 i B200 dostępne na podstawie natychmiastowej wyceny.

@nvidia ⚙️ Blackwell Innovations

- Projekt chipletów (TSMC 4NP, 208 B tranzystorów, 10 TB/s NV-HBI)

- Silnik Transformer 2. generacji: FP4 + ulepszony FP8

- NVLink-5: 18 połączeń @ 1.8 TB/s łącznie

- Silnik dekompresji: 800 GB/s CPU↔GPU

- Pełny RAS i Confidential Compute

📊 Porównanie wydajności

H100 SXM: 80 GB @ 3,35 TB/s, 3,96 PFLOPS (FP8), 1,98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4,8 TB/s, ta sama wydajność PFLOPS/TFLOPS, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7,7 TB/s, 9 PFLOPS (FP8), 4,5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1,8 TB/s, 1000 W

@nvidia ❓ Co to jest FLOP?

1 operacja zmiennoprzecinkowa (dodawanie/mnożenie)

1 TFLOP = 10¹² operacji/s

1 PFLOP = 10¹⁵ operacji/s = 1000× TFLOP

Te metryki pokazują, jak szybko GPU przetwarzają ogromne obliczenia związane z treningiem AI i HPC.

@nvidia 🔚 Podsumowanie:

🐰 Hopper ustawił poprzeczkę z FP8 mieszanej precyzji i asynchronicznymi potokami.

⚙️ Blackwell wprowadza nową generację z FP4, większą pamięcią, NVLink-5.

H100 pozostaje koniem roboczym—wynajem za $1.49/godz.

H200 i B200 dostępne na życzenie.

@nvidia Przeczytaj cały artykuł pod adresem:

4,4K

Najlepsze

Ranking

Ulubione