Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tauchen Sie ein in die @nvidia 🐰 Hopper vs ⚙️ Blackwell GPU-Architekturen – aufeinanderfolgende Sprünge in der Rechenleistung und den Interconnects für Ihre KI-Workloads👇

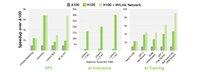

🐰 Hopper (H100 & H200) führte 4. Generation Tensor Cores + einen FP8 Transformer Engine ein, was bis zu 9× schnellere Trainingszeiten und 30× schnellere Inferenz im Vergleich zum A100 ermöglicht.

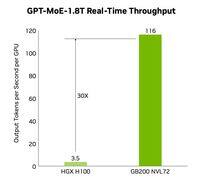

⚙️ Blackwell (B200)—wird Ende 2024 ausgeliefert—kombiniert zwei Chips über ein 10 TB/s NV-HBI, fügt FP4 hinzu und verwendet NVLink-5 für bis zu 30× Cluster-Inferenz.

@nvidia 🐰 Hopper Spezifikationen

Tensor-Kerne: gemischtes FP8/FP16/TF32

Speicher:

- H100 → 80 GB HBM3 @ 3,35 TB/s

- H200 → 141 GB HBM3e @ 4,8 TB/s

NVLink: bis zu 900 GB/s pro GPU

@nvidia 🐰 Hopper in Aktion

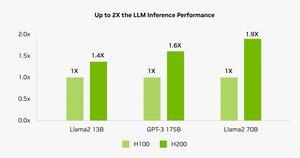

Benchmarks zeigen, dass H200 Llama-2 70B Inferenz 45–100% schneller als H100 antreibt.

⚠️ Beide hatten in den Jahren 2023–25 mit Lieferengpässen zu kämpfen.

💻 Auf Hyperbolic’s Cloud: H100 VMs & Bare-Metal-Cluster mit Ethernet + InfiniBand ab $1,49/Stunde. H200 & B200 über Sofortangebot.

@nvidia ⚙️ Blackwell Innovations

- Chiplet-Design (TSMC 4NP, 208 B Transistoren, 10 TB/s NV-HBI)

- 2. Generation Transformer Engine: FP4 + verbessertes FP8

- NVLink-5: 18 Verbindungen @ 1,8 TB/s insgesamt

- Dekompressions-Engine: 800 GB/s CPU↔GPU

- Vollständiges RAS & Vertrauliches Rechnen

📊 Leistungsvergleich

H100 SXM: 80 GB @ 3,35 TB/s, 3,96 PFLOPS (FP8), 1,98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4,8 TB/s, gleiche Berechnungs-PFLOPS/TFLOPS, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7,7 TB/s, 9 PFLOPS (FP8), 4,5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1,8 TB/s, 1000 W

@nvidia ❓ Was ist ein FLOP?

1 Gleitkommaoperation (Add/Sub)

1 TFLOP = 10¹² ops/s

1 PFLOP = 10¹⁵ ops/s = 1000× ein TFLOP

Diese Kennzahlen zeigen, wie schnell GPUs die massiven Berechnungen hinter dem AI-Training und HPC durchführen.

@nvidia 🔚 Zusammenfassung:

🐰 Hopper hat mit FP8-Mischpräzision und asynchronen Pipelines Maßstäbe gesetzt.

⚙️ Blackwell bringt die nächste Generation mit FP4, mehr Speicher, NVLink-5.

H100 bleibt das Arbeitstier—mieten für $1,49/Stunde.

H200 & B200 auf Anfrage verfügbar.

@nvidia Lesen Sie den vollständigen Artikel unter:

4,71K

Top

Ranking

Favoriten