Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Giganții tehnologici folosesc Multimodal RAG în fiecare zi în producție!

- Spotify îl folosește pentru a răspunde la întrebări muzicale

- YouTube îl folosește pentru a transforma solicitările în melodii

- Amazon Music îl folosește pentru a crea lista de redare din prompt

Să învățăm cum să construim un RAG Agentic Multimodal (cu cod):

Astăzi, vom construi un RAG Agentic multimodal care poate interoga documente și fișiere audio folosind vorbirea utilizatorului.

Stiva tehnologică:

- @AssemblyAI pentru transcriere.

- @milvusio ca DB vectorial.

- @beam_cloud pentru implementare.

- @crewAIInc Fluxuri pentru orchestrare.

Hai să-l construim!

Iată fluxul de lucru:

- Datele introduse de utilizator (audio + documente).

- AssemblyAI transcrie fișierele audio.

- Textul transcris și documentele sunt încorporate în baza de date vectorială Milvus.

- Agentul de cercetare preia informații din interogarea utilizatorului.

- Agentul de răspuns îl folosește pentru a crea un răspuns.

Verificați acest lucru👇

1️⃣ Ingestie de date

Pentru început, utilizatorul furnizează datele de intrare text și audio în directorul de date.

CrewAI Flow implementează logica pentru a descoperi fișierele și a le pregăti pentru procesare ulterioară.

Verificați acest lucru👇

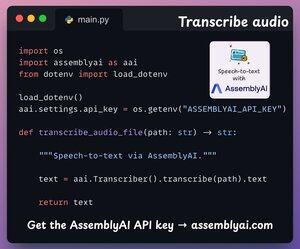

2️⃣ Transcrieți audio

Apoi, transcriem intrarea audio a utilizatorului folosind platforma Speech-to-text de la AssemblyAI.

AssemblyAI nu este open source, dar oferă credite gratuite ample pentru a utiliza modelele lor de transcriere SOTA, care sunt mai mult decât suficiente pentru această demonstrație.

Verificați acest lucru👇

3️⃣ Încorporați datele de intrare

Mergând mai departe, datele de intrare transcrise de la pasul de mai sus și datele de text de intrare sunt încorporate și stocate în baza de date vectorială Milvus.

Iată cum o 👇 facem

4️⃣ Interogare utilizator

Ingestia s-a încheiat.

Acum trecem la faza de inferență!

Apoi, utilizatorul introduce o interogare vocală, care este transcrisă de AssemblyAI.

Verificați acest lucru👇

5️⃣ Preluați contextul

Apoi, generăm o încorporare pentru interogare și extragem cele mai relevante bucăți din baza de date vectorială Milvus.

Așa procedăm 👇

6️⃣ Generați un răspuns

Odată ce avem contextul relevant, echipajul nostru este invocat pentru a genera un răspuns clar și citat pentru utilizator.

Verificați acest lucru 👇

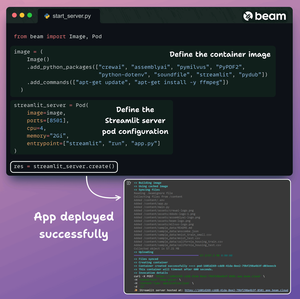

În cele din urmă, împachetăm totul într-o interfață Streamlit curată și implementăm aplicația într-un container fără server folosind Beam.

Importăm dependențele Python necesare și specificăm specificațiile de calcul pentru container.

Și apoi implementăm aplicația în câteva linii de cod👇

Odată implementat, obținem o implementare 100% privată pentru fluxul de lucru Multimodal RAG Agentic pe care tocmai l-am construit.

Verificați această demonstrație 👇

Iată fluxul de lucru pe care l-am implementat:

- Datele furnizate de utilizator (audio + documente)

- AssemblyAI a transcris fișierele audio

- Datele transcrise sunt încorporate în baza de date vectorială

- Agentul de cercetare a preluat informații din interogarea utilizatorului

- Agentul de răspuns l-a folosit pentru a crea un răspuns

Verificați acest lucru👇

Dacă ți s-a părut util, redistribui cu rețeaua ta.

Găsește-mă → @akshay_pachaar ✔️

Pentru mai multe informații și tutoriale despre LLM-uri, agenți AI și învățare automată!

5 aug., 20:30

Giganții tehnologici folosesc Multimodal RAG în fiecare zi în producție!

- Spotify îl folosește pentru a răspunde la întrebări muzicale

- YouTube îl folosește pentru a transforma solicitările în melodii

- Amazon Music îl folosește pentru a crea lista de redare din prompt

Să învățăm cum să construim un RAG Agentic Multimodal (cu cod):

106,44K

Limită superioară

Clasament

Favorite