Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Giganci technologiczni codziennie korzystają z Multimodal RAG w produkcji!

- Spotify używa go do odpowiadania na zapytania muzyczne

- YouTube używa go do przekształcania podpowiedzi w utwory

- Amazon Music używa go do tworzenia playlisty na podstawie podpowiedzi

Nauczmy się, jak zbudować Multimodal Agentic RAG (z kodem):

Dziś zbudujemy multimodalnego agenta RAG, który będzie mógł przeszukiwać dokumenty i pliki audio za pomocą mowy użytkownika.

Stos technologiczny:

- @AssemblyAI do transkrypcji.

- @milvusio jako baza wektorowa.

- @beam_cloud do wdrożenia.

- @crewAIInc Flows do orkiestracji.

Zbudujmy to!

Oto przepływ pracy:

- Użytkownik wprowadza dane (audio + dokumenty).

- AssemblyAI transkrybuje pliki audio.

- Transkrybowany tekst i dokumenty są osadzane w bazie danych wektorowej Milvus.

- Agent badawczy pobiera informacje na podstawie zapytania użytkownika.

- Agent odpowiedzi wykorzystuje je do stworzenia odpowiedzi.

Sprawdź to👇

1️⃣ Wprowadzanie danych

Na początek użytkownik dostarcza dane tekstowe i audio w katalogu danych.

CrewAI Flow wdraża logikę do odkrywania plików i przygotowywania ich do dalszego przetwarzania.

Sprawdź to👇

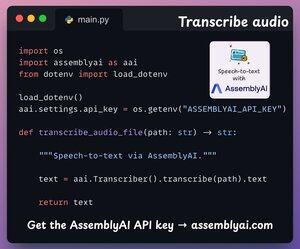

2️⃣ Transkrybuj audio

Następnie transkrybujemy audio użytkownika za pomocą platformy rozpoznawania mowy AssemblyAI.

AssemblyAI nie jest oprogramowaniem open source, ale oferuje wystarczająco dużo darmowych kredytów do korzystania z ich modeli transkrypcyjnych SOTA, które są więcej niż wystarczające do tej demonstracji.

Sprawdź to👇

3️⃣ Osadź dane wejściowe

Przechodząc dalej, przetworzone dane wejściowe z powyższego kroku oraz dane tekstowe są osadzane i przechowywane w bazie danych wektorowej Milvus.

Oto jak to robimy 👇

4️⃣ Zapytanie użytkownika

Ingestia zakończona.

Teraz przechodzimy do fazy wnioskowania!

Następnie użytkownik wprowadza zapytanie głosowe, które jest transkrybowane przez AssemblyAI.

Sprawdź to👇

5️⃣ Pobierz kontekst

Następnie generujemy osadzenie dla zapytania i wyciągamy najbardziej odpowiednie fragmenty z bazy danych wektorów Milvus.

Tak to robimy 👇

6️⃣ Wygeneruj odpowiedź

Gdy mamy odpowiedni kontekst, nasza ekipa jest wzywana do wygenerowania jasnej i cytowanej odpowiedzi dla użytkownika.

Sprawdź to 👇

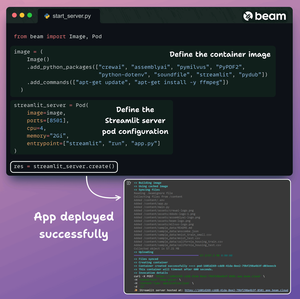

Na koniec wszystko zamykamy w czystym interfejsie Streamlit i wdrażamy aplikację w bezserwerowym kontenerze przy użyciu Beama.

Importujemy niezbędne zależności Pythona i określamy specyfikacje obliczeniowe dla kontenera.

A następnie wdrażamy aplikację w kilku linijkach kodu👇

Po wdrożeniu uzyskujemy 100% prywatne wdrożenie dla wielomodalnego przepływu pracy RAG Agentic, który właśnie zbudowaliśmy.

Sprawdź tę demonstrację 👇

Oto workflow, który wdrożyliśmy:

- Użytkownik dostarczył dane (audio + dokumenty)

- AssemblyAI transkrybował pliki audio

- Transkrybowane dane zostały osadzone w bazie danych wektorowej

- Agent badawczy pobrał informacje z zapytania użytkownika

- Agent odpowiedzi wykorzystał je do stworzenia odpowiedzi

Sprawdź to👇

Jeśli uważasz go za wnikliwy, udostępnij go ponownie w swojej sieci.

Znajdź mnie → @akshay_pachaar ✔️

Aby uzyskać więcej szczegółowych informacji i samouczków na temat LLM, agentów AI i uczenia maszynowego!

5 sie, 20:30

Giganci technologiczni codziennie korzystają z Multimodal RAG w produkcji!

- Spotify używa go do odpowiadania na zapytania muzyczne

- YouTube używa go do przekształcania podpowiedzi w utwory

- Amazon Music używa go do tworzenia playlisty na podstawie podpowiedzi

Nauczmy się, jak zbudować Multimodal Agentic RAG (z kodem):

106,48K

Najlepsze

Ranking

Ulubione