Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Technologische reuzen gebruiken elke dag Multimodal RAG in productie!

- Spotify gebruikt het om muziekvragen te beantwoorden

- YouTube gebruikt het om prompts om te zetten in nummers

- Amazon Music gebruikt het om afspeellijsten te maken op basis van prompts

Laten we leren hoe we een Multimodal Agentic RAG kunnen bouwen (met code):

Vandaag gaan we een multimodale Agentic RAG bouwen die documenten en audiobestanden kan doorzoeken met de spraak van de gebruiker.

Technische stack:

- @AssemblyAI voor transcriptie.

- @milvusio als de vector DB.

- @beam_cloud voor implementatie.

- @crewAIInc Flows voor orkestratie.

Laten we het bouwen!

Hier is de workflow:

- Gebruiker voert gegevens in (audio + documenten).

- AssemblyAI transcribeert de audiobestanden.

- Getranscribeerde tekst & documenten worden ingebed in de Milvus vector DB.

- Onderzoeksagent haalt informatie op uit de gebruikersvraag.

- Reactieagent gebruikt dit om een antwoord te formuleren.

Controleer dit👇

1️⃣ Gegevensinvoer

Om te beginnen, levert de gebruiker de tekst- en audio-invoergegevens in de gegevensdirectory.

CrewAI Flow implementeert de logica om de bestanden te ontdekken en ze klaar te maken voor verdere verwerking.

Bekijk dit👇

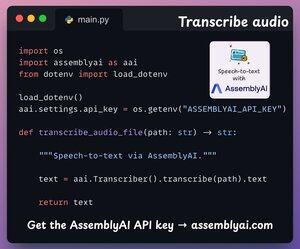

2️⃣ Transcribe audio

Vervolgens transcriberen we de audio-invoer van de gebruiker met behulp van AssemblyAI's Speech-to-text platform.

AssemblyAI is niet open source, maar het biedt voldoende gratis tegoeden om hun SOTA-transcriptiemodellen te gebruiken, die meer dan voldoende zijn voor deze demo.

Bekijk dit👇

3️⃣ Invoergegevens insluiten

Vervolgens worden de getranscribeerde invoergegevens van de bovenstaande stap en de invoertekstgegevens ingesloten en opgeslagen in de Milvus vector DB.

Zo doen we het 👇

4️⃣ Gebruikersvraag

De opname is voorbij.

Nu gaan we naar de inferentiefase!

Vervolgens voert de gebruiker een spraakquery in, die wordt getranscribeerd door AssemblyAI.

Controleer dit👇

5️⃣ Haal context op

Vervolgens genereren we een embedding voor de query en halen we de meest relevante stukken uit de Milvus vector DB.

Zo doen we het 👇

6️⃣ Genereer een antwoord

Zodra we de relevante context hebben, wordt ons Team ingeschakeld om een duidelijk en geciteerd antwoord voor de gebruiker te genereren.

Bekijk dit 👇

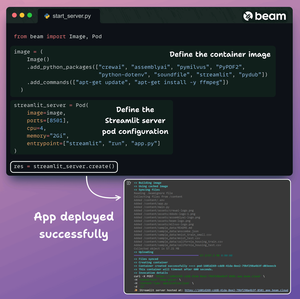

Uiteindelijk bundelen we alles in een schone Streamlit-interface en implementeren we de app in een serverloze container met behulp van Beam.

We importeren de benodigde Python-afhankelijkheden en specificeren de rekenvereisten voor de container.

En dan implementeren we de app in een paar regels code👇

Eenmaal geïmplementeerd, krijgen we een 100% privé-implementatie voor de Multimodale RAG Agentic workflow die we net hebben gebouwd.

Bekijk deze demo 👇

Hier is de workflow die we hebben geïmplementeerd:

- Gebruiker gaf gegevens (audio + documenten)

- AssemblyAI transcribeerde de audiobestanden

- Getranscribeerde gegevens zijn ingebed in de vector DB

- Onderzoeksagent haalde informatie op uit de gebruikersvraag

- Reactieagent gebruikte het om een antwoord te formuleren

Bekijk dit👇

Als je het inzichtelijk vond, deel het dan opnieuw met je netwerk.

Vind me → @akshay_pachaar ✔️

Voor meer inzichten en tutorials over LLM's, AI Agents en Machine Learning!

5 aug, 20:30

Technologische reuzen gebruiken elke dag Multimodal RAG in productie!

- Spotify gebruikt het om muziekvragen te beantwoorden

- YouTube gebruikt het om prompts om te zetten in nummers

- Amazon Music gebruikt het om afspeellijsten te maken op basis van prompts

Laten we leren hoe we een Multimodal Agentic RAG kunnen bouwen (met code):

106,48K

Boven

Positie

Favorieten