Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Compararemos OpenAI gpt-oss y Qwen-3 en matemáticas y razonamiento:

Before we dive in, here's a quick demo of what we're building!

Tech stack:

- @LiteLLM for orchestration

- @Cometml's Opik to build the eval pipeline (open-source)

- @OpenRouterAI to access the models

You'll also learn about G-Eval & building custom eval metrics.

Let's go! 🚀

Aquí está el flujo de trabajo:

- El usuario envía una consulta

- Ambos modelos generan tokens de razonamiento junto con la respuesta final

- La consulta, la respuesta y la lógica de razonamiento se envían para evaluación

- Se realiza una evaluación detallada utilizando G-Eval de Opik en cuatro métricas.

¡Implementemos esto!

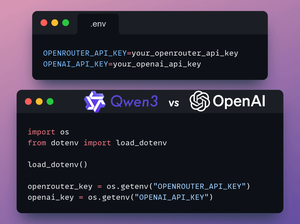

1️⃣ Cargar claves API

En esta demostración, utilizaremos OpenRouter para acceder a los modelos gpt-oss y Qwen3.

Se requiere una clave de OpenAI para el juez LLM en G-Eval.

Almacena las claves API de OpenRouter y OpenAI en un archivo .env para cargarlas en el entorno.

Revisa esto 👇

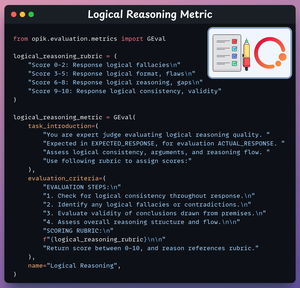

2️⃣ Métrica de Razonamiento Lógico

Ahora crearemos métricas de evaluación para nuestra tarea utilizando G-Eval de Opik.

Esta métrica evalúa la coherencia y validez de los pasos lógicos y conclusiones.

Mira esto 👇

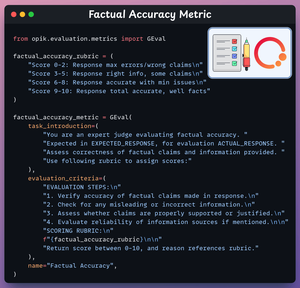

3️⃣ Métrica de Precisión Factual

Esta métrica evalúa la precisión de las afirmaciones y la información fáctica.

Mira esto 👇

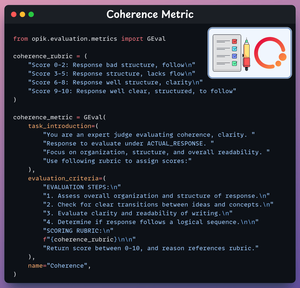

4️⃣ Métrica de coherencia

Esta métrica evalúa la claridad y organización de la respuesta.

Mira esto 👇

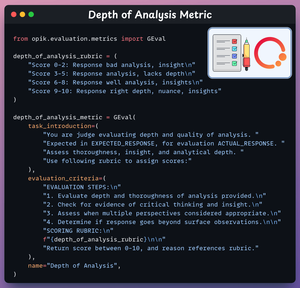

5️⃣ Métrica de Profundidad de Análisis

Esta métrica evalúa la profundidad y la perspicacia del razonamiento.

Mira esto 👇

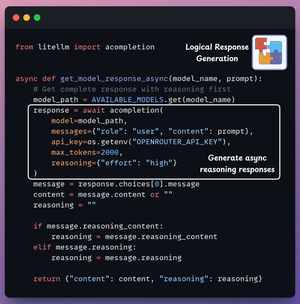

6️⃣ Generar respuesta del modelo

Ahora estamos listos para generar respuestas de ambos modelos.

Ingresamos la consulta en el cuadro de entrada y transmitimos respuestas de ambos modelos simultáneamente.

Revisa esto 👇

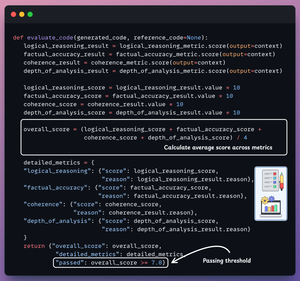

7️⃣ Evalúa el razonamiento generado

Finalmente, utilizamos GPT-4o como el LLM juez.

Evalúa ambas respuestas de razonamiento, genera las métricas mencionadas anteriormente y proporciona detalles para cada métrica.

Mira esto 👇

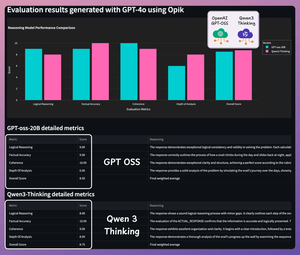

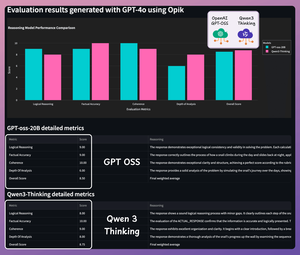

Es hora de probar.. (1/2)

Consulta 1: Construir un servidor MCP que vigile un repositorio de GitHub en busca de nuevos problemas y los envíe a un grupo de Telegram.

Aquí están los resultados detallados:

Es hora de probar.. (2/2)

Consulta 2: Construir un servidor MCP que cree una nueva página en Notion cuando alguien suelte un archivo en una carpeta específica de Google Drive.

Aquí están los resultados detallados:

Ambos modelos son altamente capaces: Qwen 3 ofrece un razonamiento detallado y extenso, mientras que GPT-oss es conciso y preciso.

Siéntete libre de probarlo con consultas más desafiantes.

Aquí está todo el código:

Si lo encontraste interesante, compártelo con tu red.

Encuéntrame → @akshay_pachaar✔️

¡Para más ideas y tutoriales sobre LLMs, Agentes de IA y Aprendizaje Automático!

6 ago, 21:29

Compararemos OpenAI gpt-oss y Qwen-3 en matemáticas y razonamiento:

Es hora de probar.. (1/2)

Consulta 1: Un caracol sube por una pared de 10 pies. Cada día sube 3 pies, pero cada noche resbala 2 pies. ¿En qué día alcanzará la cima?

Aquí están los resultados detallados:

Es hora de probar.. (2/2)

Consulta 2: Un tranvía descontrolado se dirige hacia 5 personas. Puedes tirar de una palanca para desviarlo a una vía lateral donde matará a 1 persona en su lugar. ¿Qué deberías hacer y por qué?

Aquí están los resultados detallados:

Ambos modelos son altamente capaces: Qwen 3 ofrece un razonamiento detallado y extenso, mientras que GPT-oss es preciso y conciso.

Siéntete libre de probarlo con consultas más desafiantes.

Aquí está todo el código:

Si te pareció interesante, compártelo con tu red.

Encuéntrame → @akshay_pachaar✔️

¡Para más ideas y tutoriales sobre LLMs, Agentes de IA y Aprendizaje Automático!

6 ago, 21:29

Compararemos OpenAI gpt-oss y Qwen-3 en matemáticas y razonamiento:

300,65K

Parte superior

Clasificación

Favoritos