Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Comparons OpenAI gpt-oss et Qwen-3 sur les mathématiques et le raisonnement :

Before we dive in, here's a quick demo of what we're building!

Tech stack:

- @LiteLLM for orchestration

- @Cometml's Opik to build the eval pipeline (open-source)

- @OpenRouterAI to access the models

You'll also learn about G-Eval & building custom eval metrics.

Let's go! 🚀

Voici le flux de travail :

- L'utilisateur soumet une requête

- Les deux modèles génèrent des jetons de raisonnement ainsi que la réponse finale

- La requête, la réponse et la logique de raisonnement sont envoyées pour évaluation

- Une évaluation détaillée est réalisée à l'aide de G-Eval d'Opik selon quatre critères.

Mettons cela en œuvre !

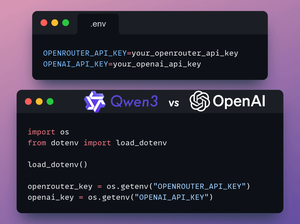

1️⃣ Charger les clés API

Dans cette démo, nous utiliserons OpenRouter pour accéder aux modèles gpt-oss et Qwen3.

Une clé OpenAI est requise pour le juge LLM dans G-Eval.

Stockez les clés API OpenRouter et OpenAI dans un fichier .env pour les charger dans l'environnement.

Vérifiez ceci 👇

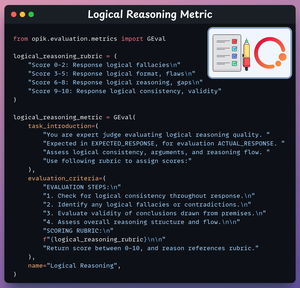

2️⃣ Métrique de Raisonnement Logique

Nous allons maintenant créer des métriques d'évaluation pour notre tâche en utilisant G-Eval d'Opik.

Cette métrique évalue la cohérence et la validité des étapes logiques et des conclusions.

Regardez ça 👇

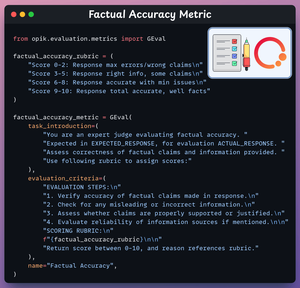

3️⃣ Mesure de l'exactitude factuelle

Cette mesure évalue l'exactitude des affirmations et des informations factuelles.

Découvrez cela 👇

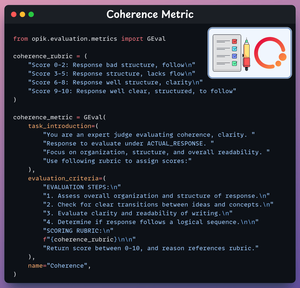

4️⃣ Métrique de cohérence

Cette métrique évalue la clarté et l'organisation de la réponse.

Regardez ça 👇

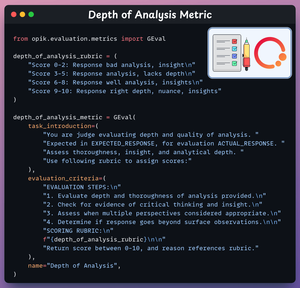

5️⃣ Métrique de profondeur d'analyse

Cette métrique évalue la profondeur et la pertinence du raisonnement.

Regardez ça 👇

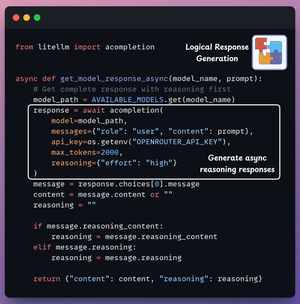

6️⃣ Générer une réponse du modèle

Nous sommes maintenant prêts à générer des réponses des deux modèles.

Nous entrons la requête dans la boîte de saisie et diffusons les réponses des deux modèles simultanément.

Vérifiez ceci 👇

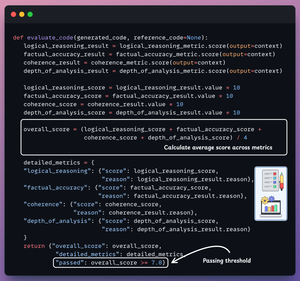

7️⃣ Évaluer le raisonnement généré

Enfin, nous utilisons GPT-4o comme le LLM juge.

Il évalue les deux réponses de raisonnement, génère les métriques mentionnées ci-dessus et fournit des détails pour chaque métrique.

Regardez ça 👇

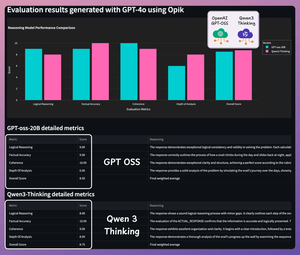

Il est temps de tester.. (1/2)

Requête 1 : Construire un serveur MCP qui surveille un dépôt GitHub pour de nouveaux problèmes et les envoie à un groupe Telegram.

Voici les résultats détaillés :

Il est temps de tester.. (2/2)

Requête 2 : Créer un serveur MCP qui crée une nouvelle page Notion lorsqu'une personne dépose un fichier dans un dossier Google Drive spécifique.

Voici les résultats détaillés :

Les deux modèles sont très performants : Qwen 3 offre un raisonnement détaillé et verbeux, tandis que GPT-oss est précis et concis.

N'hésitez pas à le tester sur des requêtes plus difficiles.

Voici tout le code :

Si vous l'avez trouvé instructif, partagez-le avec votre réseau.

Trouvez-moi → @akshay_pachaar✔️

Pour plus d'informations et de tutoriels sur les LLM, les agents IA et l'apprentissage automatique !

6 août, 21:29

Comparons OpenAI gpt-oss et Qwen-3 sur les mathématiques et le raisonnement :

Il est temps de tester.. (1/2)

Question 1 : Un escargot grimpe sur un mur de 10 pieds. Chaque jour, il grimpe de 3 pieds, mais chaque nuit, il glisse de 2 pieds. Quel jour atteindra-t-il le sommet ?

Voici les résultats détaillés :

Il est temps de tester.. (2/2)

Question 2 : Un trolley en fuite se dirige vers 5 personnes. Vous pouvez tirer un levier pour le dévier vers une voie latérale où il tuera 1 personne à la place. Que devriez-vous faire et pourquoi ?

Voici les résultats détaillés :

Les deux modèles sont très performants : Qwen 3 offre un raisonnement détaillé et explicite, tandis que GPT-oss est précis et concis.

N'hésitez pas à le tester sur des requêtes plus difficiles.

Voici tout le code :

Si vous l'avez trouvé instructif, partagez-le avec votre réseau.

Trouvez-moi → @akshay_pachaar✔️

Pour plus d'informations et de tutoriels sur les LLM, les agents IA et l'apprentissage automatique !

6 août, 21:29

Comparons OpenAI gpt-oss et Qwen-3 sur les mathématiques et le raisonnement :

299,53K

Meilleurs

Classement

Favoris